简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文主要目的是通过一段及其简单的小程序来快速学习python 中sklearn的RandomForest这一函数的基本操作和使用,注意不是用python纯粹从头到尾自己构建RandomForest,既然sklearn提供了现成的我们直接拿来用就可以了,当然其原理十分重要,下面最简单介绍:集成学习是将多个模型进行组合来解决单一的预测问题。它的原理是生成多个分类器模型,各...

前言先说一下写这篇文章的动机,事情起因是笔者在使用pytorch进行多机多卡训练的时候,遇到了卡住的问题,登录了相关的多台机器发现GPU利用率均为100%,而且单卡甚至是单机多卡都没有卡住的现象,这就非常奇怪了。于是乎开始搜索相关的帖子,发现很多帖子虽然也是卡住话题,但是和笔者的情况都不一样,最后开始去查一些国外的帖子以及pytorch github issue等等,发现了类似问题,而且这个问题确

前言:情感分析也是nlp常见的任务之一,这里单独开一篇博客,来罗列一些最新的研究论文,供学习EMNLP 2021 情感分析论文汇总https://mp.weixin.qq.com/s/EA_e2LpFwxMzMgegz7Sq1A欢迎关注笔者公众号,定期更新一些工程上的trick或者前言paper以及代码解读:...

通过本篇我们快速学习了如何使用Qwen2-VL来训练自己的业务,如果大家有类似的需求,可以动手尝试啦~,快去试试吧!咱们下期再见!

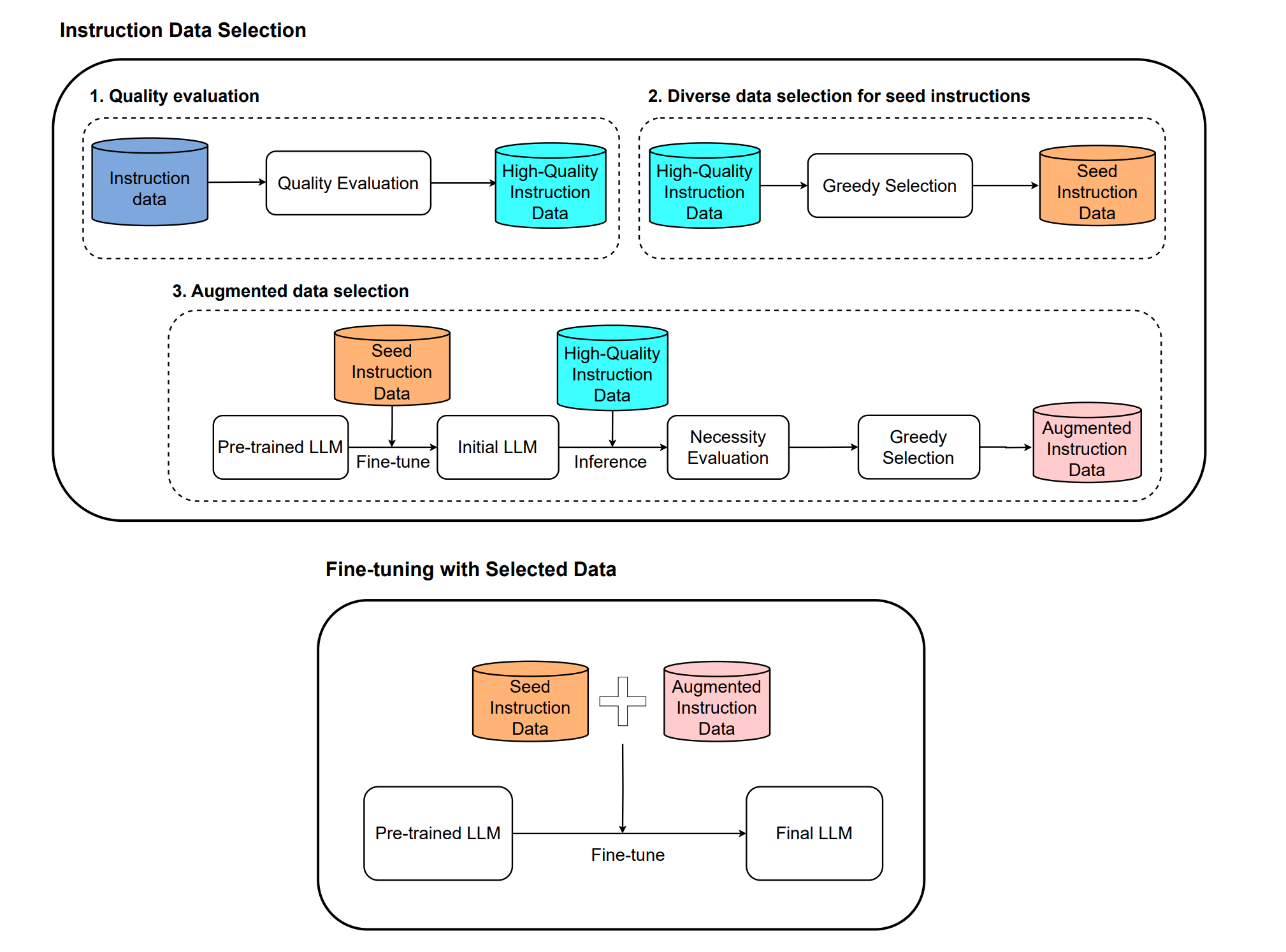

如何得到高质量的SFT数据?

前言有许多场景,我们只有少量样本,而训练网络模型时是需要吃大量数据的,一种方法就是迁移学习,比如预训练模型等方法,但是这里我们从另外一个角度来看看,那就是数据增强,关于数据增强方法已有很多,这里说说一些常见的方法,尤其是最新的(当前时间是2021.1.28)一些方法。传统常见的比如对于文本数据来说,最容易的就是shuffle, drop, 同义词替换,回译,随机插入,等等,这些都是一些最基本的方法

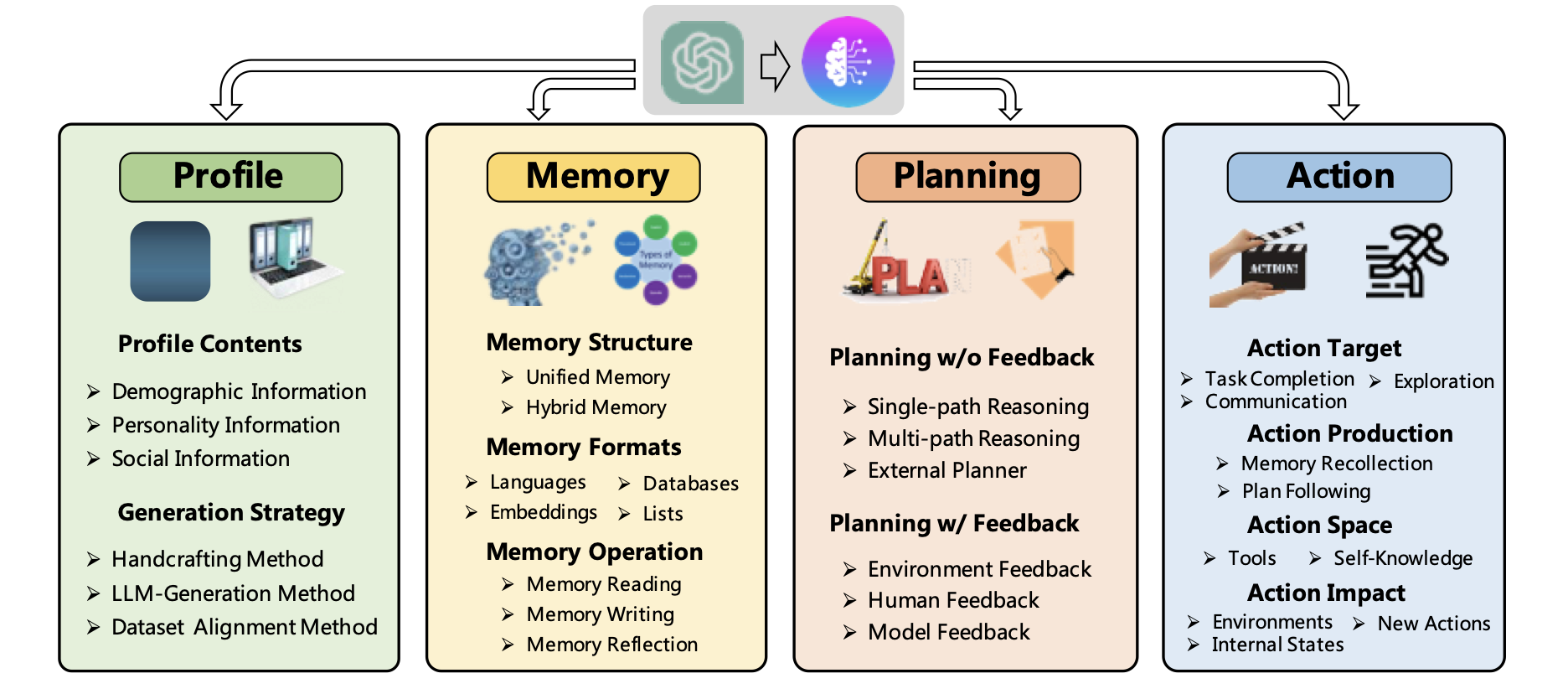

基于大模型的AI 智能体前沿技术

前言数据增强技术相信大家都不陌生,其主要用于扩充数据进而解决数据不平衡、数据稀疏等问题。近年来端到端的语言生成模型被越来越多的应用到数据增强中,其直接生成伪样本供后续模型训练。关于更多的数据增强技术可以看笔者之前的一篇文章:半监督之数据增强关于数据增强那些最新idea,快来看看吧~~https://mp.weixin.qq.com/s/jvgQXhkiqKmJLT3elCphzQ今天要介绍的这篇p

提升大模型的多轮对话能力

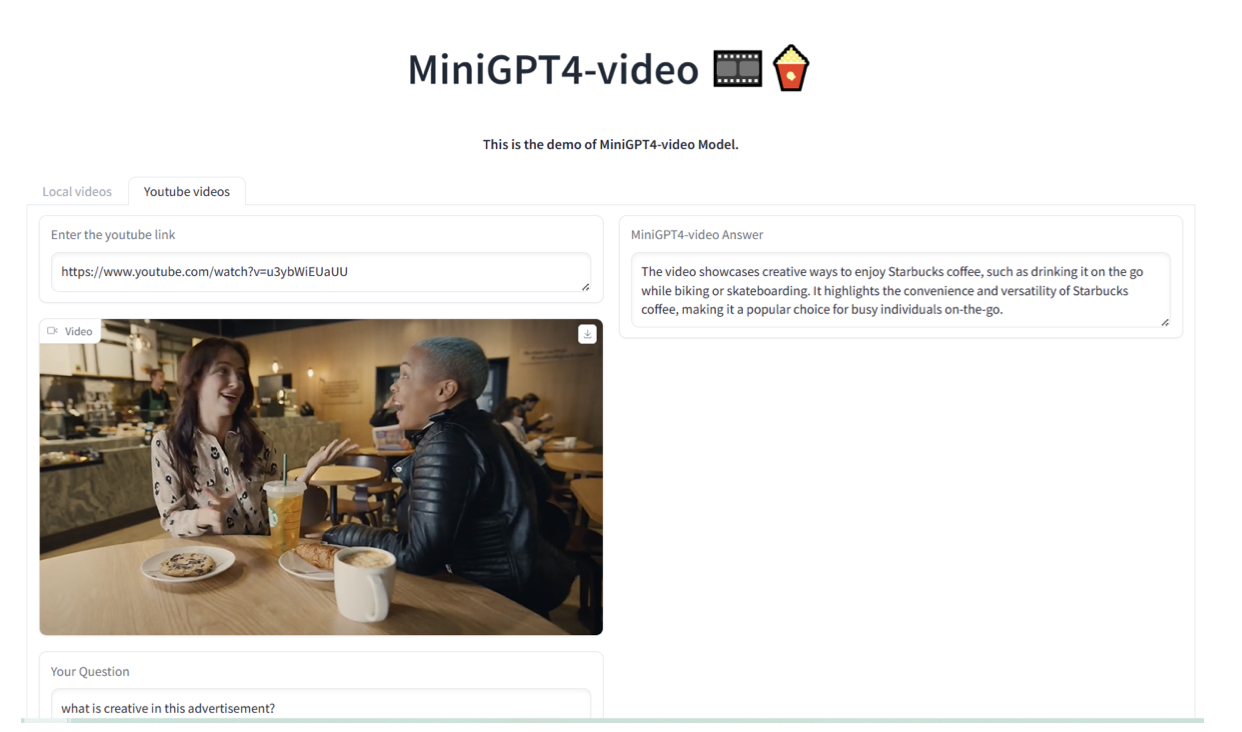

视觉大模型