简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

rasa RedisTrackerStore 连接哨兵

简介参考博客1:基于Tacotron汉语语音合成的开源实践参考博客2:Tacotron中文语音合成通过调研发现,针对TTS的开源项目主要是针对英文的。而中文方面资料相对较少。上面两个为本项目的主要参考,同时感谢乐于分享的博主。使用谷歌提出的Tacotron模型,进行真正端到端的TTS系统。以下是从头实现的步骤以及踩过的坑,正所谓前人栽树后人乘凉,操作步骤step1下载...

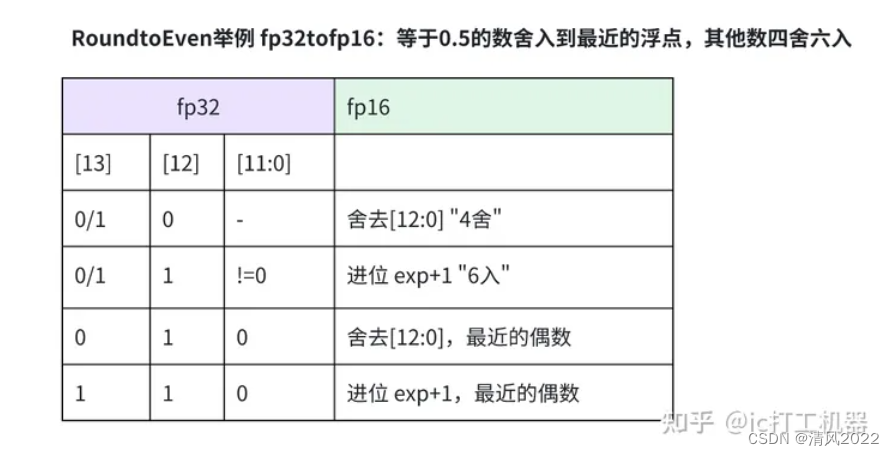

为了减小舍入操作对推理结果的精度影响,AI芯片有时会支持多种舍入模型(round mode)供编程人员选择,常见模式如下表,这一点正如cpu对软件编程舍入模式的支持。因为这是尾数,所以在计算这些二进制和0.5的关系的时候,也即转为10进制的时候,我们用每一位的权重乘以2^(-i)然后求和即可。对正数而言,多余位全为0则直接截尾,不全为0则向最低有效位进1;对负数而言,多余位全为0则直接截尾,不全为

预训练语言模型,如BERT,已被证明在自然语言处理(NLP)任务中非常有效。然而,在训练中对计算资源的需求很高,因此阻碍了它们在实践中的应用。为了缓解大规模模型训练中的这种资源需求,本文提出一种Patient知识蒸馏, 将原始(老师)模型变成同样有效的轻量级浅网络(学生)。以往的知识蒸馏方法:只使用教师网络的最后一层的输出。不同于之前的方法,本文中学生模型耐心地从教师模型的多个中间层中学习,以实现

关于tinyBERT论文的解读已经有很多文章了,本文仅仅说明数据增强的步骤。

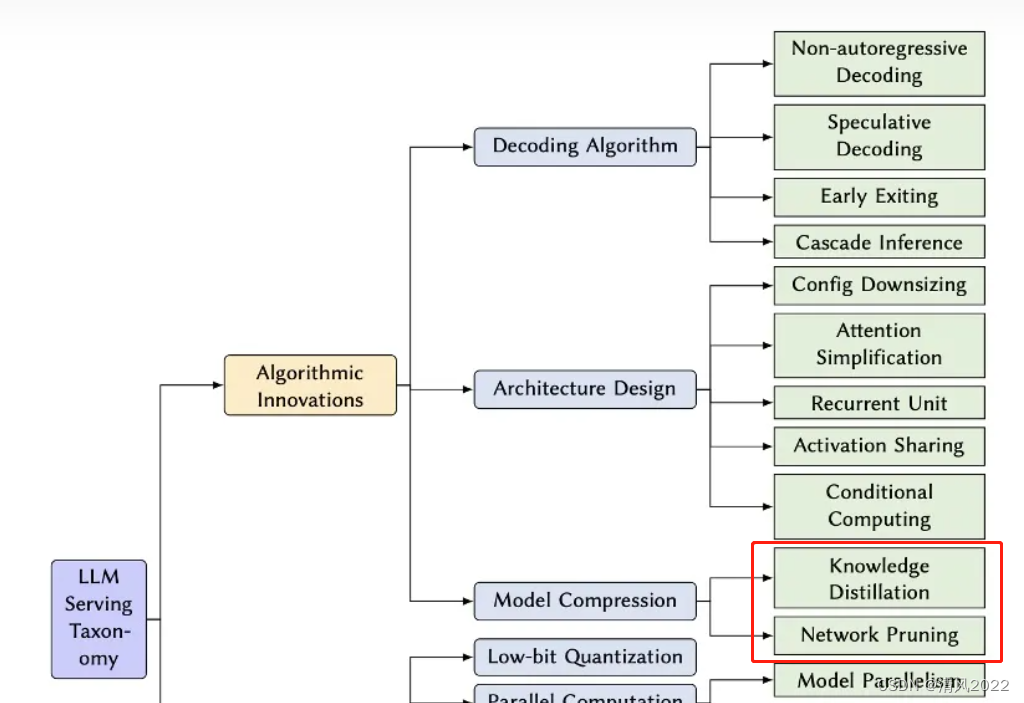

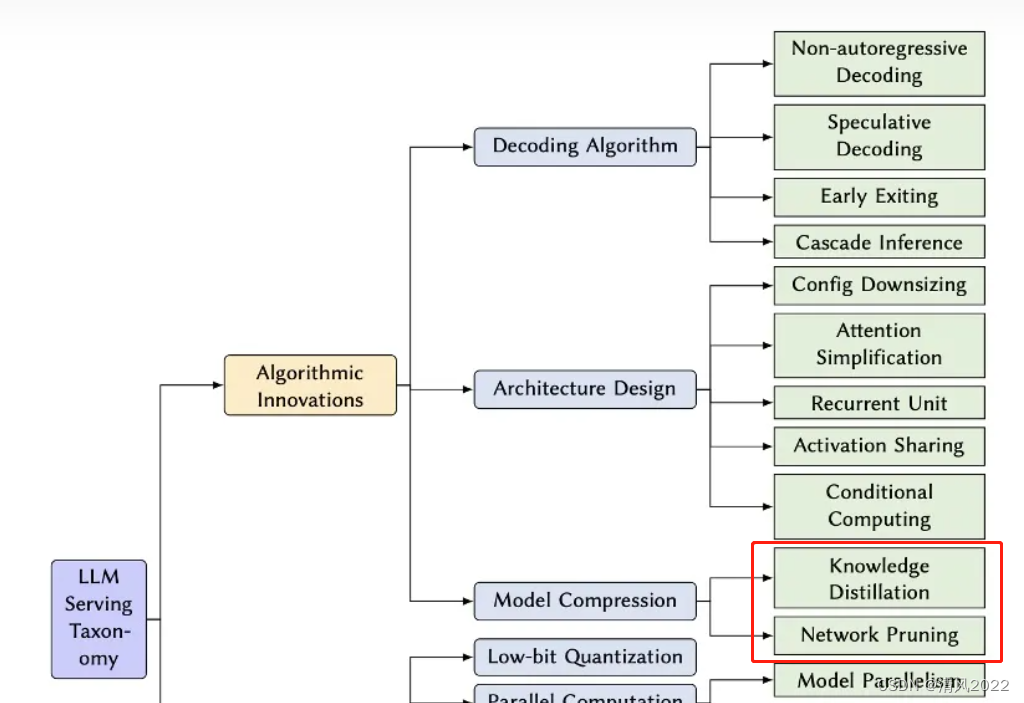

本文说明了 如何对大型语言模型LLMs部署, 常见指标和参数 进行基准测试,以及测试的步骤。使用本指南,LLM应用程序开发人员和企业系统所有者将能够回答以下问题:测量LLM推理延迟和吞吐量最重要的指标是什么?针对LLMs应该使用什么基准测试工具?它们之间的主要区别是什么?如何使用来测试LLM应用程序的延迟和吞吐量?过去几年见证了生成式人工智能和大型语言模型LLMs的普及,作为更广泛的人工智能革命的

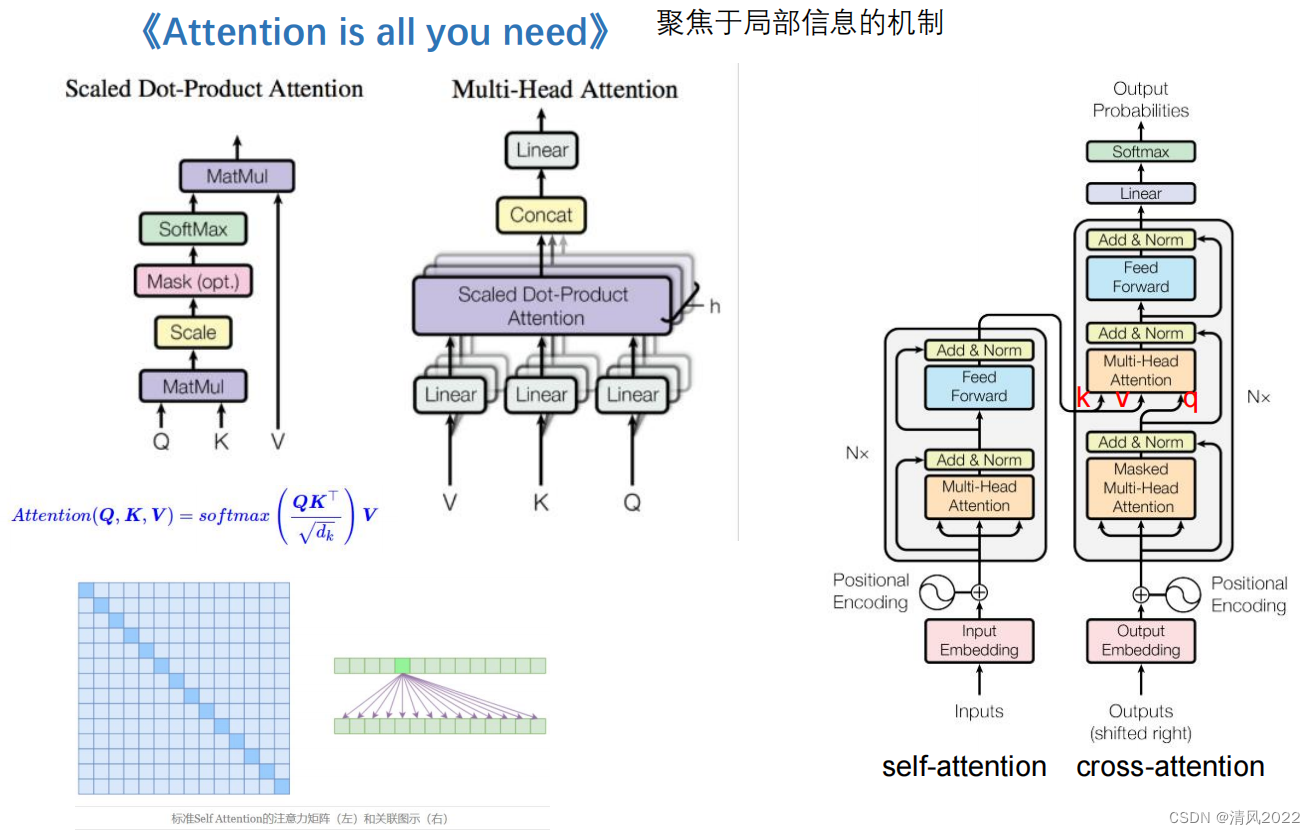

注意力机制,Attention

预训练语言模型,如BERT,已被证明在自然语言处理(NLP)任务中非常有效。然而,在训练中对计算资源的需求很高,因此阻碍了它们在实践中的应用。为了缓解大规模模型训练中的这种资源需求,本文提出一种Patient知识蒸馏, 将原始(老师)模型变成同样有效的轻量级浅网络(学生)。以往的知识蒸馏方法:只使用教师网络的最后一层的输出。不同于之前的方法,本文中学生模型耐心地从教师模型的多个中间层中学习,以实现

本文说明了 如何对大型语言模型LLMs部署, 常见指标和参数 进行基准测试,以及测试的步骤。使用本指南,LLM应用程序开发人员和企业系统所有者将能够回答以下问题:测量LLM推理延迟和吞吐量最重要的指标是什么?针对LLMs应该使用什么基准测试工具?它们之间的主要区别是什么?如何使用来测试LLM应用程序的延迟和吞吐量?过去几年见证了生成式人工智能和大型语言模型LLMs的普及,作为更广泛的人工智能革命的

本文说明了 如何对大型语言模型LLMs部署, 常见指标和参数 进行基准测试,以及测试的步骤。使用本指南,LLM应用程序开发人员和企业系统所有者将能够回答以下问题:测量LLM推理延迟和吞吐量最重要的指标是什么?针对LLMs应该使用什么基准测试工具?它们之间的主要区别是什么?如何使用来测试LLM应用程序的延迟和吞吐量?过去几年见证了生成式人工智能和大型语言模型LLMs的普及,作为更广泛的人工智能革命的