简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

分布式机器学习(distributed machine learning),是指利用多个计算/任务节点(Worker)协同训练一个全局的机器学习/深度学习模型(由主节点(Master)调度)。需要注意的是,分布式机器学习和传统的HPC领域不太一样。传统的HPC领域主要是计算密集型,以提高加速比为主要目标。而分布式机器学习还兼具数据密集型特性,会面临训练数据大(单机存不下)、模型规模大的问题。此外,

YOLOV5-断点训练/继续训练。

计算量对应我们之前的时间复杂度,参数量对应于我们之前的空间复杂度,这么说就很明显了也就是计算量要看网络执行时间的长短,参数量要看占用显存的量注意全大写,是floating point operations per second的缩写,意指每秒浮点运算次数,理解为计算速度。是一个衡量硬件性能的指标。注意s小写,是floating point operations的缩写(s表复数),意指浮点运算数,理

博主根据在机器学习岗位上的一些面试的经验,总结出机器学习岗位上简历应该关注的5个重点。

ML竞赛平台推荐一、前言二、国内外最主流平台1. Kaggle2. 天池三、国内其他主要平台四、国外其他主要平台五、大/中厂竞赛六、其他平台1. Numerai平台一、前言如果你从事研发岗,especially机器学习算法岗,丰富自己简历有三个方法,一是发paper,二是参加项目。最后就是参加网上的竞赛:参与机器学习的竞赛是一个不错的选择。在高质量的比赛中,拿到top名次可以让你的简历眼前一亮本文

一、原因:根本原因就是GPU配置不够,导致报错二、解决办法1修改yolov5代码,修改文件在 yolov5\utils\datasets.py修改参数 num_workers为0但是这样会带来一个问题,就是速度慢了很多,在训练的时候三、解决办法1ctrl + q 搜索:“查看高级系统设置”点击 高级——设置点击高级——更改再点击工程所在的盘——自定义大小(depend on 你的磁盘有多少空余,可

所有不同层数的ResNet:这里给出了我认为比较详细的ResNet18网络具体参数和执行流程图:这里并未采用BasicBlock和BottleNeck复现ResNet18具体ResNet原理细节这里不多做描述,直接上代码model.py网络模型部分:train.py训练部分(使用CIFAR10数据集):3. 训练测试结果训练损失:每一个epoch结束之后的测试:训练时多次修改超参数,最后经过30次

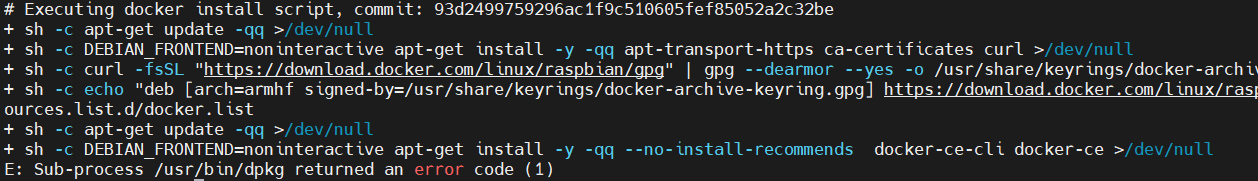

一、卸载旧版本sudo apt-get remove docker docker-engine docker.io containerd runcsudo apt-get purge docker-ce docker-ce-cli containerd.iosudo rm -rf /var/lib/dockersudo rm -rf /var/lib/containerdhint:apt-get报

人们为了从外界获取信息,必须借助于感觉器官。而单靠人们自身的感觉器官,在研究自然现象和规律以及生产活动中它们的功能就远远不够了。为适应这种情况,就需要传感器。因此可以说,传感器是人类五官的延长,又称之为电五官。在现代工业生产尤其是自动化生产过程中,要用各种传感器来监视和控制生产过程中的各个参数,使设备工作在正常状态或最佳状态,并使产品达到最好的质量。因此可以说,没有众多的优良的传感器,现代化生产也

即单位时间所做功,时(h、小时)是时间,二者相乘即功或功耗。瓦等于电压(v、伏特)乘以电流(i、安培)。的单位是瓦时或千瓦时,瓦(w)是。