简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文总结了5种常见的位置编码方式及其特点:1) Sinusoidal(固定正弦编码,适用于NLP);2) Learnable(可学习参数,适合推荐/视频任务);3) Random buffer(随机固定编码,用于图像分割);4) RoPE(旋转编码,支持相对位置,适用于大语言模型);5) 2D Spatial(二维编码,适用于图像任务)。每种方法都从论文出处、设计动机、核心原理和应用场景进行解析,

GRPO(群组相对策略优化)改进了传统 PPO 强化学习,避免了额外的值函数近似计算,使用多个采样输出的平均奖励作为基线,提高 LLM 训练稳定性。迭代 GRPO 通过重放机制持续优化奖励模型。DeepSeekMath-RL 7B 训练基于 GSM8K 和 MATH 数据,强化链式思维推理,取得 88.2% 和 51.7% 的高准确率,超越多个开源及封闭模型。实验表明,GRPO 可提升 LLM 在

版权声明:本文为博主原创文章,遵循 CC 4.0 by-sa 版权协议,转载请附上原文出处链接和本声明。...

转自:https://blog.csdn.net/qq_34374211/article/details/81018320原因:没有设置 CUDA环境变量!解决方法:步骤一:在PATH中加入cudasudo gedit~/.bashrc在末尾加入:export PATH=/usr/local/cuda/bin${PATH:+:${PATH}}export...

我在使用 transformers.Trainer 训练我的模型时,我自定义了 compute_loss 函数和compute_metrics函数,我的模型是一个简单的二分类模型。这里当 outputs 不是字典时,会把第一个位置的元素offset掉。

Flow-Guided Feature Aggregation for Video Object Detection用于视频对象检测的流引导特征聚合译文:摘要:将最先进的对象探测器从图像扩展到视频是一个挑战。检测的准确性受到视频中物体外观退化的影响,如运动模糊、视频散焦、姿态罕见等。现有的工作试图利用box level的时间信息,但这些方法没有经过端到端的训练。我们提出了一种用于视...

本文总结了5种常见的位置编码方式及其特点:1) Sinusoidal(固定正弦编码,适用于NLP);2) Learnable(可学习参数,适合推荐/视频任务);3) Random buffer(随机固定编码,用于图像分割);4) RoPE(旋转编码,支持相对位置,适用于大语言模型);5) 2D Spatial(二维编码,适用于图像任务)。每种方法都从论文出处、设计动机、核心原理和应用场景进行解析,

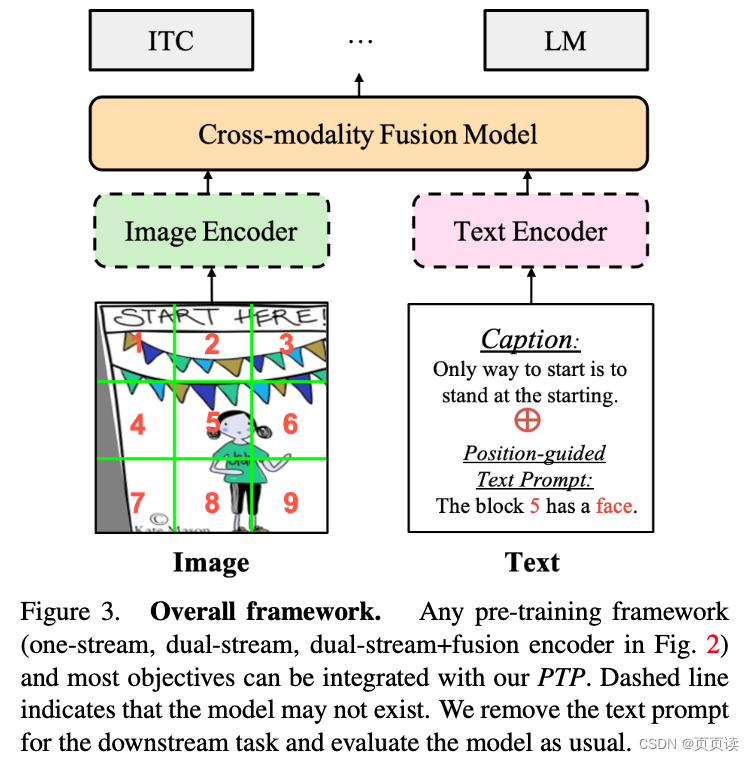

通过将PTP引入多个先进的VLP框架中,我们观察到在代表性的跨模态学习模型架构和多个基准测试中都取得了显著的改进。例如,PTP在MSCOCO数据集的图像-文本检索任务中,相对于ViLT基线,平均回忆率提高了5.3%,并且在类似的框架和数据量下取得了与ALBEF接近的结果。就是借助于检测模型和现有的caption模型对各个block进行简单的caption并生成这种固定格式的 prompt,帮助模型

在github/gitlab上下载单个文件参考自:这里mkdir mycodecd mycodegit initgit remote add -f origin xxx.git #xxx是要下载的仓库git config core.sparsecheckout true。# 将sparsecheckout设为trueecho 仓库名/子文件夹/要下载的文件名(不带后缀) >> .git

完整代码见最后!一、(test_net函数)对测试img进行推断并保存测试后的结果首先是先将测试数据集送入net进行推断出来detections,存入det_file为pickle文件,这是为了再次评测的时候,如果网络没变的话就直接从pickle中取出上次推断的结果进行评测就好了。代码:def test_net(save_folder, net, cuda, dataset,...