简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

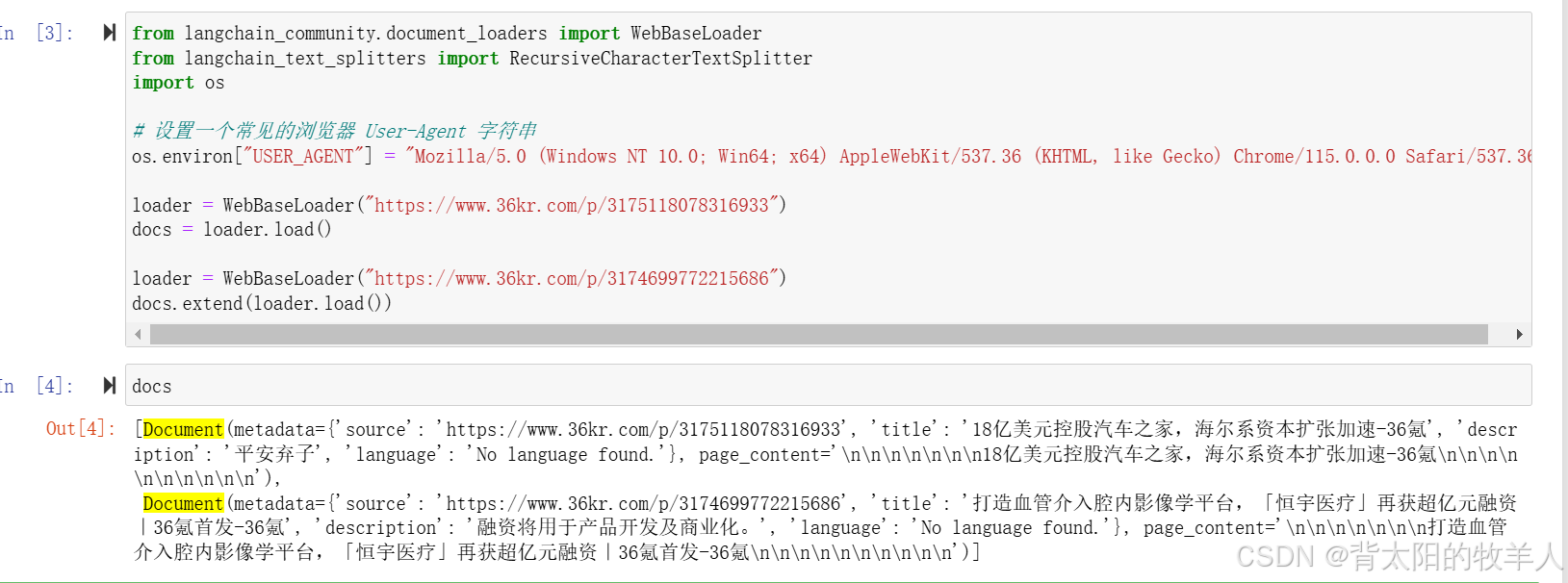

**利用 LangChain 进行多向量索引(Multi-representation Indexing)**,通过从网页爬取文章,生成摘要,并使用向量数据库(Chroma)存储摘要,同时维护原始文档的存储,以便实现高效检索。

配置 OpenAI API 和向量数据库。检查或创建集合。从 CSV 加载数据并生成嵌入。将嵌入数据存入向量数据库。嵌入用户问题,查询向量数据库。使用语言模型基于查询结果生成回答。

这样做的好处是根据不同需求,用户可以选择最适合的格式。例如,如果你需要进一步使用 NumPy 进行数学运算,那么保留数组格式可能更方便;但如果你需要将结果 JSON 序列化为字符串,则列表格式更容易处理。),它包含了模型生成的嵌入向量。这种数组在进行数值计算时非常高效,但在某些场景下(比如序列化、调试或与其他不支持 NumPy 数组的库交互时)可能更适合用 Python 的内置列表(总的来说,这段

Milvus系统的资源管理架构分为三层:查询节点(底层执行单元)、资源组(逻辑资源调度单元)和数据库(数据存储逻辑单元)。查询节点是实际执行向量检索的计算实例,运行在物理机或容器中;资源组将查询节点分组管理,实现不同优先级或租户的资源隔离;数据库作为顶层逻辑存储单元,通过绑定特定资源组来分配计算资源。这种分层架构类比图书馆系统(管理员组-分馆-书架),支持多租户场景下的资源隔离与优先级调度,例如为

你要做的任务遇到的痛点这段代码怎么帮你解决拆分长文本成句子字符切不准、token对不上用 tokenizer 精准对齐 token 和字符模型只能吃 512 个 token,需要提前分块按句号切分,每句都是一小段多语言混合(中英)标点不同、空格不同,直接切会错用处理 token 对应位置检索问答 / RAG需要句子粒度的上下文每个 chunk 都是语义完整的句子回溯文本原文需要定位哪个句子被用了提

摘要 端口映射是Docker容器与宿主机通信的关键机制,通过宿主机端口:容器端口的配置方式,将容器内部服务暴露给外部访问。它以"门"为比喻,形象说明了端口映射的桥梁作用。常见应用场景包括数据库服务(如MongoDB 27017端口)、Web服务(如前端3000端口)等。通过docker-compose配置端口后,可使用curl或浏览器测试验证,如curl http://loca

摘要: Hugging Face的AutoTokenizer和AutoModelForSequenceClassification并非适用于所有模型,需根据任务类型匹配对应类。 ✅ 可用场景:AutoModelForSequenceClassification仅支持文本分类模型(如情感分析)。 ❌ 限制:加载非分类模型(如GPT-2)会报错,需改用其他类(如生成任务用AutoModelForCau

在 LangGraph 的设计中,节点的定义并没有严格要求必须是某一种形式。也就是说,有的节点可以是一个可调用的函数(方法),而有的节点可以直接是一个字典对象。关键在于这两种形式最终都能为图引擎提供一个状态更新的字典。下面详细说明:1. **方法节点:**- 方法节点是一个函数,它接收当前状态(state)作为输入,并动态计算返回一个更新的字典。- 这种方式适用于那些需要根据输入状态动态生成输出的

分页优化器通过把优化器的一部分内存(比如动量、方差)放到CPU内存中,减少了GPU内存的占用,只在需要时才把它们从CPU内存转移到GPU内存。这样做能够减轻GPU的内存负担,提高内存使用效率,特别是在训练大模型时。优化器的状态(例如动量和方差)是优化器用来帮助模型训练的“记忆”信息,它们在训练过程中不断更新,帮助模型更快、更稳定地收敛到最优解。我们可以通过动量和方差来更好地理解这一过程。动量:优化

QLoRA 其实是一种结合了量化和 LoRA 微调技术的统一方法,而不是同时使用两种不同的微调方式。换句话说,QLoRA 的意思就是:先把大模型的主权重用低精度(例如 4-bit)量化,从而大幅减少存储需求;然后在此基础上,通过 LoRA 技术,仅对少部分参数(比如 1%)进行微调,这部分参数保留在较高的精度(例如 FP16)