简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

DevOps 的概念在软件开发行业中逐渐流行起来。越来越多的团队希望实现产品的敏捷开发,DevOps 使一切成为可能。有了 DevOps ,团队可以定期发布代码、自动化部署、并将持续集成 / 持续交付作为发布过程的一部分。虽然 DevOps 背后有各种各样的概念,但幸好有一些工具可以让你更容易地理解和实现。在本文中,你将了解这些工具,并将它们作为软件发布 / 维护工具包工作的一部分开始使用。Dev

是一种用于大语言模型强化学习的算法,本项目实现了一个简化但高效的GRPO训练框架。分离式架构:训练模型、参考模型和生成模型分别运行在不同的GPU上高效内存管理:通过DeepSpeed Zero-2优化,支持在单张80G GPU上训练7B模型快速收敛:在30步内即可观察到"Aha moment"现象本项目实现的GRPO算法具有以下特点:✅简洁高效:仅200行核心代码,易于理解和修改✅内存友好:分离式

KITTI数据集由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办,是目前国际上最大的自动驾驶场景下的计算机视觉算法评测数据集。该数据集用于评测立体图像(stereo),光流(optical flow),视觉测距(visual odometry),3D物体检测(object detection)和3D跟踪(tracking)等计算机视觉技术在车载环境下的性能。KITTI包含市区、乡村和高速公路等

吴恩达老师曾经说过,看一篇论文的关键,是复现作者的算法。然而,很多论文根本就复现不了,这是为什么呢?一、数据关系因为作者使用的数据比较私密,一般人拿不到,这种情况下,即使作者提供了源代码,但是读者却拿不到数据,也就没法复现算法。这种情况在国内学术界很普遍,数据别人没有,这就好像一位奥数老师,自己出了一道奥数题,自己解答出来,然后把解题过程写了论文,这类论文往往说服力不够,故事性不够强。二、硬件原因

mAP(mean Average Precision)是用来衡量目标检测模型在多个类别上的整体表现的指标,主要关注模型的准确性(Precision)和全面性(Recall)。FPS(Frames Per Second)是衡量目标检测模型处理图像速度的指标,主要关注模型的实时性。希望这个解释对你理解目标检测的评测指标有所帮助!

网络训练时和网络评估时,BatchNorm模块的计算方式不同。如果一个网络里包含了BatchNorm,则在训练时需要先调用train(),使网络里的BatchNorm模块的training=True(默认是True),在网络评估时,需要先调用eval()使网络的training=False。

一、概述PageRank算法又称网页排名算法,是一种由搜索引擎根据网页(节点)之间相互的超链接进行计算的技术,用来体现网页(节点)的相关性和重要性。如果一个网页被很多其他网页链接到,说明这个网页比较重要,也就是其PageRank值会相对较高。如果一个PageRank值很高的网页链接到其他网页,那么被链接到的网页的PageRank值会相应地提高。适用场景:PageRank算法适用于网页排序、社交网络

Java架构师-分布式(三):分布式文件系统-FastDFS+阿里OSS

Neo4j提供了强大的算法库,可供我们直接调用,而不需要自己再手动编写。要使用其自带的算法库,首先需要添加相应插件,下面详细介绍。PageRankArticleRankBetweenness CentralityCloseness CentralityHarmonic CentralityEigenvector CentralityDegree CentralityLouvainLabel Pro

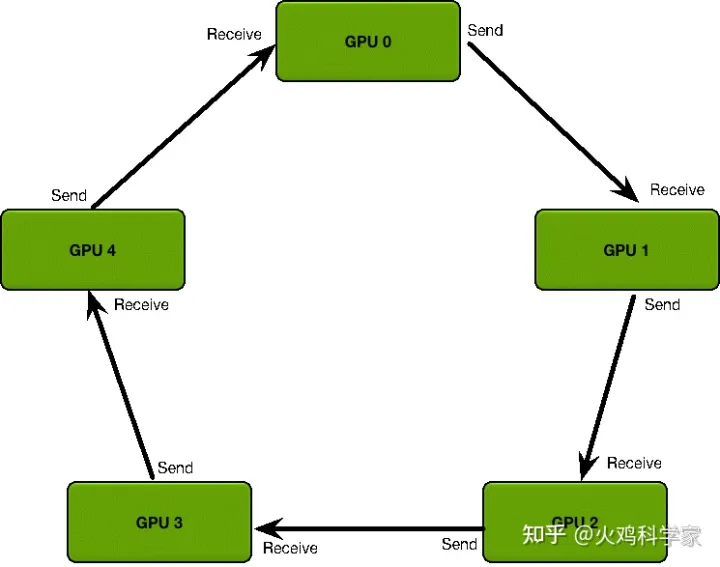

DP模型的基本思路是将数据/Batch分发到不同机器,在Forward过程将模型复制,数据分batch后分发给不同的GPU,最后由主GPU gather所有的输出;对于大型的DL任务,需要添加大量的工程化步骤,如hyperparams的管理,系统状态的监控等。如果是多机多卡就表示对应第几台机器,如果是单机多卡,由于一个进程内就只有一个 GPU,所以 rank 也就表示第几块 GPU。问题,主GPU