简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

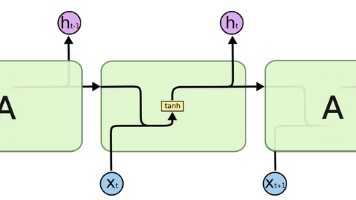

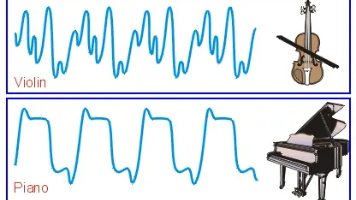

前言:前文介绍了RNN概念及其分类,本文讲解传统RNN。

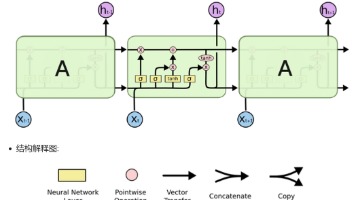

前言:前面文章分享了传统RNN,此次分享传统RNN变体:LSTM和GRU。

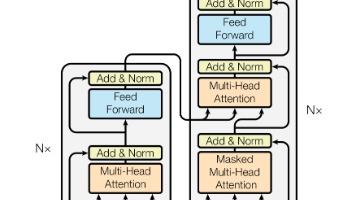

前言:紧接着上文的Transformer各子模块作用分享,本文继续特别分享Transformer中残差连接(Residual Connection)的作用。

前言:在上一篇《详解Bert模型》中,我们了解了BERT如何凭借双向Transformer和预训练-微调范式革新了自然语言处理领域。但故事并未结束。BERT的成功点燃了研究社区的热情,催生出了一个庞大而充满活力的“BERT家族”。这些变体针对BERT的某些局限性,或在特定方向上进行优化,推动了NLP技术的边界。

前言:前面分享了RNN,这篇文章开始讲解注意力机制。

目前豆包(Doubao)已经集成了 **Seedream 4.0 图像模型**,支持“一句话”完成多种修图任务。

前言:本文分享一篇探究歌声风格转换的论文,全文五页,只提供第一页的英文及其翻译,详情请移步,链接:https://arxiv.org/abs/2509.15629v12025年歌声转换挑战赛:从歌手身份转换到演唱风格转换We present the findings of the latest iteration of the Singing Voice Conversion Challenge,

前一篇文章介绍了PyTorch概念,此次介绍PyTorch的。

前言:Transformer,这一在人工智能领域掀起惊涛骇浪的架构,自2017年谷歌团队发表《Attention Is All You Need》论文诞生以来,便以迅雷不及掩耳之势席卷全球,成为AI发展史上浓墨重彩的一笔。它究竟有何魔力,能让全球开发者为之疯狂,让AI技术焕发新生?今天,就让我们一同揭开Transformer的神秘面纱,探寻其优势所在。