简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

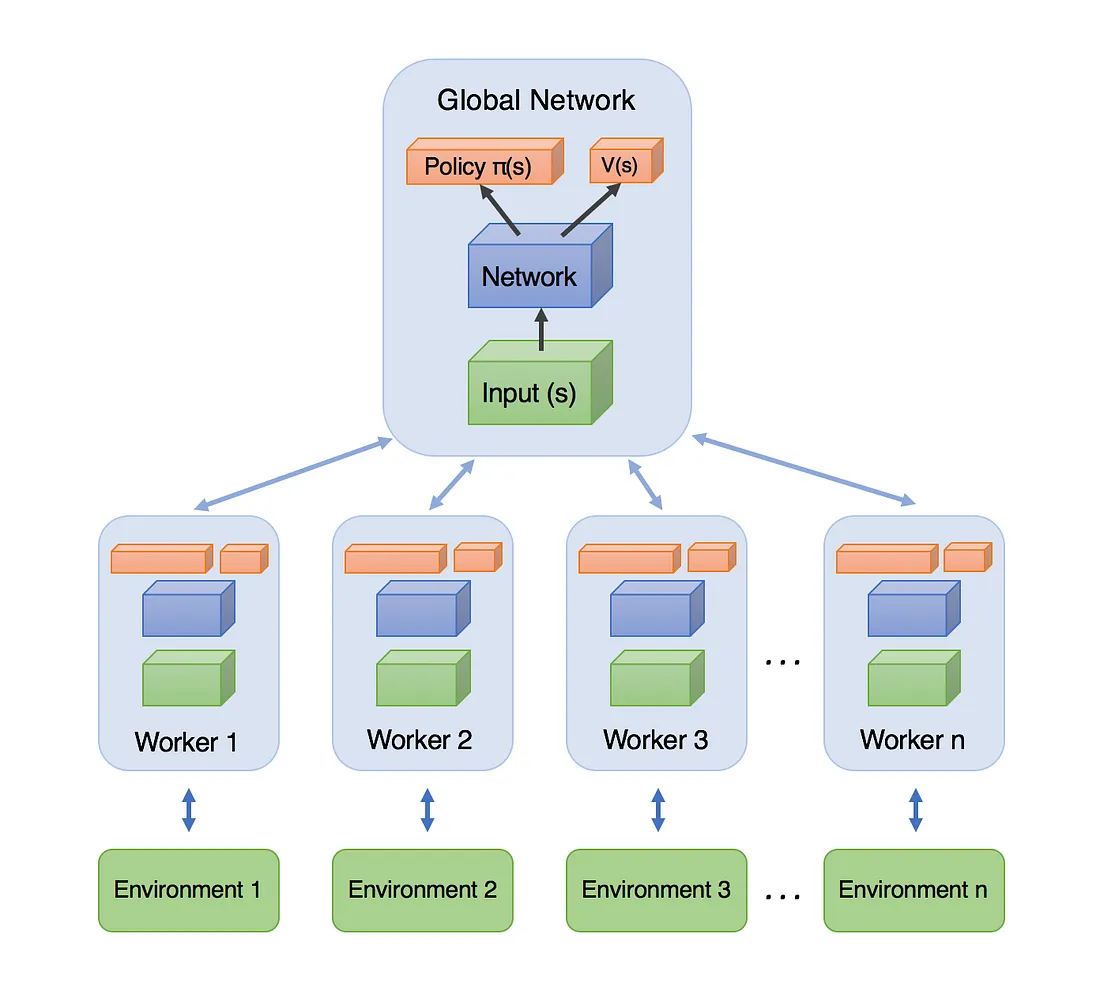

A3C算法()于2016年被谷歌DeepMind团队提出。A3C是一种非常有效的深度强化学习算法,在围棋、星际争霸等复杂任务上已经取得了很好的效果。接下来,我们先从A3C的名称入手,去解析这个算法。A3C代表了异步优势动作评价(Asynchronous Advantage Actor Critic):因为算法涉及并行执行一组环境。与DQN不同,DQN中单个神经网络代表的单个智能体与单个环境交互,而

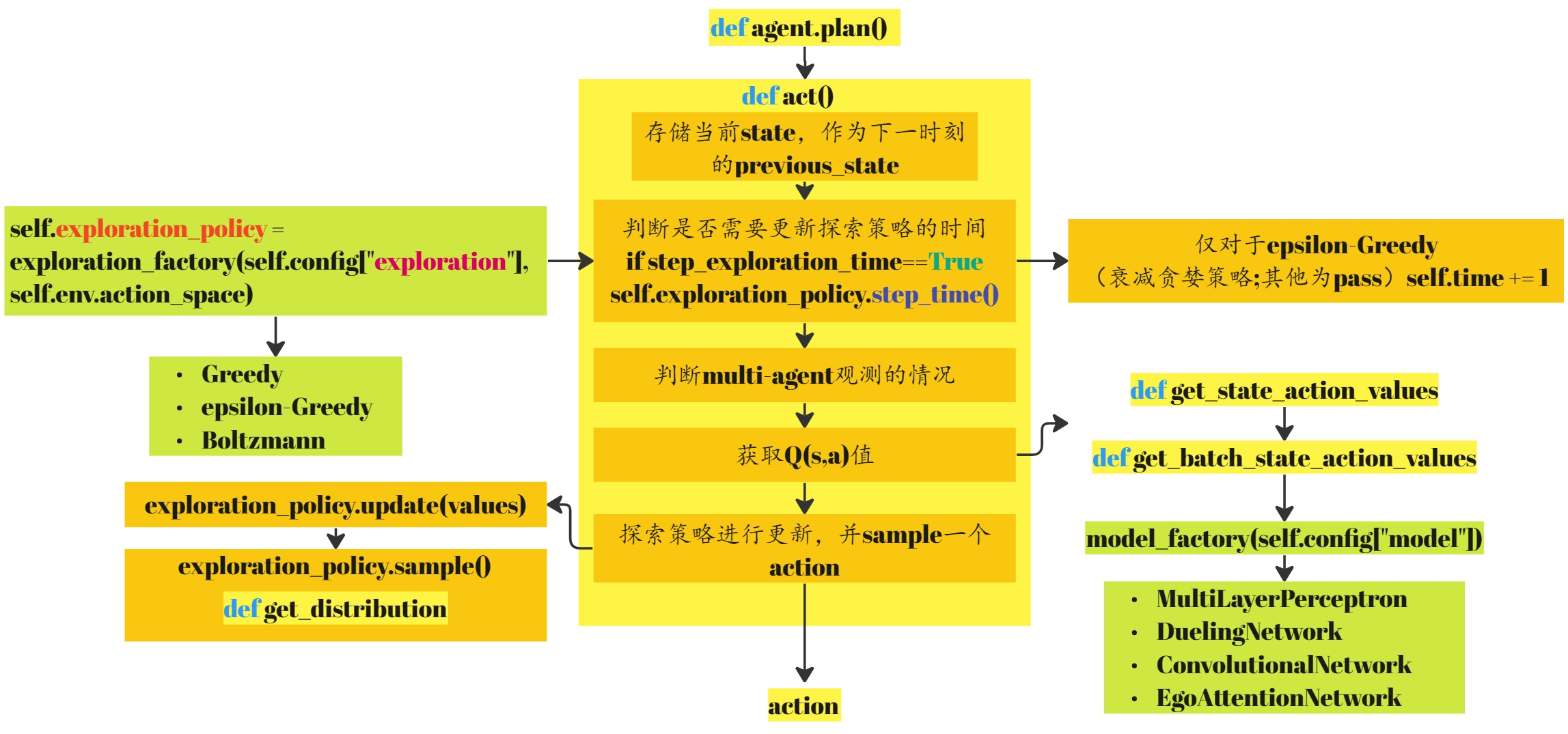

本文将继续探索rl-agents中相关DQN算法的实现。下面的介绍将会以`intersection`这个环境为例,首先介绍一下Highway-env中的`intersection-v1`。Highway-env中相关文档——[http://highway-env.farama.org/environments/intersection/](http://highway-env.farama.org

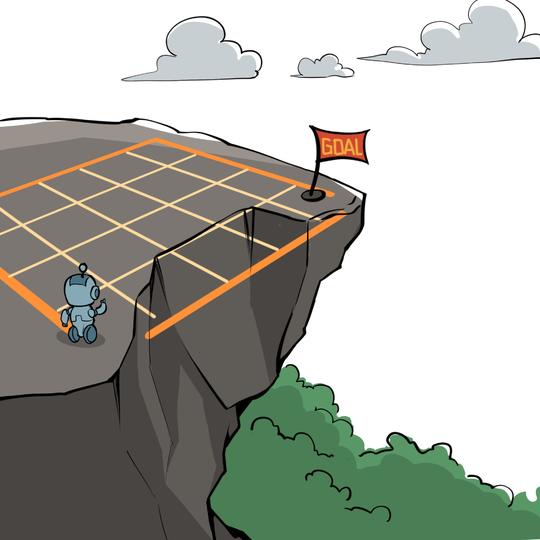

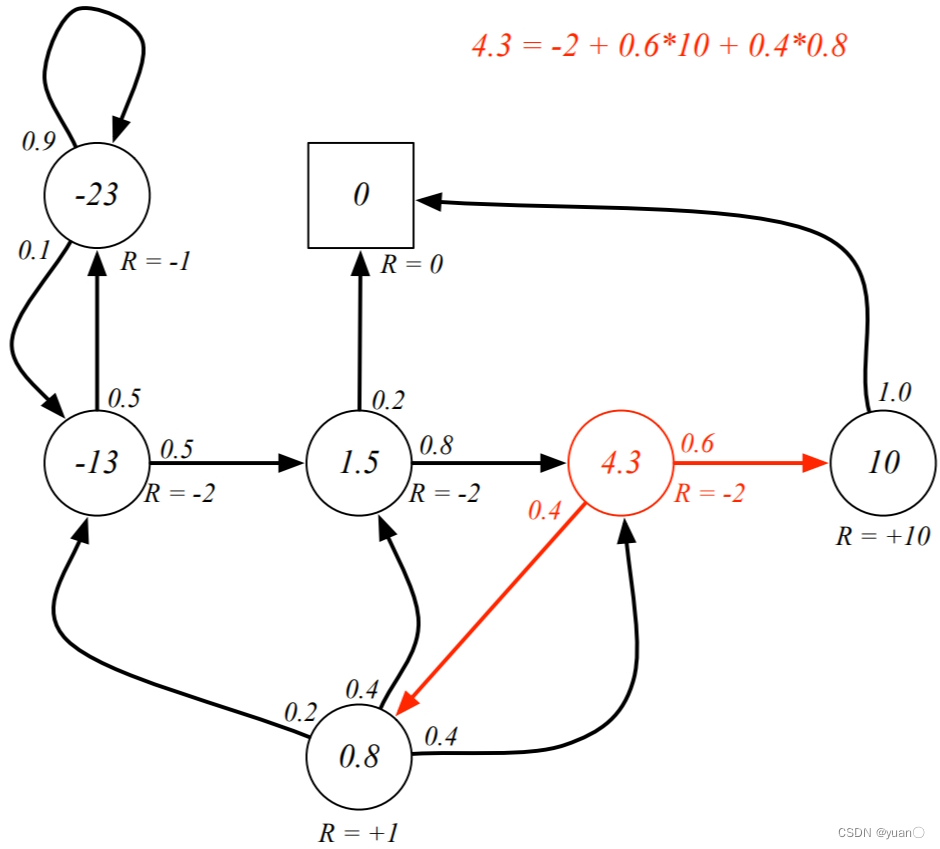

动态规划)是程序设计算法中非常重要的内容,能够高效解决一些经典问题,例如背包问题和最短路径规划。动态规划的基本思想是将待求解问题分解成若干个子问题,先求解子问题,然后从这些子问题的解得到目标问题的解。最优子结构:最优解可以被分解为子问题。最优性原理适用:重叠子问题:子问题经常重复出现。解决方案可以被缓存和重复使用。马尔可夫决策过程符合这两个属性。贝尔曼方程提供了递归分解。价值函数存储和重用解决方案

在此推荐另一篇文章【自动驾驶决策规划】POMDP之Introduction“The future is independent of the past given the present”未来状态的概率分布只与当前状态有关,而与过去状态无关。定义:性质:Pss′\boldsymbol{P}_{ss^{\prime}}Pss′为从状态sss转移到状态s′s's′的概率,又称一步状态转移概率。P\b

继续上一讲的内容【强化学习】05 —— 基于无模型的强化学习(PredictionElevatorBioreactorHelicopterQuakeGame of GoMDP模型是已知的,但是规模太大,只能通过采样进行MDP模型是未知的,只能通过在经验中进行采样在线策略学习和离线策略学习。通常来说,在线策略学习要求使用在当前策略下采样得到的样本进行学习,一旦策略被更新,当前的样本就被放弃了,就好像

前面 URDF 文件构建机器人模型的过程中,存在若干问题。问题1:设计易出错。问题2:代码复用性问题。…如果在编程语言中,可以通过变量结合函数直接解决上述问题,在 ROS 中,已经给出了类似编程的优化方案,称之为:Xacro概念Xacro 是 XML Macros 的缩写,Xacro 是一种 XML 宏语言,是可编程的 XML。原理Xacro 可以声明变量,可以通过数学运算求解,使用流程控制控制执

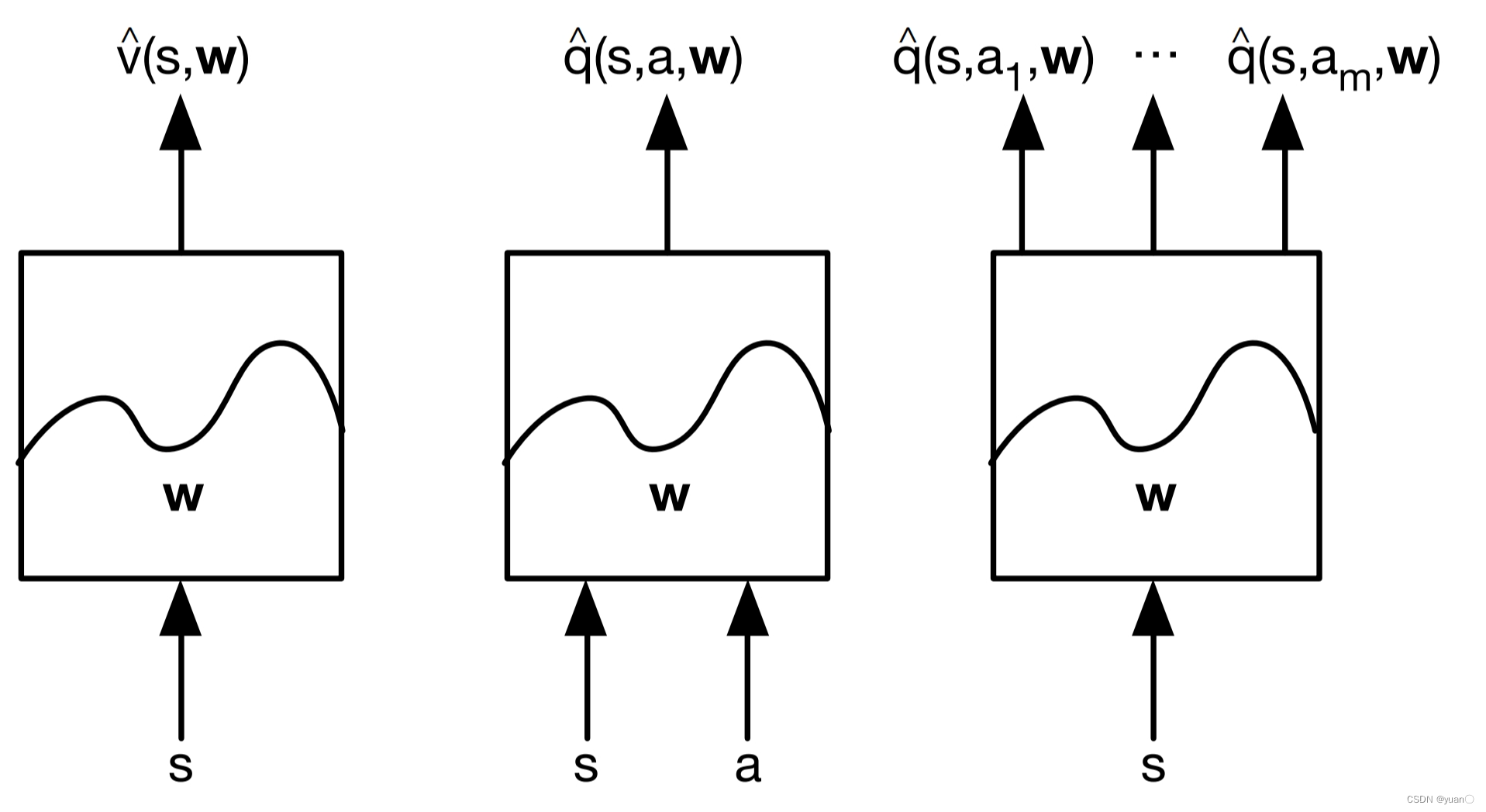

之前所有模型的做法都是基于创建一个查询表,在表中维护状态值函数VsV(s)Vs或状态-动作值函数QsaQ(s,a)Qsa。但对于大规模的MDP时,为每一个状态维护VsV(s)Vs或为每个状态-动作对维护QsaQ(s,a)Qsa存储状态或动作需要大量的存储空间对于每一个状态去学习相应的价值需要耗费大量时间大规模问题状态或者状态-动作空间非常大连续的状态或动作空间围棋博弈(1017010^{170}1

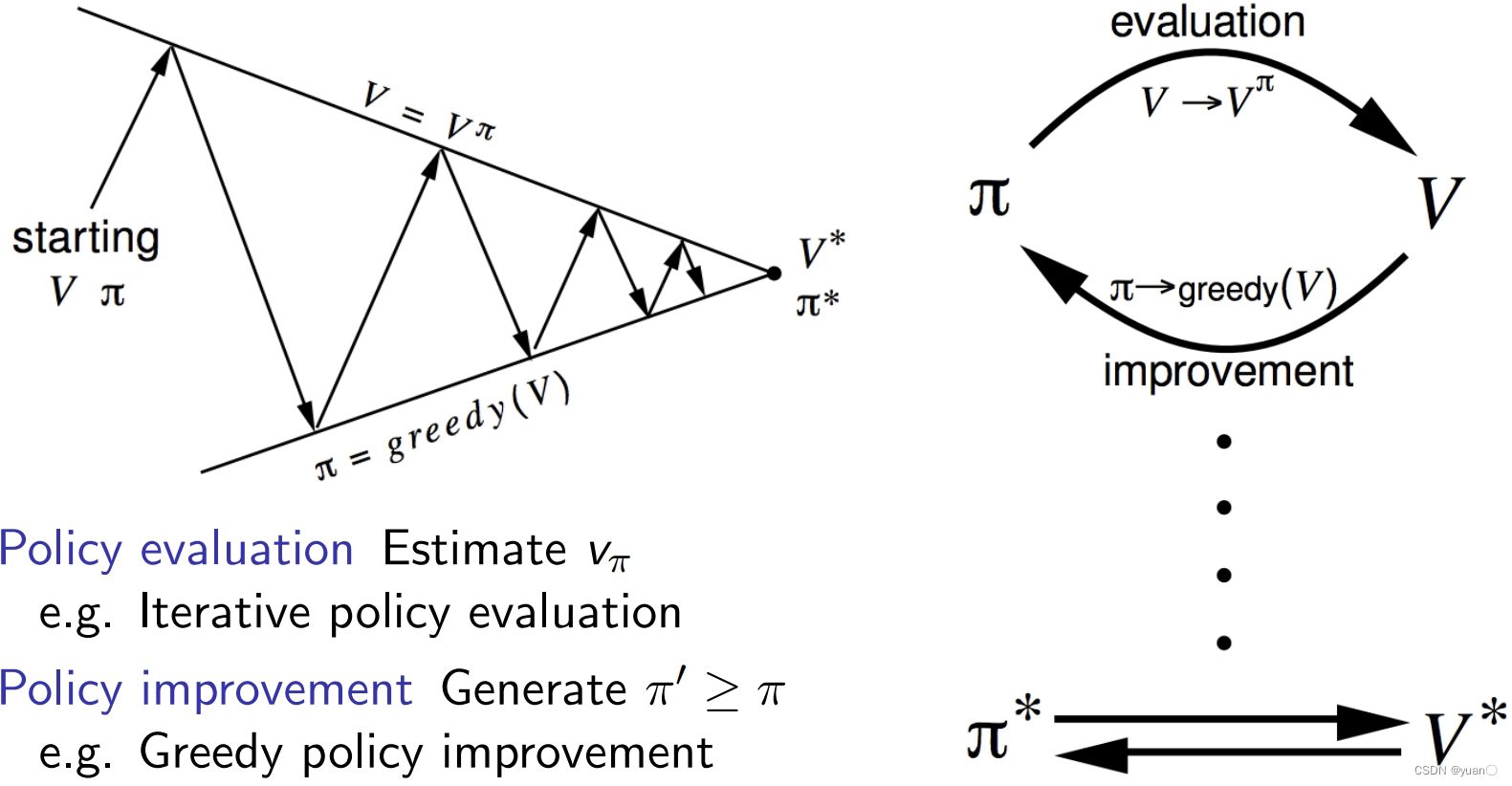

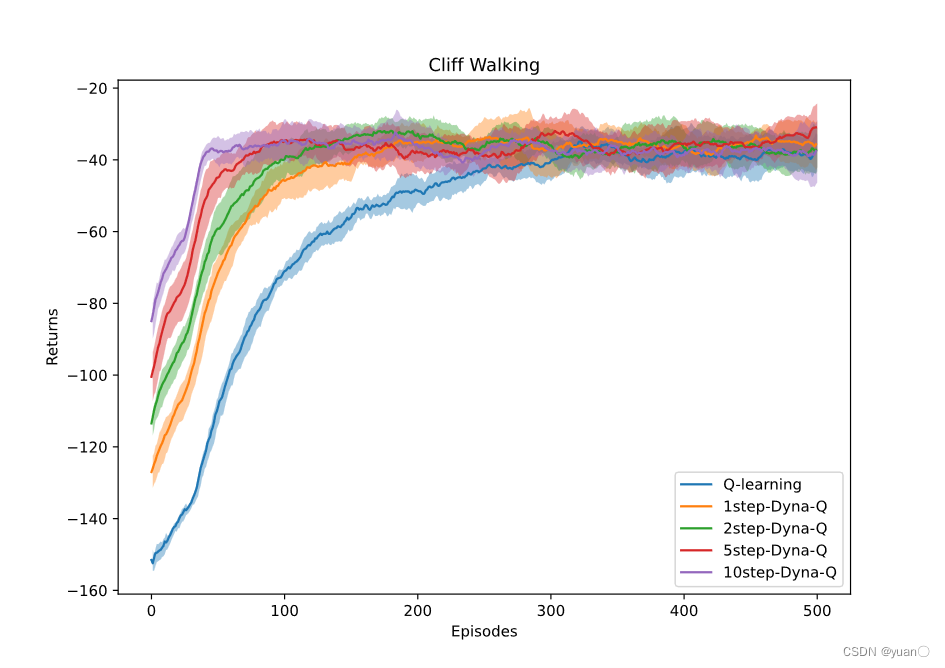

前置知识回顾策略值函数估计(Policy Evaluation)策略提升(Policy Improvement)模型(Model)规划(Planning)规划与学习(Planning and Learning)Dyna (集成规划、决策和学习)

古月居《ROS机器人开发实践》机器人SLAM与导航运行代码遇到的问题及解决方案

安装相应功能包:创建功能包,暂时只需用到以下依赖:gmapping map_server amcl move_basegmapping 是ROS开源社区中较为常用且比较成熟的SLAM算法之一,gmapping可以根据移动机器人里程计数据和激光雷达数据来绘制二维的栅格地图,对应的,gmapping对硬件也有一定的要求:该移动机器人可以发布里程计消息机器人需要发布雷达消息(该消息可以通过水平固定安装的