简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

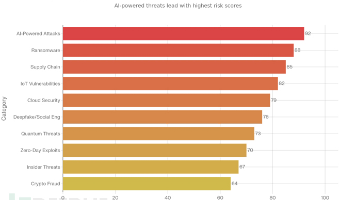

2026网络安全趋势:AI重塑攻防格局 2026年网络安全将面临AI驱动的自主威胁、深度伪造攻击和量子计算风险的交织挑战。AI恶意软件可实时调整攻击策略,钓鱼攻击利用个性化信息欺骗率提升60%,深度伪造技术导致企业平均损失60万美元。勒索软件进化为AI增强的多阶段攻击,数据窃取速度比人类快100倍。身份安全成为焦点,75%的入侵通过凭证滥用实现,零信任架构成为主流防御。云和供应链风险加剧,80%的

这不仅仅是一份技术文档,也不仅仅是一堆「不要做坏事」的规则列表。Anthropic 试图教会 Claude 理解人类社会的道德逻辑,甚至开始关心 AI 的「心理健康」Anthropic 在文档中直言:「如果想要模型在各种新奇的情况下都能做出正确的判断,它们必须学会。这就好比教小孩,如果你只告诉他「不准撒谎」,他遇到善意的谎言场景时就会死机。任何创业公司,都可以直接拿这套经过深思熟虑的「道德代码」去

2024年12月流行的Ultralytics AI库遭入侵攻击者植入恶意代码劫持系统资源进行加密货币挖矿。2025年8月,恶意Nx软件包导致2349个GitHub、云服务和AI凭证泄露整个2024年间ChatGPT漏洞使得攻击者能够未经授权提取AI记忆中的用户数据。:仅2024年,AI系统就泄露了2377万条敏感信息,较上年增长25%。这些事件的共同点是:受害组织都部署了完善的安全方案通过了各项审

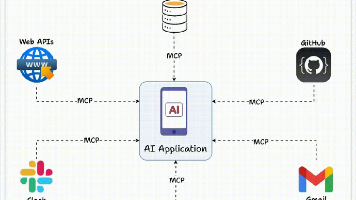

MCP(Model Context Protocol,模型上文协议)定义了应用程序和AI模型之间交换上下文信息的方式。指的是AI和外部工具的通用交互协议简单来说,就是让AI和各类工具都使用同一种语言交流。大模型可以使用MCP进行和外部工具之间的互动(浏览器、文件系统、数据库、终端等),MCP服务作为中间层,代替人类访问操作外部工具。

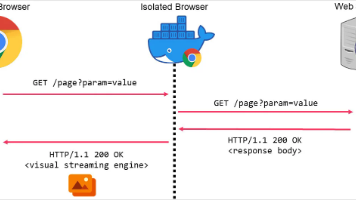

首先,数据流的最大大小被限制为 2,189 字节,大约是 QR 码可以携带的最大数据的 74%,如果在恶意软件的解释器上读取 QR 码时出现问题,则数据包的大小需要进一步减小。浏览器隔离是一种日益流行的安全技术,它通过云环境或虚拟机中托管的远程 Web 浏览器路由所有本地 Web 浏览器请求,所访问网页上的任何脚本或内容都在远程浏览器而不是本地浏览器上执行。隔离的浏览器会处理传入的 HTTP 请求

《DeepSeek一年记:掉队表象下的颠覆者逻辑》一年前横空出世的DeepSeek R1曾引发全球AI行业震动,如今其App下载量虽降至第七,但实际影响力远超表面排名。背靠幻方量化50亿年利润的"印钞机"支持,DeepSeek以零融资姿态保持技术独立性,专注模型效率而非商业变现。其开源策略颠覆了算力决定论,在非洲等新兴市场占据主导,并引发欧洲打造本土版DeepSeek的浪潮。即

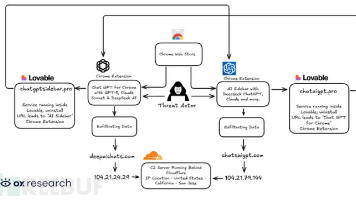

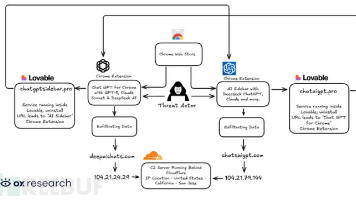

网络安全研究人员在Chrome应用商店发现两款新型恶意扩展程序,专门窃取用户与OpenAI ChatGPT的对话内容,并将浏览数据外传至攻击者控制的服务器。这两款累计用户超90万的扩展分别为此次发现距相关扩展(在Chrome和Edge平台拥有数百万安装量)被曝监控用户与AI聊天机器人对话仅数周。Secure Annex将这种通过浏览器扩展窃取AI对话的技术命名为。

网络安全研究人员在Chrome应用商店发现两款新型恶意扩展程序,专门窃取用户与OpenAI ChatGPT的对话内容,并将浏览数据外传至攻击者控制的服务器。这两款累计用户超90万的扩展分别为此次发现距相关扩展(在Chrome和Edge平台拥有数百万安装量)被曝监控用户与AI聊天机器人对话仅数周。Secure Annex将这种通过浏览器扩展窃取AI对话的技术命名为。

摘要:研究人员发现n8n自动化平台存在高危漏洞(CVE-2026-21858),攻击者可利用内容类型混淆实现任意文件读取,进而通过窃取会话cookie获取管理员权限。该漏洞允许攻击者完全控制本地n8n部署,访问连接的企业敏感系统(如GoogleDrive、OpenAI API等)。虽然漏洞已在11月修复,但n8n采用延迟披露策略,建议用户立即更新至最新版本。研究人员警告称,受感染的n8n实例可能成

AI Agent工具正在重塑生产力:Anthropic推出Cowork桌面助手,支持本地文件处理和自动化工作流,仅需10天由4人团队开发完成,90%代码由AI编写。随后开源替代品OpenWork在48小时内问世,显示技术门槛降低。类似产品如Manus(被Meta20亿收购)、GeminiCLI和ChatGPTAgent各具特色,但Cowork的创新在于验证了"AI构建AI"的范