简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

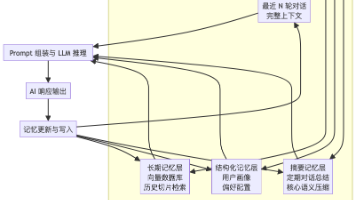

摘要:本文深入探讨了AI在多轮对话中"失忆"问题的根源与解决方案。指出模型无状态性、Token限制和注意力分散是三大核心问题,并提出分层记忆系统架构:短期记忆(对话缓冲区)、长期记忆(向量检索)、摘要记忆(定期压缩)和结构化记忆(键值存储)。文章详细介绍了三种技术实现方案(滑动窗口+摘要、向量检索、多Agent共享状态)及主流工具生态(LangChain/LlamaIndex等

2026年春晚,机器人公司取代白酒品牌登上赞助商舞台——这不是简单的品牌轮换,而是三代中国企业家赚钱逻辑的代际更迭。第一代:白酒时代。五粮液、茅台们靠广告建立品牌认知,赚"品牌溢价"的钱。核心逻辑:规模+广告=品牌溢价。第二代:流量时代。微信、阿里们用红包、集福抢用户,赚"网络效应"的钱。核心逻辑:流量+生态=用户粘性。第三代:科技时代。宇树科技、松延动力们展示机器人技术,赚"能力垄断"的钱。核心

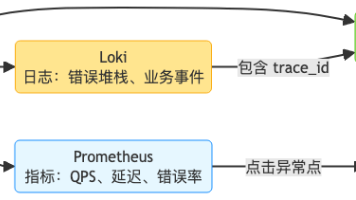

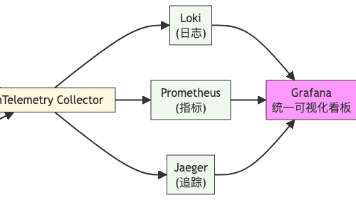

本文探讨云原生环境下的可观测性体系建设,提出将日志(Loki)、指标(Prometheus)和追踪(Jaeger)有机融合的解决方案。通过轻量级日志方案Loki+Promtail、Prometheus指标监控、OpenTelemetry分布式追踪等技术,构建可关联分析的统一视图。重点介绍了各组件部署配置方法、数据采集原理及Grafana整合方案,并基于RED方法设计告警规则。最终实现日志可查、指标

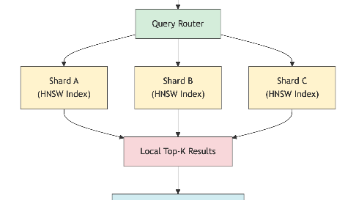

摘要:本文系统阐述了亿级向量数据库在高并发场景下的五大扩展策略。首先通过分片技术实现数据水平扩展,介绍了哈希、范围和一致性哈希三种分片方案;其次采用读写分离架构解耦写入与查询压力;第三提出冷热数据分层存储方案,优化资源利用率;第四探讨智能负载均衡策略;最后强调基于真实业务流量的压测方法论。这些策略共同构建了高性能向量检索系统的核心架构,为应对万级QPS与亿级数据规模提供了系统化解决方案。

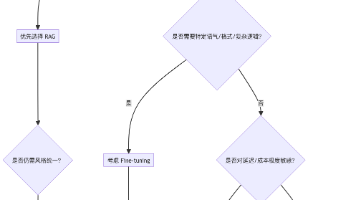

摘要: RAG(检索增强生成)与微调(Fine-tuning)是企业应用大模型的两种主流技术。RAG通过动态检索外部知识库生成答案,适合知识高频更新、需可解释性的场景;微调则将特定知识内化到模型中,适用于风格/格式固定的任务。两者各有优势:RAG开发成本低、更新灵活,微调在复杂指令和性能上更优。混合方案(RAG+轻量微调)能兼顾实时性与输出一致性。技术选型需考虑数据合规性、更新频率及成本,建议优先

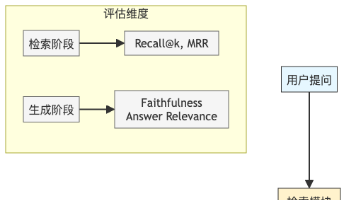

RAG技术评估体系构建指南:本文系统阐述了检索增强生成(RAG)系统的科学评估方法。提出分阶段评估框架,涵盖检索阶段(Recall@k、MRR)和生成阶段(Faithfulness、AnswerRelevance)的自动指标,推荐使用RAGAS和TruLens工具实现自动化评估。同时强调人工评估的必要性,包括A/B测试、用户满意度打分和专家评审。文章详细介绍了BadCase分析方法,建议将其固化为

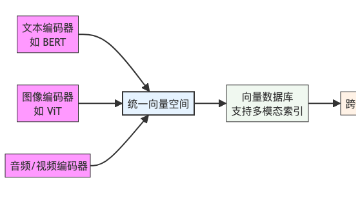

向量数据库正成为AI时代的关键基础设施,其六大前沿趋势值得关注:1)突破"只读"限制,实现实时更新与动态删除;2)构建多模态统一向量空间,支持跨模态检索;3)与图数据库融合,结合语义相似性与实体关系;4)Serverless架构降低使用门槛,实现按需计费;5)AutoML技术自动优化索引选择;6)开源生态与标准化避免碎片化。这些趋势共同推动向量数据库从实验工具升级为支持推荐系统

本文探讨了RAG系统在生产环境中实现可观测性的关键方法。文章指出,RAG系统由多个组件构成,缺乏可观测性会导致问题难以定位。作者提出了三位一体的解决方案:结构化日志记录关键路径信息,量化指标监控系统健康度,分布式追踪实现请求全链路可视化。此外,还建议配置主动告警机制,并通过Grafana统一展示日志、指标和追踪数据。文章强调,可观测性是RAG系统稳定运行的必备能力,需要从日志、指标、追踪三个维度构

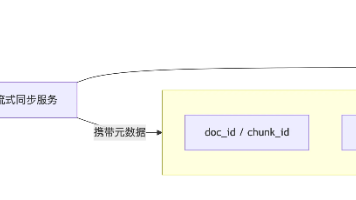

摘要: RAG(检索增强生成)系统通过流式更新实现知识库的动态同步,支持新增、删除和修改操作,无需全量重建或重训模型。流式更新的核心在于元数据设计(如唯一ID、版本号)和向量数据库选型(如Milvus、Qdrant),结合消息队列和软删除机制,确保近实时生效。该技术适用于高频变动的客服、合规等场景,显著降低运维成本,提升知识鲜度,是RAG落地的关键能力。未来,随着向量数据库功能的完善,RAG将更接

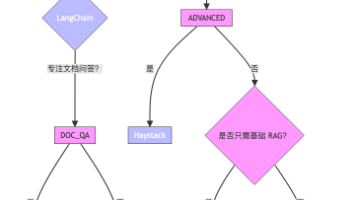

如果你是初创团队,追求快速迭代 →LangChain + LlamaIndex 混合使用如果你构建企业知识库→LlamaIndex 或 Haystack如果你重视系统稳定性与可观测性→Haystack如果你在做AI 研究或自动优化实验→DSPy记住:框架只是工具,真正的竞争力在于你对业务的理解与系统设计能力。避免“为了用框架而用框架”,在合适的地方用合适的轮子,才是高级工程师的修养。