简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

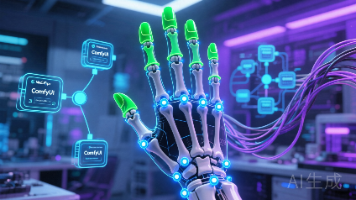

今日攻坚AI核心工作流,成功落地基于ComfyUI的自动化指甲分割方案。通过部署ComfyUI节点式推理引擎,实现了算法链路的模块化编排。技术方案采用MediaPipe手部骨骼检测精确定位指尖坐标,级联SAM万物分割大模型完成像素级抠图。针对边缘融合问题,引入掩码收缩与羽化算法,有效解决了美甲溢色及“贴纸感”痛点。此举不仅实现了零人工干预的选区提取,更为后续的高保真风格迁移与光影重绘打下坚实基础。

本日成功搭建“指尖魔镜”云端AI算力基座。基于RTX 4090环境,部署了ComfyUI可视化编排引擎。核心成果包括:环境闭环:完成PyTorch 2.4与依赖库的兼容性配置,解决版本冲突。模型装填:加载SDXL高清基座与VAE修复模型,确立照片级画质标准。分割就绪:集成Impact-Pack插件(含SAM/YOLO模型),构建“粗定位+精分割”的级联能力。至此,一套具备“指甲精准分割+光影重绘”

本项目旨在打造AI美甲虚拟试戴SaaS平台,当前处于POC核心验证阶段。今日聚焦基础设施搭建与架构落地:确立双核异构架构:采用“Java负责业务调度、Python负责AI算力”的物理分离模式,实现高并发与重计算解耦,确保系统弹性。落地业务基座:基于Ruoyi-Vue-Pro框架完成模块裁剪与环境初始化,快速复用RBAC权限与OSS底座,大幅缩短开发周期。完成环境闭环:MySQL、Redis及管理后

历经 15 天的硬核开发,Project Echo 终于迎来了最终交付。为了彻底解决“在我电脑上能跑”的环境依赖噩梦,今天我们将引入 Docker 和 Docker Compose。我们将编写多阶段构建的 Dockerfile,配置 Nginx 反向代理,并编排 Backend、Frontend、Redis 三大容器。只需一个 docker-compose up -d 指令,即可在任何服务器上拉起

历经 15 天的硬核开发,Project Echo 终于迎来了最终交付。为了彻底解决“在我电脑上能跑”的环境依赖噩梦,今天我们将引入 Docker 和 Docker Compose。我们将编写多阶段构建的 Dockerfile,配置 Nginx 反向代理,并编排 Backend、Frontend、Redis 三大容器。只需一个 docker-compose up -d 指令,即可在任何服务器上拉起

今天是 Phase 5 的第一天,我们不仅要实现前后端分离,还要把 Day 13 的“全自动语音交互”搬到网页上!由于服务器无法直接访问客户端麦克风,架构必须升级。我将在 Vue 3 前端引入 @ricky0123/vad-web(基于 ONNX 的端侧推理模型),实现“浏览器端静默检测”。后端 FastAPI 则升级支持音频文件上传,配合 Whisper 和 LangChain 完成全链路响应。

今天是 Phase 5 的第一天,我们不仅要实现前后端分离,还要把 Day 13 的“全自动语音交互”搬到网页上!由于服务器无法直接访问客户端麦克风,架构必须升级。我将在 Vue 3 前端引入 @ricky0123/vad-web(基于 ONNX 的端侧推理模型),实现“浏览器端静默检测”。后端 FastAPI 则升级支持音频文件上传,配合 Whisper 和 LangChain 完成全链路响应。

Day 11-12 我们完成了语音的输入输出,但交互方式依然停留在“按键触发”的原始阶段。今天是 Day 13,我们将引入 VAD (语音活动检测) 算法。通过计算音频流的能量阈值 (RMS),让 Project Echo 能够自动判断用户何时开始说话、何时停止说话。我们将重构录音模块,实现 “唤醒 -> 自动聆听 -> 自动静默检测 -> 自动回复” 的全自动闭环,打造真正的 Hands-fre

Day 11-12 我们完成了语音的输入输出,但交互方式依然停留在“按键触发”的原始阶段。今天是 Day 13,我们将引入 VAD (语音活动检测) 算法。通过计算音频流的能量阈值 (RMS),让 Project Echo 能够自动判断用户何时开始说话、何时停止说话。我们将重构录音模块,实现 “唤醒 -> 自动聆听 -> 自动静默检测 -> 自动回复” 的全自动闭环,打造真正的 Hands-fre

Day 11 我们实现了语音合成,今天我们将补全多模态交互的另一半拼图——STT (语音转文本)。我将引入 OpenAI 开源的 Whisper 模型(Base版本),它具备惊人的多语言识别能力和抗噪能力。本文将封装一个 AudioRecorder 模块用于麦克风录音,并构建 STTEngine 引擎,实现“听到声音 -> 转化为文字 -> 触发 RAG 对话”的完整闭环。