简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

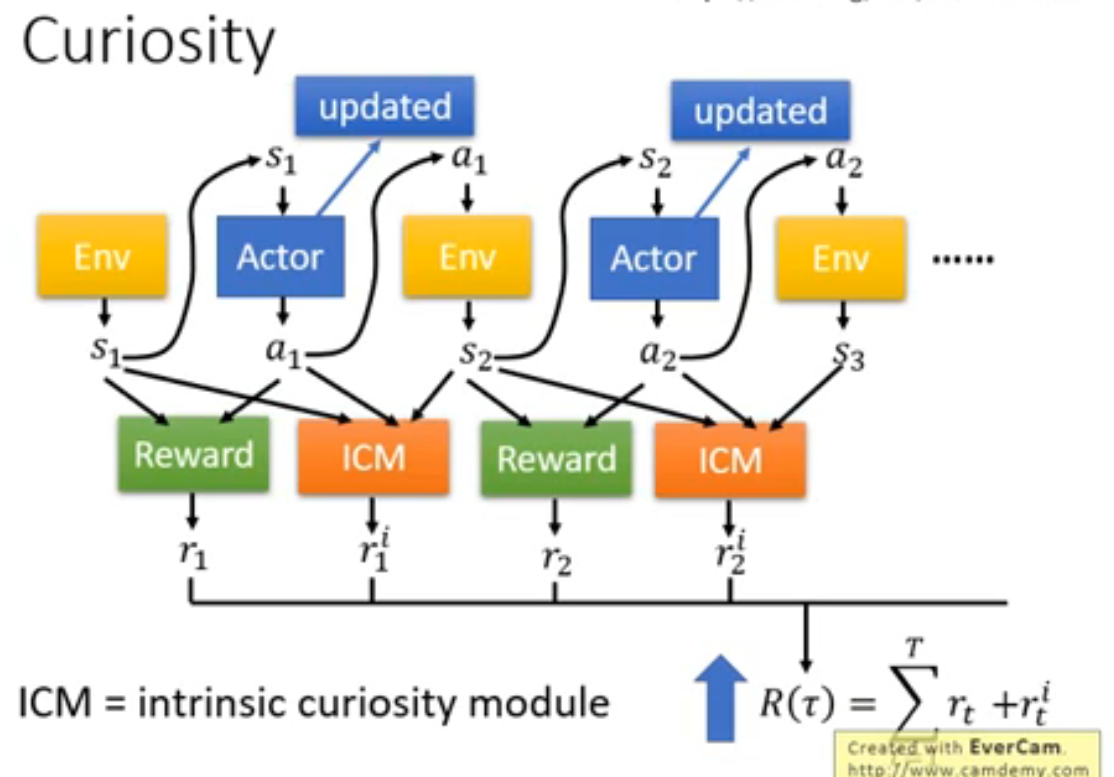

摘要: SEARCH-R1与Memory-R1通过强化学习(RL)推动智能体自主能力进化。SEARCH-R1实现"边思考边检索",模型自主决策检索时机与策略,结合效率奖励优化多轮搜索-推理流程。Memory-R1构建动态长时记忆系统,通过RL联合优化记忆管理(增删改)与回答生成,实现跨会话经验积累。两者互补:前者增强外部知识获取,后者提升内部记忆复用。其RL框架突破了监督学习的

编码标准发布年份压缩效率优点缺点主要应用场景H.264/AVC2003高兼容性广,成熟,适合实时编码对 4K 支持不足,硬件要求较高流媒体、视频会议、移动设备H.265/HEVC2013非常高压缩效率高,支持 4K/8K 和 HDR专利费用高,硬件要求高4K 流媒体、超高清电视、VR/ARAV12018极高开源免版税,压缩效率优于 H.265编码复杂度极高,硬件支持尚未完全普及开源流媒体、网页视频

关于 Episode length的设置,理论上应该是无穷大的(agent到达目标点后选择action为不动),但实际中需要一个确切的值,值越大越接近最优的策略,此时对应的state value也是最终的值。注意,这里s2,s3情况下的策略是最优的,所有改进策略一定是有效的,但可以证明,无论后面的策略是否最优,都可以经过action value的迭代最终达到最优策略。,此时我们不知道g(w)的具体

比如,在一个迷宫寻路问题中,除了给出到达终点的正奖励和每走一步的负奖励外,还可以给出接近终点的正奖励或远离终点的负奖励,以引导智能体更快地找到正确的路径。正奖励表示智能体做出的行为对任务有益,负奖励表示行为有害,而零奖励表示行为没有影响。过小的奖励可能无法提供足够的鼓励,从而导致智能体无法学会任务,过大的奖励可能会导致智能体出现过度拟合的现象,或者出现在任务中没有意义的行为。稀疏的奖励可能会导致智

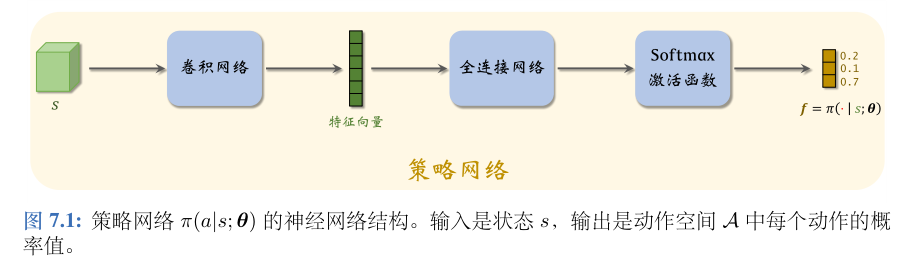

策略学习的意思是通过求解一个优化问题,学出最优策略函数πa∣s或它的近似函数(比如策略网络)。

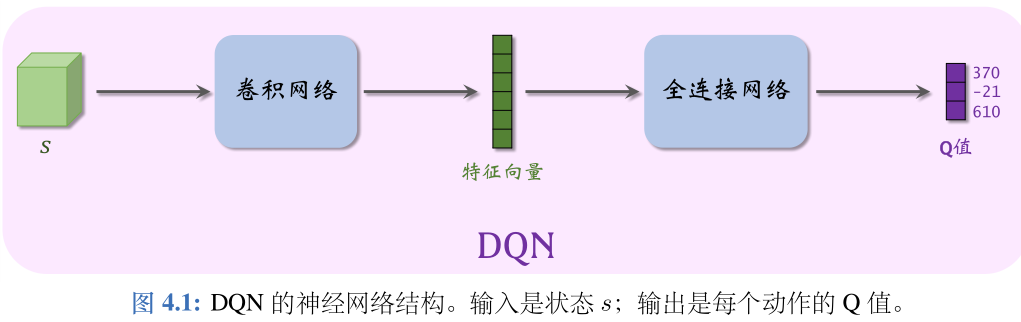

Q⋆Qsa;wQ∗sa。

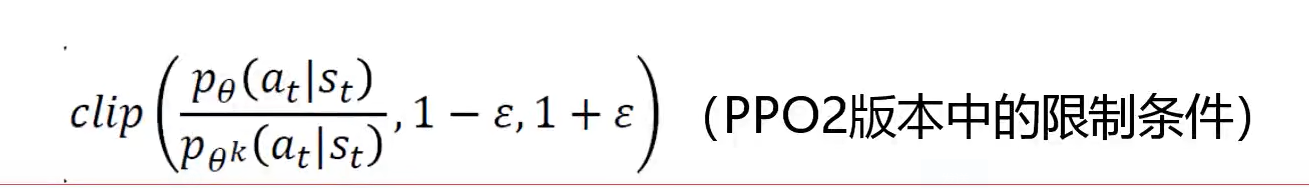

PPO算法是一种强化学习中的策略梯度方法,它的全称是Proximal Policy Optimization,即近端策略优化1。PPO算法的目标是在与环境交互采样数据后,使用随机梯度上升优化一个“替代”目标函数,从而改进策略。PPO算法的特点是可以进行多次的小批量更新,而不是像标准的策略梯度方法那样每个数据样本只进行一次梯度更新12。PPO算法有两种主要的变体:PPO-Penalty和PPO-Cl

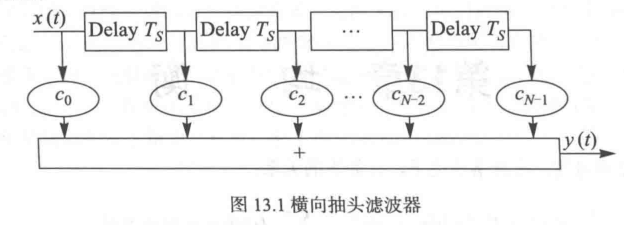

什么是均衡?在得到的Y[n]当中,存在符号间干扰和噪声。在通信当中,把符号间干扰去掉的技术叫作均衡( equalization)。横向抽头滤波器图中x(t)为存在符号间干扰的模拟基带信号,y(t)是经过均衡后的信号,符号间干扰被大大降低。离散线性系统将H写成列向量的形式:很容易看出,y=Hx+z即表达出卷积运算。y=Ax+z:上面A即为得到的信道矩阵,yHx。注意一个细节,要得到x的解,就是解方程

因为有两个图(都是跨栏),都需要放在一页的top,但第一个图在top之后,第二张图就直接被挤到了新的一页。

NormalizedActions是一个gym的ActionWrapper,它可以对任何一个gym环境的动作空间进行包装,从而实现动作空间的归一化。3. DDPG 的 actor 网络是一个确定性的策略网络,它直接输出一个具体的动作,而不是一个动作的概率分布。AC 的 actor 网络可以是一个确定性的或者随机性的策略网络,根据不同的变种而定。其中,第一项是Q值对动作的梯度,第二项是策略网络对参数