简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Robyn是一款基于Rust运行时构建的新型异步Python Web框架,于2024年发布,以其独特的混合架

文章概要阿里开源ROCK框架,与ROLL训练框架组成完整智能体训练解决方案。

和。以GPT-4为例,1750亿参数的神经网络不仅能理解"请实现JWT鉴权"这样的技术指令,还能从模糊需求(如"做个比淘宝更快的购物车")中推导出需要优化的关键指标。更惊人的是,当开发者用语音描述需求时,像Amazon CodeWhisperer这样的工具能实时生成符合企业规范的代码,准确率高达91%——这相当于给每个程序员配了个懂28种编程语言的超级助理。传统软件开发流程正在被AI拆解重组,形成

自定义查询引擎多条件组合查询:支持"与或非"逻辑运算,实现"查找2023年后发表的、与肺癌治疗相关、排除动物实验的文献"这类复杂需求。时序感知检索:内置时间推理能力,自动识别"上周"、"去年Q2"等相对时间表达,并映射到具体时间范围。领域适配接口:提供配置接口让不同行业注入领域知识,如金融领域加入风险等级过滤,医疗领域加入证据等级评估。

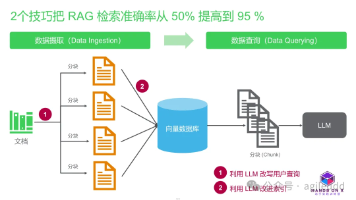

当我第一次听说DragonMemory的16倍语义压缩技术时,我的第一反应是:这怎么可能?但深入了解后,我发现这项技术确实在RAG优化领域掀起了一场革命。今天,我要带你一起揭秘这项神奇的技术——它如何通过先进的语义理解算法,在不损失关键信息的前提下,将检索内容压缩至原来的1/16,让RAG应用存储成本直降80%,检索速度飙升,同时保持惊人的准确性!当传统RAG应用还在存储成本和检索速度之间艰难权衡

HunyuanVideo 1.5的架构创新,体现了腾讯混元团队对。

TensorRT-LLM 1.2通过。

内核缓冲区 ──► Bytes ──► Hyper 零拷贝 ──► Python 视图▲│ 无锁 mpscTokio 线程池 ◄─────┴─────► 业务 Handler(GIL 微秒级)│WebSocket/HTTP2 统一循环 ──► 单线程 30 万长连接拷贝少了、锁短了、线程省了——Python 终于能飞而不是爬。

作为一名语音技术开发者,我一直在寻找完美的实时语音转录解决方案,直到发现了WhisperLiveKit这个宝藏项目。它不仅解决了传统ASR工具的延迟痛点,还集成了说话人识别功能,真正实现了’所说即所得’的极致体验。今天我要带你深入了解这个基于Python的开源神器,看看它如何通过本地化部署、流式处理技术和智能说话人分离,让语音转录变得前所未有的简单高效。还在为语音转录的延迟抓狂吗?想象一下,会议开