简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

开源大数据OLAP组件,可以分为MOLAP和ROLAP两类。ROLAP中又可细分为MPP数据库和SQL引擎两类。对于SQL引擎又可以再细分为基于MPP架构的SQL引擎和基于通用计算框架的SQL引擎:MOLAP一般对数据存储有优化,并且进行部分预计算,因此查询性能最高。但通常对查询灵活性有限制。MPP数据库是个完整的数据库,通常数据需要导入其中才能完成OLAP功能。MPP数据库在数据入库时对数据分布

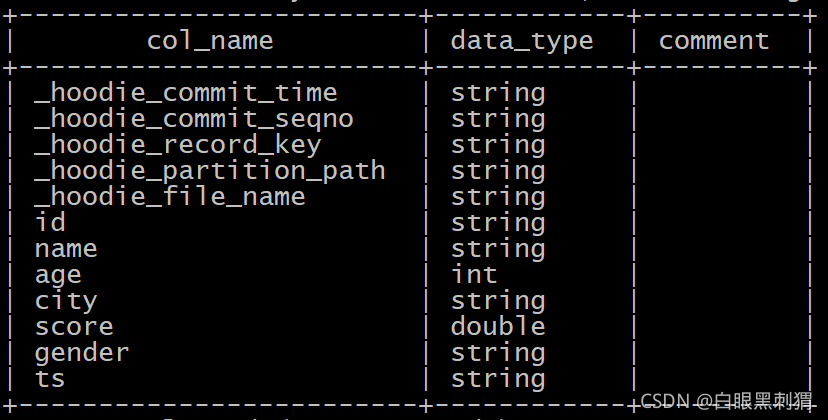

文章摘要: Paimon的分桶机制通过哈希函数优化数据存储和查询性能,主要提供五种分桶模式:1)HASH_FIXED固定哈希分桶,适合数据量可预测的场景;2)HASH_DYNAMIC动态哈希分桶,自适应数据量变化;3)CROSS_PARTITION跨分区动态分桶,优化分区表全局分布;4)BUCKET_UNAWARE无感知分桶,适合小数据量表;5)POSTPONE_MODE延迟分桶,提升实时写入性能

在上一章,我们学习了 Paimon 如何保证每一次写入的原子性和一致性。但数据仓库的核心需求不仅是写入,更重要的是。想象一个场景:我们需要实时更新用户的最新信息,或者实时累加计算用户的消费总额。传统的 Hive 数据湖对此无能为力,每次更新都需要重写整个分区,成本极高。Paimon 通过引入,完美解决了这个问题。本章,我们将揭秘 Paimon 高效更新背后的两大支柱:LSM-Tree 思想的巧妙运

深入理解 Paimon 的核心工作机制,知道“它为什么能这么快、这么稳”。

注意本案是以HDFS离线数据为例1 spark操作hivesparksql读取hive中的数据不需要hive参与 , 读取HDFS中的数据和mysql中的元数据信息即可Sparksql本身就内置了hive功能加载hive的数据,本质上是不需要hive参与的,因为hive的表数据就在hdfs中,hive的表定义信息在mysql中不管数据还是定义,sparksql都可以直接去获取!步骤:要在工程中添加

作为一款基本免费的翻译工具,沉浸式翻译提供了非常丰富的功能,包括了网页翻译、PDF 翻译、EPUB 翻译、字幕翻译以及相应的导出功能,同时通过悬浮球、键盘快捷键、鼠标悬浮等方式来提高翻译的效率,让优秀的功能不被麻烦的调用方式拖累。同时,如果你还想获得更多强大的服务,既可以直接购买沉浸式翻译自己的 Pro 会员,也可以自由购买 DeepL、OpenAI 等第三方的服务,自由度很高。

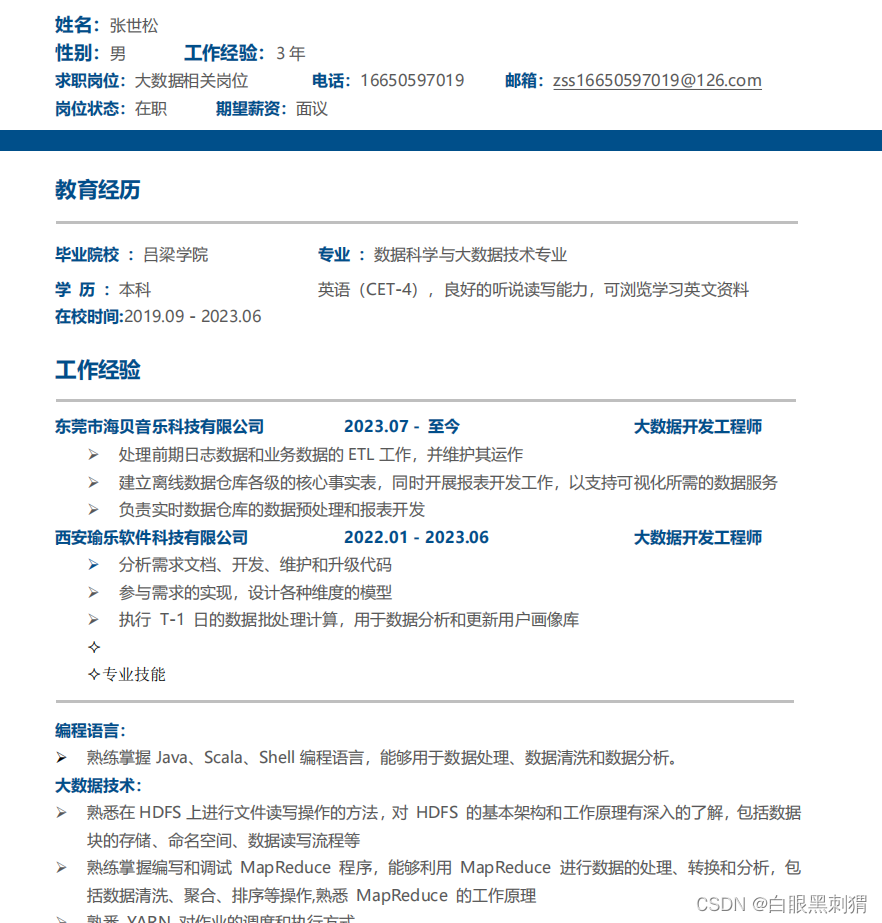

大数据简历大数据简历大数据简历大数据简历大数据简历大数据简历大数据简历大数据简历[大数据简历]

大数据真实简历大数据真实简历大数据真实简历大数据真实简历大数据真实简历大数据真实简历大数据真实简历大数据真实简历

对于Debian/Ubuntu的用户来说,只要打开你的终端跑一下上述的命令就可以了。对于CentOS/Redhat/RHEL/Fedora的Linux用户,则需要以root身份登录然后执行rmmod pcspkr。上装Linux,在Shell下由于输错命令或是按TAB键补全命令,会发出“嘟嘟”的报警声,很影响人的心情。于是上网搜了一番,最多提到的是方法一。vi /etc/inputrc中的set

今天在自己的电脑上了装虚拟机,操作系统是windows10家庭版,vmware版本是15.5 ,安装操作系统centos7. 安装软件和创建虚拟机的方式很简单,也没啥问题,就是每次已启动就蓝屏,重启。然后就在网上找解决方案。第一步是打开了win10家庭版的Hyper-V,并禁用。参考地址: 运行VMware15.5.5虚拟机导致win10蓝屏死机 (china-tom.com)主要就是打开了win