简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

贝叶斯分类器是在概率框架下发展起来的,因此,学习本章需要一定的概率论知识。贝叶斯学派与频率学派的根本分歧是:后者把未知参数看成一个未知的固定量,而前者把未知参数看成一个随机变量。

在数据仓库中,指标和维度是两个核心概念,它们对于数据分析和业务决策至关重要。以下是对这两个概念的分析及举例说明举例说明,指出:指标和维度在数据仓库中扮演着至关重要的角色。它们不仅提供了量化业务表现的关键数据点和详细背景信息,还支持多维分析和决策制定。通过合理利用这两个概念:指标+维度,企业可以更好地理解业务动态和市场趋势,从而做出更明智的决策。

在联合分布中,把变量集分成两部分,保留一部分,消去另一部分,从概率角度讲,叫“边际化”, 从求解的角度叫变量消去(消元)。学习与推断之变量消去法:求解过程为逐步“$m$化”的过程。

【西瓜书】中对NFL(没有免费的午餐)定理进行了证明(【西瓜书式(1.1)(1.2)(1.3)】),但过于简化,本文对几个关键点进行补充,从而给出详细的证明。

EM算法可视为“推断隐变量分布”和“求参数”交替进行。这里应用变分推断方法推断隐变量分布。

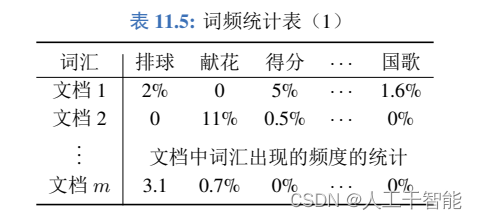

当我们把文档当作样本,词汇当作属性,属性的取值为该词汇在文档中占比(个数/总词汇数)——词频统计表“词典”有对词的“释义”,取该词属于某一类的可能性(隶属度)作为其“释义”——词典矩阵采用变量交替优化策略求解,用到矩阵的奇异值分解

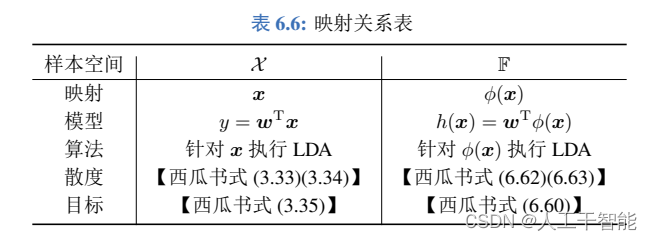

核函数特征映射推广到更一般的情形,除了SVM和SVR中使用核方法进行扩充外,这里再讨论核对率回归和核线性判别分析。用核方法扩展LDA算法形成核线性判别分析KLDA算法

一般的半朴素贝叶斯分类器需要知道每个$x_i$的父$\mathrm{pa}_i$,假定所有属性$x_i$有同一个父属性(该属性称为“超父”),特殊的半朴素贝叶斯分类器研究一些特殊的“父子”关系。

用多位的“码”作为样本和类的标记,则可借助编码理论。编码用于训练、解码用于预测。

信念传播算法是利用图的可视化表达。有向图时必须是先画完了再计算,因为,后退画出当前传递线时,“余入”并没有画出,当然不知道“余入”的值,故不能计算当前“一出”的值。 无向图是在画的过程中,同时计算出该传递线的消息值。在无向无环图情形下,可采用双向传递线画法。