简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在介绍原理前,我们来再次回顾一下一个类似于chatGPT这样大模型的训练流程。

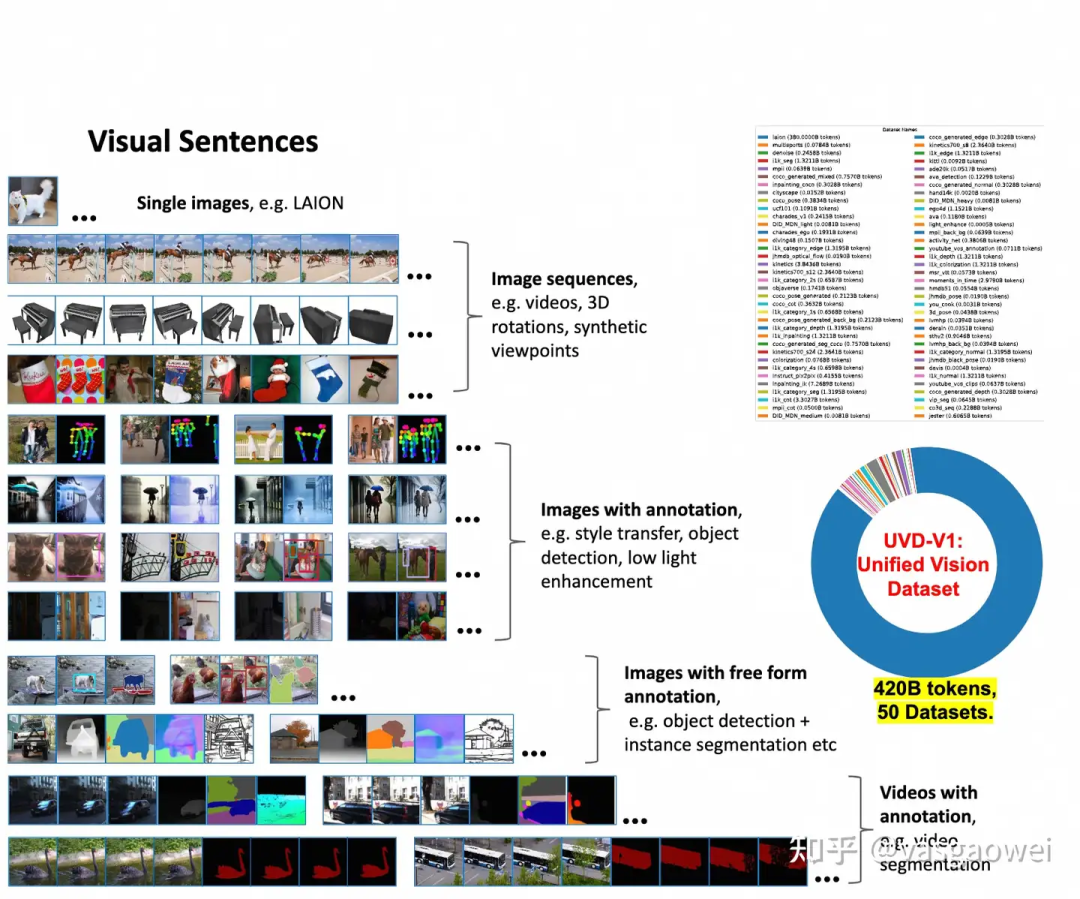

大语言模型的进展催生出了ChatGPT这样的应用,让大家对“第四次工业革命”和“AGI”的来临有了一些期待,也作为部分原因共同造就了美股2023年的繁荣。LLM和视觉的结合也越来越多:比如把LLM作为一种通用的接口,把视觉特征序列作为文本序列的PrefixToken,一起作为LLM的输入,得到图片或者视频的caption;也有把LLM和图片生成模型、视频生成模型结合的工作,以更好控制生成的内容。

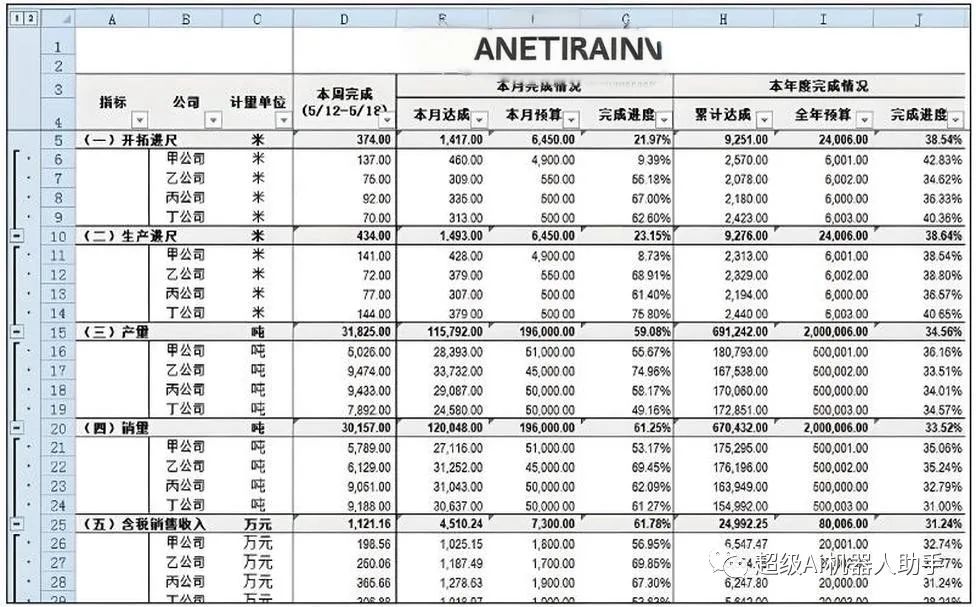

接下来,我们来聊聊报告总结。你是否有过这样的经历:你为领导做了一份报告,但是领导说你的报告说不到重点,然后你就被骂了。那么,有了AI大模型,我们可以如何解决这个问题呢?2.1 通常操作方法首先,我要告诉你,写报告总结并不是一件容易的事情。你需要从大量的数据和信息中提取关键点,然后用清晰简洁的语言表达出来。这需要你具备很强的逻辑思维能力和语言表达能力。而这个过程往往需要你花费大量的时间和精力,而且如

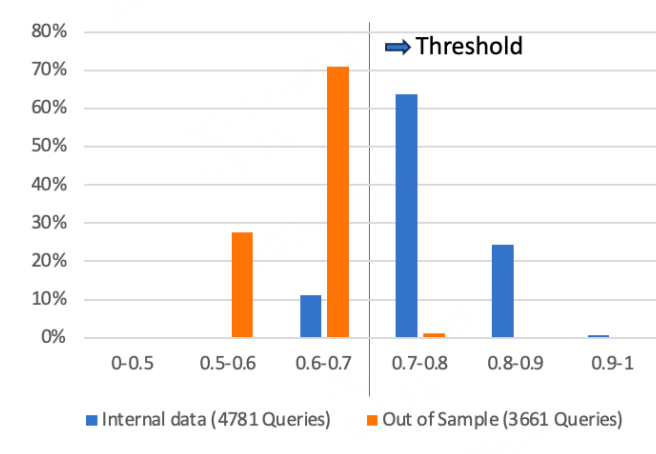

这篇文章探讨了如何在工业环境中利用大型语言模型(LLMs)进行问题回答,特别是针对客服场景提供上下文相关的响应预测。然而,为了在行业环境中针对特定客户查询提供精确和相关的信息,LLMs需要访问全面的知识库以避免产生幻觉。面对这个问题,RAG技术应运而生。然而,使用RAG开发实际应用中的问答框架仍面临几个挑战:1)数据可用性问题,2)生成内容质量的评估,3)昂贵的人工评估成本。文章提出了一个端到端的

事实上,技术进步能够给我们带来的好处是,变量X的提高使得我们训练模型所需要的时间正在逐步减少,因此对于搭建自有的大模型来说,训练多大的规模参数就需要有多大规模的算力。初代大模型的推出是具有跨时代的意义,这不仅仅是让人们充分利用到大语言模型的便利性,也为更多大语言的推出铺平了道路,例如:ChatGPT训练了几乎所有能在公开渠道找到的数据,包括全部的推特数据(事实上,今年马斯克已经限制了推特API的采

本文将以电商客服投诉信息的结构化处理为例,详细介绍如何基于LangChain框架和开源大语言模型构建垂直领域的智能应用。通过这一实例,我们将展示LangChain如何助力开发者快速构建、迭代和部署大模型应用,实现从非结构化文本到结构化数据的智能转换。

这次满足大家的需求,我将手把手带你利用dify的工作流编排能力和大型语言模型(LLM),搭建一个能“听懂”我们自然语言指令,自动查询数据库、判断图表类型,并最终生成酷炫Echarts图表的数据可视化助手!

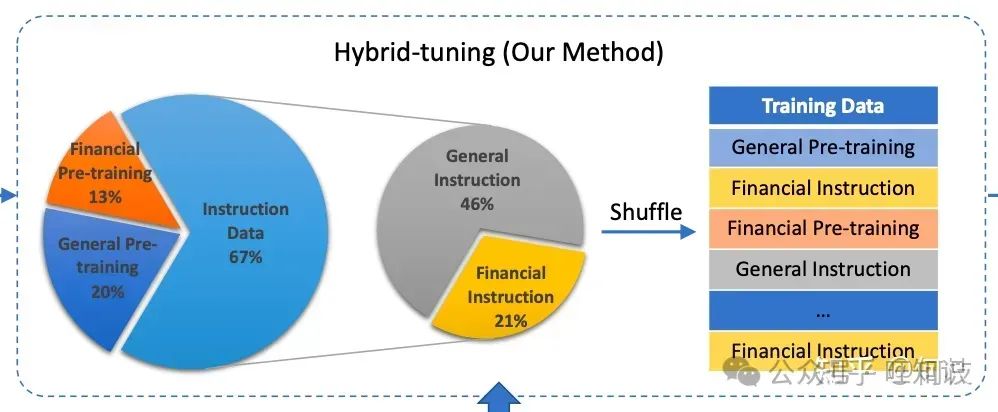

在这篇文章中,我们将尽可能详细地梳理一个完整的 LLM 训练流程。包括模型预训练(Pretrain)、Tokenizer 训练、指令微调(Instruction Tuning)、奖励模型(Reward Model)和强化学习(RLHF)等环节。

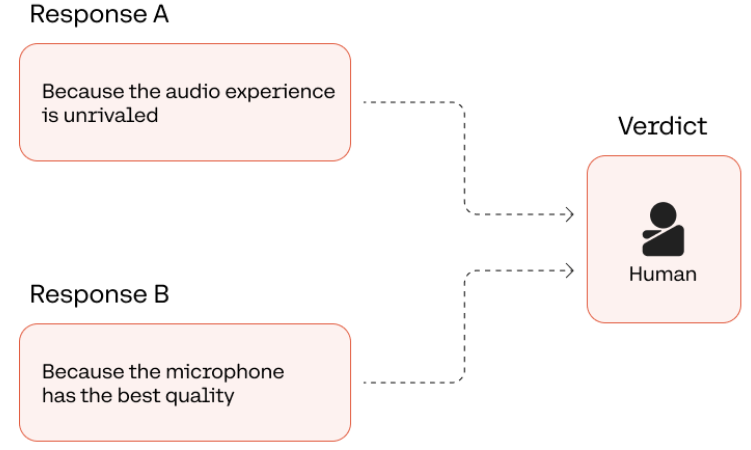

本文探讨了评估LLM输出结果的一些技术,从人工评估到自动化评估。其中:一方面,自动化评估的时间成本效率更高,在某些情况下是非常实用的选择,例如在早期原型设计阶段。另一方面,人工评估仍然是获得模型应用准确性和实用性最强评估标准。每种评估方法都有其优点以及潜在缺陷,这个也要根据具体任务具体分析。。

大语言模型 (Large Language Model,LLM) 是由具有许多参数的人工神经网络组成,使用自监督学习或半监督学习对大量未标记文本进行训练,最终可以像人类一样理解和生成文本以及其他形式的内容。大语言模型有能力从环境中推断,生成连贯且与环境相关的响应,翻译,总结文本,回答问题,甚至协助完成创造性写作或代码生成任务。被人们所熟知的大语言模型有:Open AI的Chat GPT、Meta的