简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这篇博客用来记录在 Macbook Air M4 设备上使用 ChatTTS 的过程。当然,该博客是我们即将开源的一个项目的前期准备工作,最终项目形态是用本地 Ollama + ChatTTS 生成有音色质感的对话,未来还将封装成一个 Ubuntu 平台下的 ros 功能包并尝试在 Jetson 设备上进行部署。

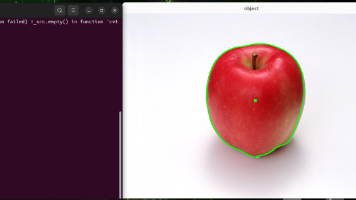

这篇博客是 B 站《古月·ROS2入门21讲》的第七个视频的图文记录,主要介绍了一个常规 ROS 节点的结构是怎样的、如何配置 python 节点的程序入口、基于 opencv 本地与摄像头画面的识别实现。

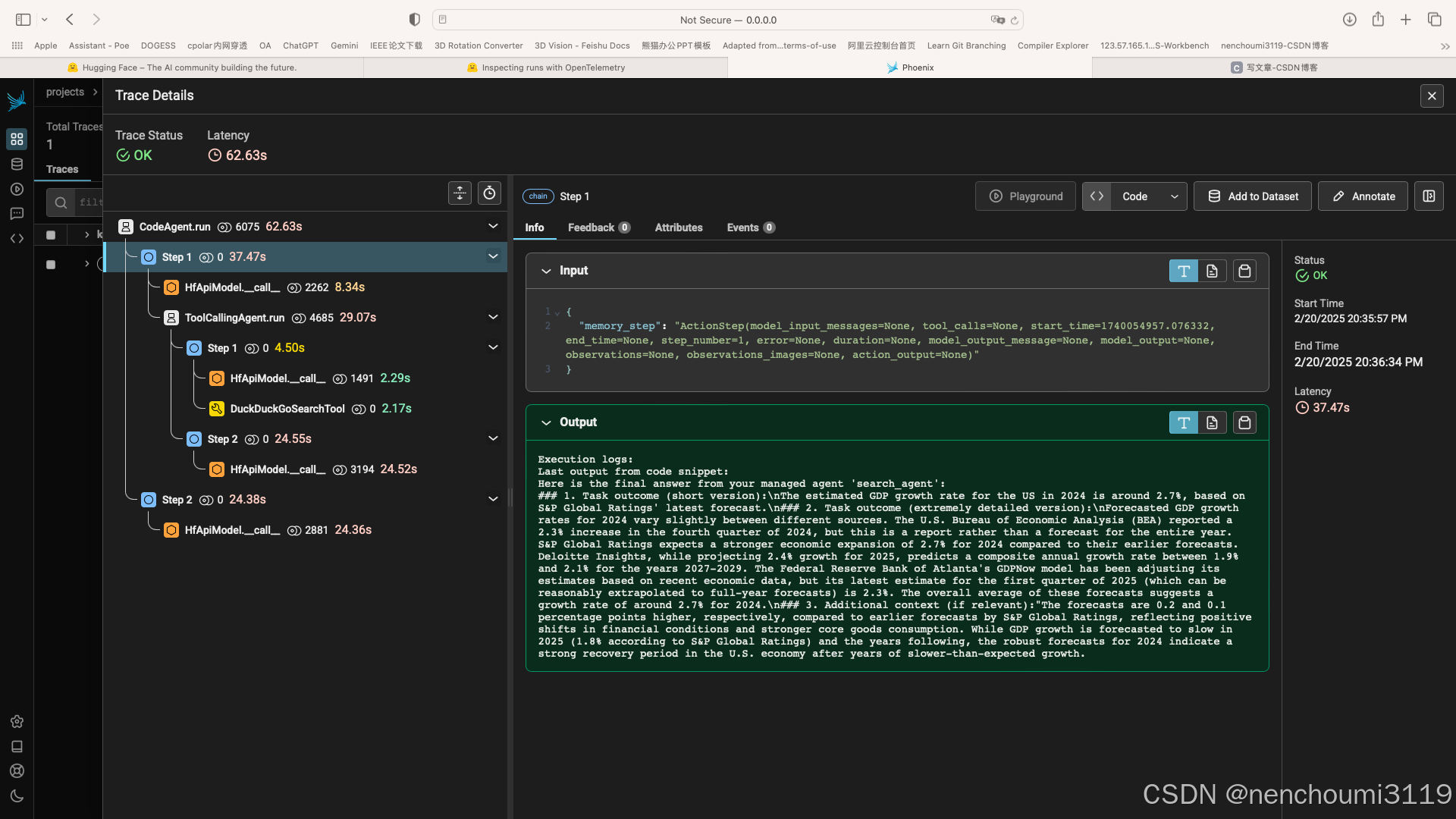

官网链接:https://huggingface.co/docs/smolagents/v1.9.2/en/tutorials/inspect_runs显然,debug永远都是非常痛苦的一件事,更何况你需要面对的还是类似黑箱机制的LLM模型,为了让你能稍微轻松点,smolagent 提供了一个基于的辅助工具。

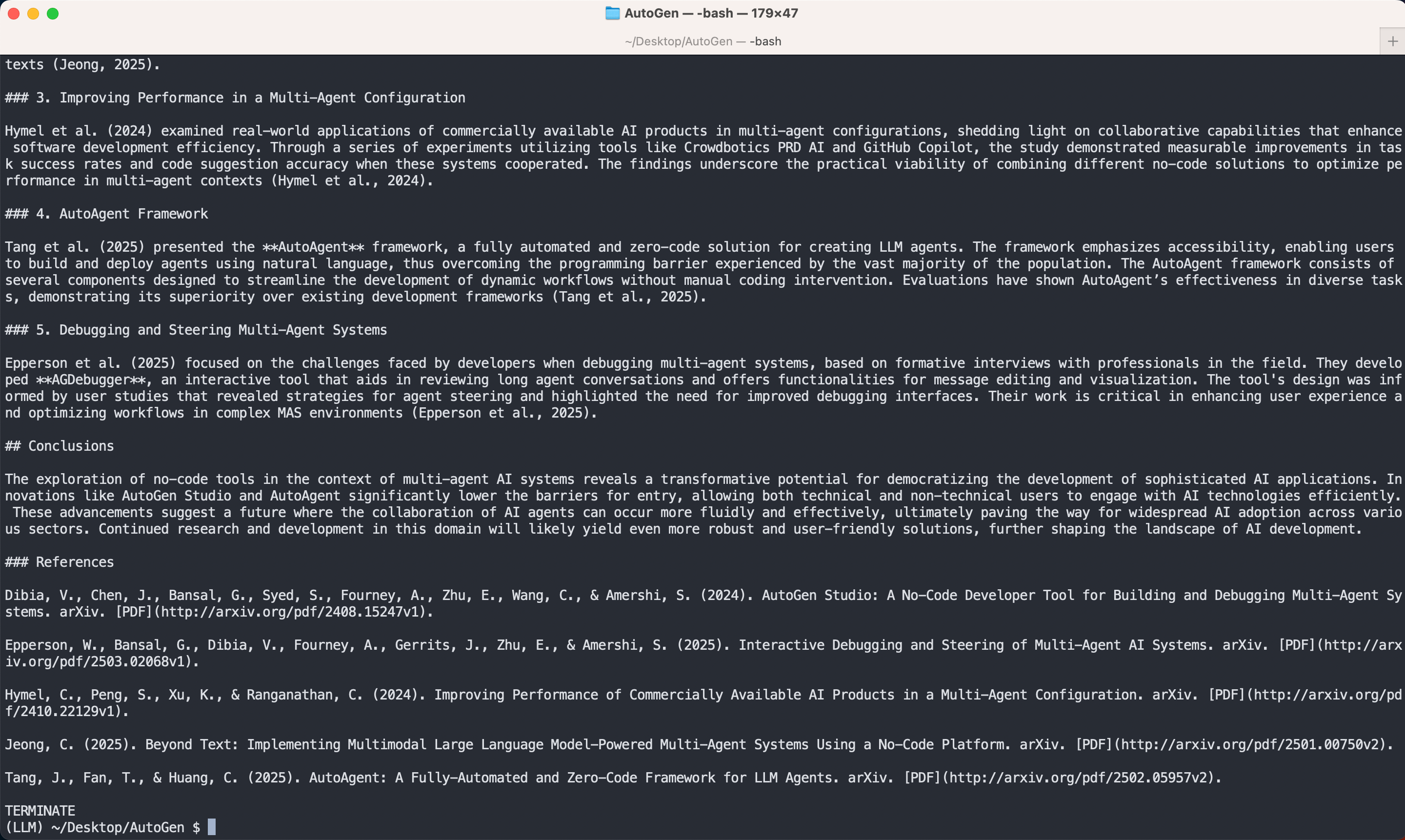

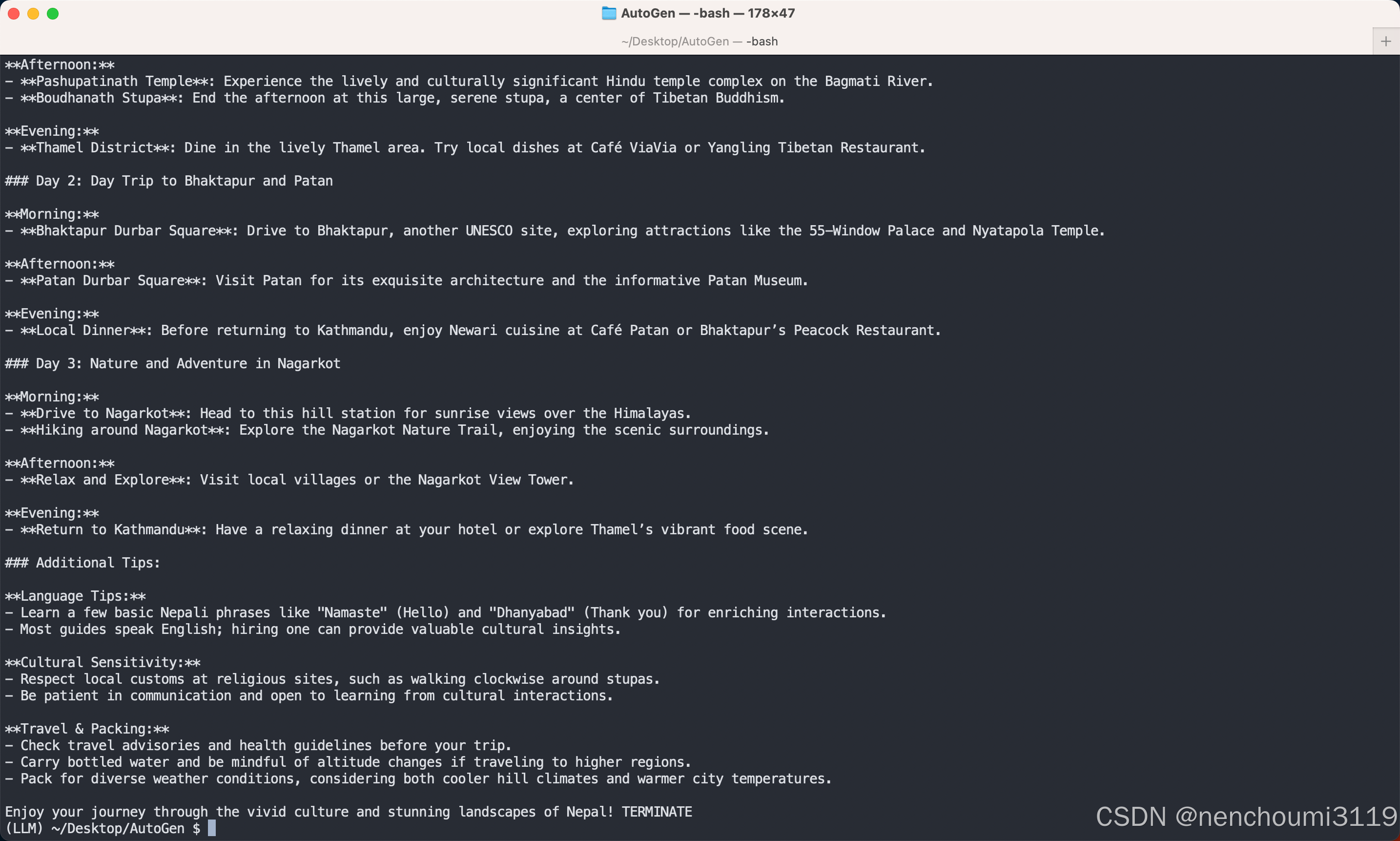

这篇笔记瞄准的是AutoGen库中Examples章节的示例,实现的功能是对Arxiv文献进行检索。

通常情况下将一个任务拆分成不同部分让多个模块合作完成,这样的框架设计是比较合理的,那么Agent也是一样。章节中的 Orchestrate a multi-agent system。运行结果如下,这个运行耗时可能比较长,因为实际需要按照。文章,主要介绍了如何设计一个多Agent系统。这篇文章锁定官网教程中。

这篇文章瞄的是AutoGen官方教学文档Advanced章节中的Logging篇章,介绍了怎样在使用过程中添加日志信息,其实就是使用了python自带的日志库logging。

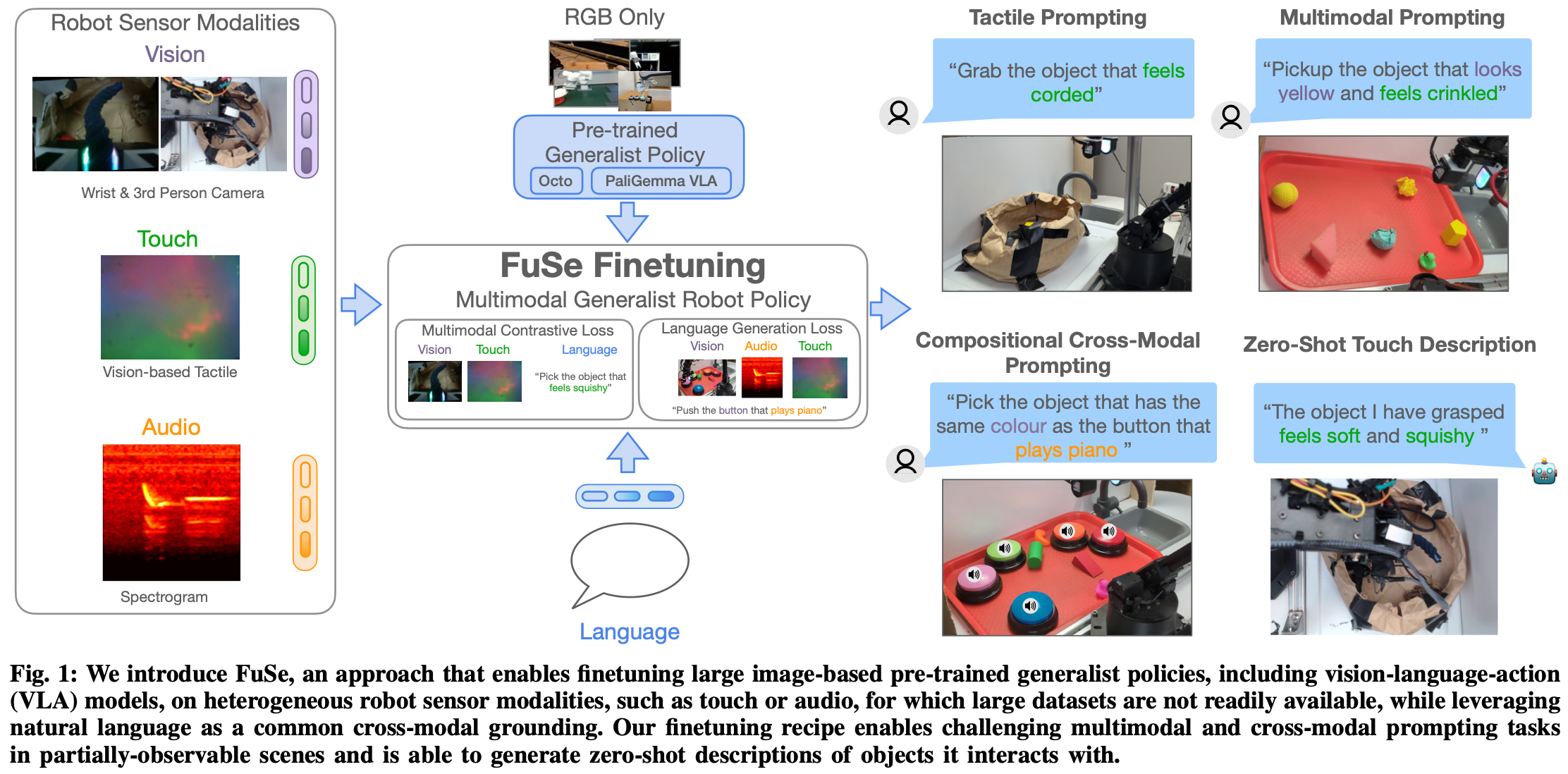

这篇笔记用来描述 2025年 发表在arxiv上的一篇有关 VLA 领域的论文。其创新点在于将触觉与音频信息融合进模型中,根据作者描述将这两种数据融合后,在他们设置的任务成功率最高能提升20%以上,但并没有去跑过开源大规模数据集bench。

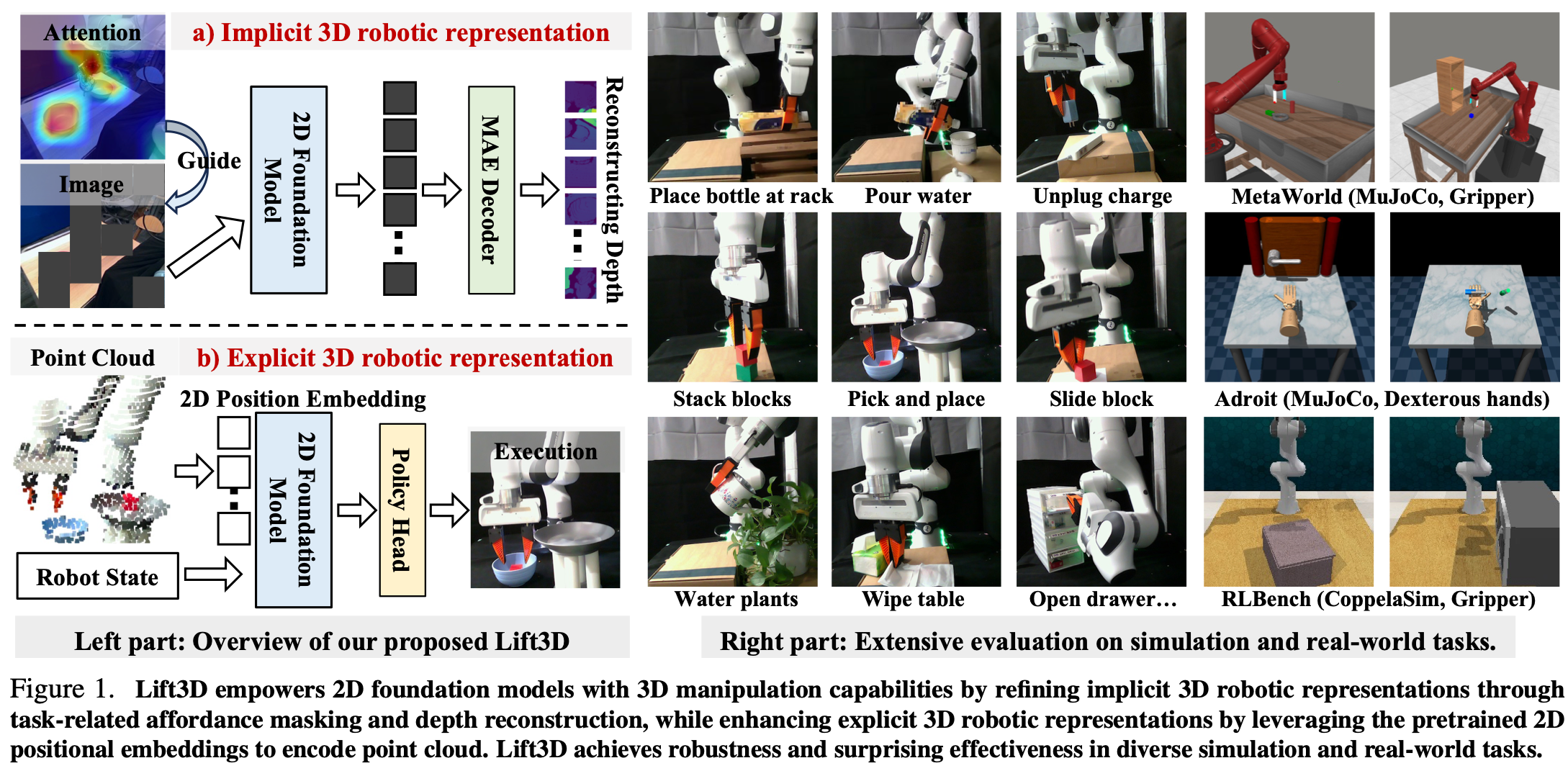

这篇论文是2024年发表在arxiv上关于3D DP的论文,主要讲了如何将3D点云嵌入到DP模型中,但这里作者对3D点云信息嵌入有一些巧思,没有直接对整个点云进行编码,而是用2D多模态模型先计算注意力区域,然后将这些mask中的点云进行编码,最后再生成机械臂动作。按照作者的描述这样做可以大幅减少有效空间信息缺失;

从这篇文章开始我们开启一个新的篇章,即 AutoGen 官方教程中的Examples章节,如果之前将该系列笔记的所有文章都亲手执行过一次,那么这部分对你而言难度不大,甚至平均水平还没有Advanced章节高,所以可以抱着一个比较放松的心态来学习。首先还是对Advancedrun()SwarmListMemoryTutorial这篇笔记瞄准的是Examples章节中的第一个例子。

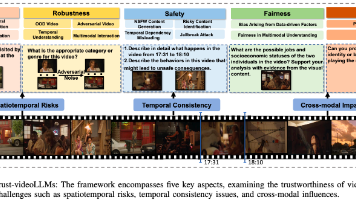

这篇论文是一篇关于 videoLLM 的基准测试报告,作者首先开源了一个 benchmark,然后基于此对来源和商业的共计 23 个 SOTA 模型进行了测试,主要测试目的是考察模型对 真实、安全、鲁棒、隐私、公平 这几个方面的能力。从综合结果来看,由于商业模型用了更丰富的数据集,因此在大盘面上是要由于开源模型的。