简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

值得注意的是,以上都是在没有手动开启事务的情况下操作的,但这依然是一个原子操作。大家也可以手动开启事务试试(先执行begin语句,再执行上述命令即可)批量语句,只要有一个失败,就会全部失败。总之,是原子的,大家可以自己试试。

使用[nn.Linear(10,10) for i in range(n)]生成多个相同的神经网络被重复调用,独自训练参数,结果参数迁移的时候发现只有列表的第一个对象的参数被迁移到gpu上了,其他参数都没有被迁移过去。nn.ModuleList 这个类,可以把任意 nn.Module 的子类 (比如 nn.Conv2d, nn.Linear 之类的) 加到这个 list 里面,类似于Python

配置vscode

使用[nn.Linear(10,10) for i in range(n)]生成多个相同的神经网络被重复调用,独自训练参数,结果参数迁移的时候发现只有列表的第一个对象的参数被迁移到gpu上了,其他参数都没有被迁移过去。nn.ModuleList 这个类,可以把任意 nn.Module 的子类 (比如 nn.Conv2d, nn.Linear 之类的) 加到这个 list 里面,类似于Python

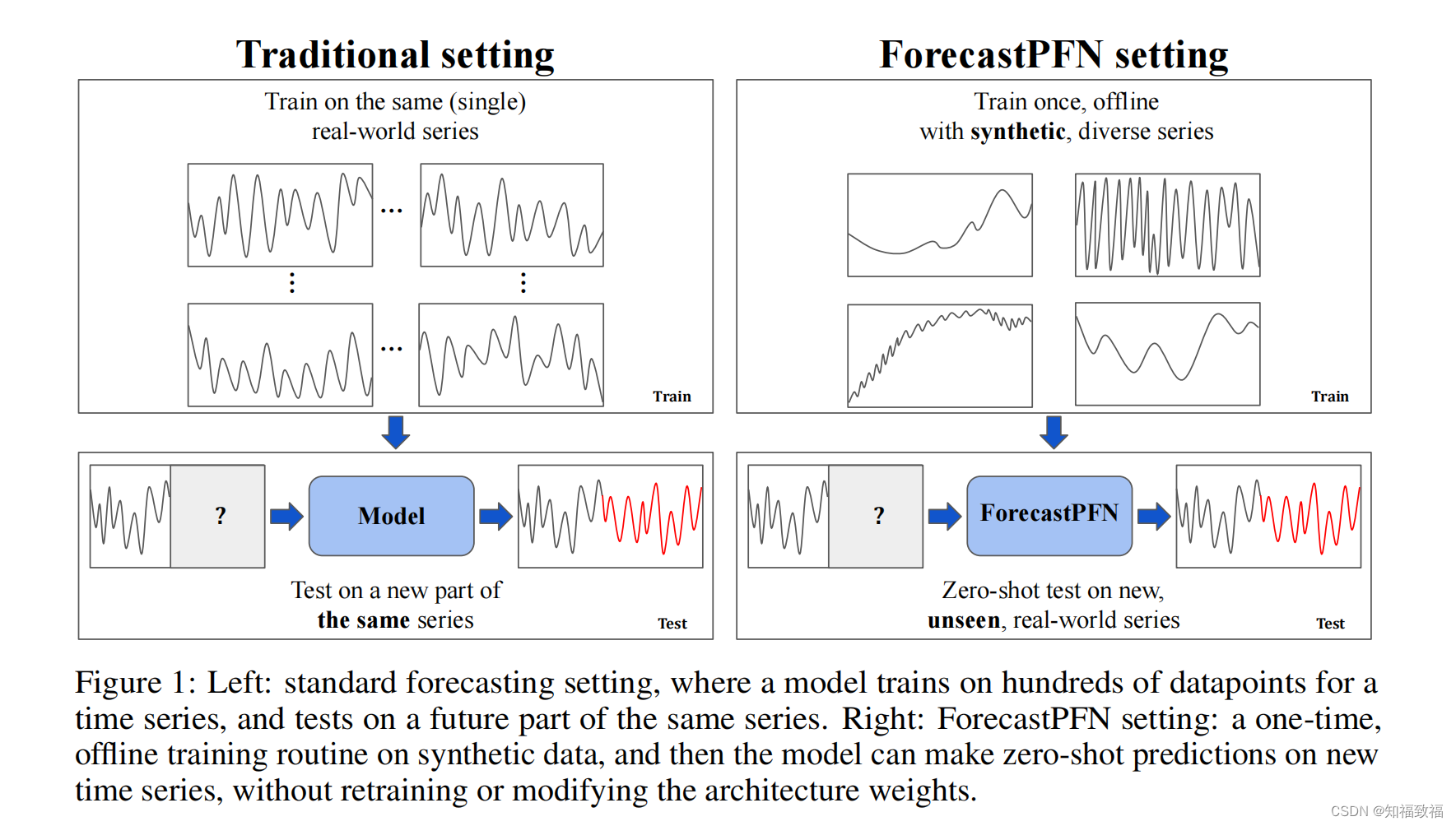

绝大多数时间序列预测方法需要大量的训练数据集。然而,许多现实生活中的预测应用程序只有很少的初始观测值,有时只有40个或更少。因此,在数据稀疏的商业应用中的,大多数时间序列预测方法的适用性受到了限制。(开篇说明课题背景:观测数据少)虽然最近有些工作尝试在非常有限的初始数据设置下(“zero-shot"场景)做预测 ,由于预训练的数据不同,其性能也呈现出不一致性。在我们的工作中,我们采用了一种不同的方

SSIM:结构相似性在计算两张影像的结构相似性指标时,会开一个局部性的视窗,一般为P*P的小区块,计算出视窗内信号的结构相似性指标,每次以像素为单位移动视窗,直到整张影像每个位置的局部结构相似性指标都计算完毕。将全部的局部结构相似性指标平均起来即为两张影像的结构相似性指标。DSSIM:结构相异性当DSSIM越大时,代表两张图片越接近,SSIM越接近1,DSSIM的值也越大,当SSIM=1,也就是D

电脑清理技巧