简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文详细介绍Agent Skills的配置方法,强调技能要精准描述、分层管理和保持关联性,避免"越多越好"的误区。通过销售数据分析助手的实战案例,展示如何设计单一技能和工作流,并提供技能描述技巧、参数示例和错误处理等实用建议。作者强调,好的Agent不在于技能数量,而在于精准使用和持续优化,这是一个需要不断迭代的过程。

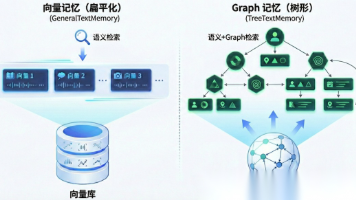

本文详细介绍了MemOS智能体记忆开源框架的Graph记忆图谱能力与LangChain集成实践。展示了如何基于MemOS构建带记忆能力的ChatBot,体验记忆图谱的自动重组功能,并通过Middleware机制将MemOS无缝集成到LangChain智能体中,实现长期记忆与知识积累。这种架构使AI Agent具备超越会话上下文的持久记忆能力,为个性化服务和复杂任务处理提供了强大支持。

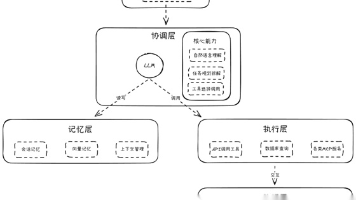

随着人工智能技术的不断进步,Agent(智能体)和大模型(深度学习模型)作为其中的两个关键组成部分,各自发挥着独特的作用。它们虽然同属于人工智能领域,但在设计目标、应用场景、工作原理等方面存在着显著的差异。智能体(Agent)概述智能体是一种能够感知环境、做出决策并执行行动的自主实体。它具备自主性、交互性、反应性和主动性等特点,能够在各种实际操作和控制场景中发挥重要作用。智能体的设计目标是实现对环

文章探讨了AI应用从"顾问"到"执行者"的范式转变,介绍了AI Workflow和AI Agent两种设计模式,并使用LangChain框架进行实践。通过实际案例展示了如何构建稳定的工作流和自主智能体,并讨论了混合架构和MCP协议在企业级应用中的价值。文章强调AI不应仅停留在问答阶段,而应落地为实际业务工具,解决工作中的实际问题。

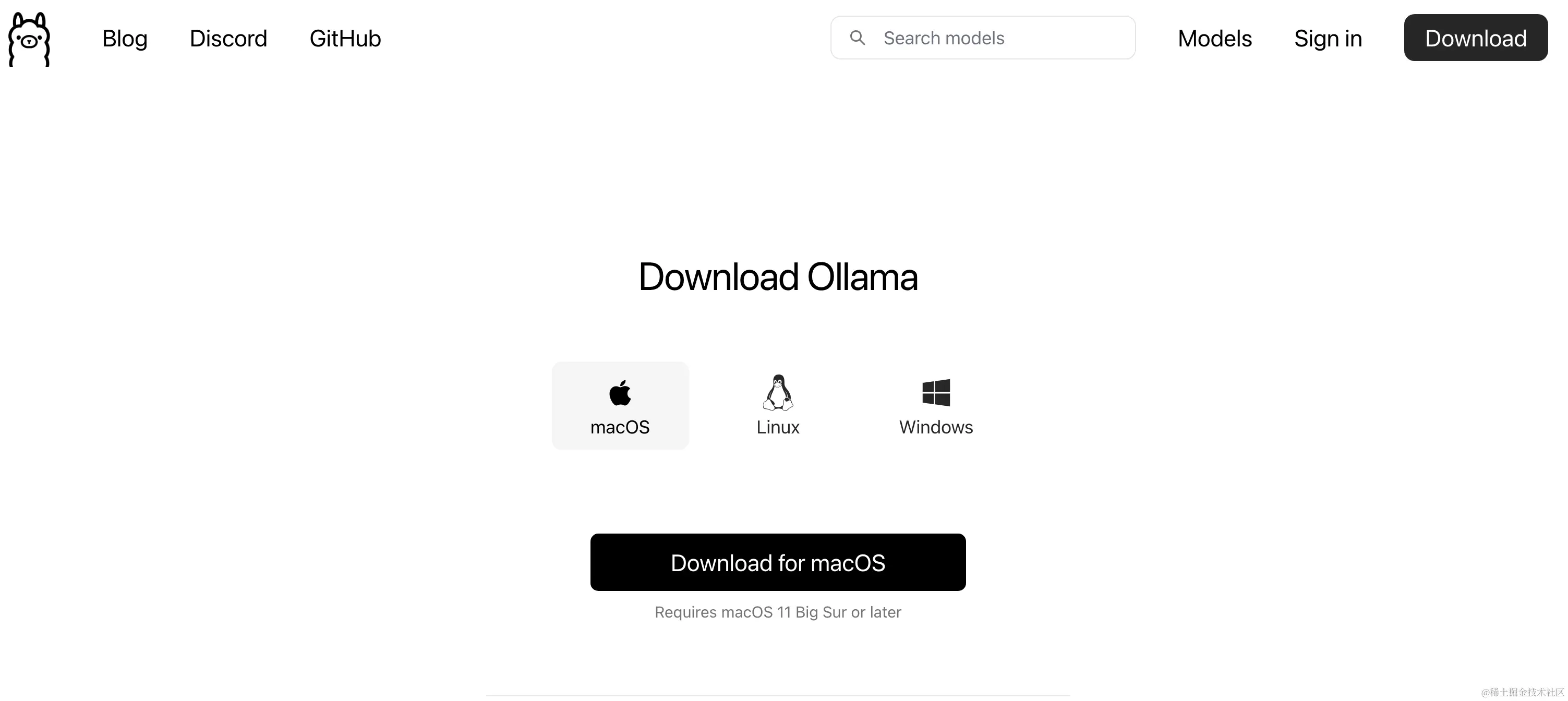

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

本文全面介绍了上下文工程的概念与实施方法。上下文工程是在恰当时间、以恰当形式将恰当信息提供给大语言模型(LLM)的艺术与科学。作者将LLM比作CPU,上下文窗口比作RAM,并详细阐述了六种上下文类型:指令、示例、知识、记忆、工具和护栏。文章将上下文工程分解为四个基本阶段:编写、选择、压缩和隔离上下文,通过精心设计上下文工程,可以显著提升AI智能体的性能和响应准确性。

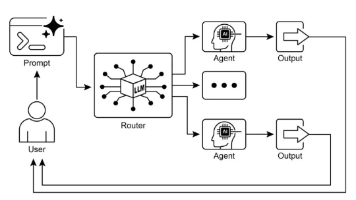

路由模式是智能体系统的动态决策机制,根据环境状态、用户输入或前序操作结果选择最优处理路径。文章详解其定义、价值、四种主流实现方式(基于LLM、嵌入、规则、机器学习)、典型应用场景、落地步骤及工具框架,帮助开发者构建从"固定流程"到"动态决策"的智能体系统,解决灵活性差、上下文感知弱、扩展性差等核心痛点。

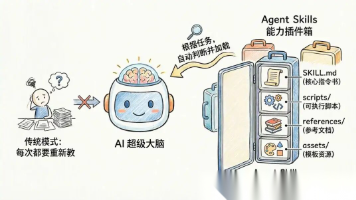

Agent Skills是Anthropic推出的模块化能力插件标准,通过文件系统实现渐进式披露机制,按需加载AI能力。相比MCP,Skills大幅降低Token消耗并提升工具调用准确性。Skills将重复性专业流程封装,用户无需每次输入冗长提示词,而是像调用工具一样使用。社区已涌现大量开源Skills,使AI能力扩展门槛大幅降低,成为Agent领域又一重要标准实践。