简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650): 24GB+ 显存(如 A100 40GB 或双卡 RTX 3090): 多卡并行(如 2x A100 80GB 或 4x RTX 4090): 16GB+ 显存(如 RTX 4090 或 A5000): 推荐 8GB+ 显存(如 RTX 3070/4060): 3GB+ 存储空间(模型文件约 1.5-2GB

用Rag技术搭建一个本地的个人助手,使用的是AnythingLLM+DeepSeek的组合。体验下来,这个只能作为或体验之类的,很难真正实现一个工程性需求。

文章目录一、低代码平台分析二、低代码平台清单1.青锋2.JEECG3.Z平台4.JVS5.J2PaaS【值得借鉴】==6.简道云【帆软】==7.IVX8.氚云【阿里战投】==9.宜搭【阿里背书】====10.微搭【腾讯云】==11.华炎魔方==12.明道云==13.mometa14.爱速搭[百度]15.应用魔方【华为】16.==轻流【商业浓】==一、低代码平台分析2018年,一个低代码快速应用开发

对抗蒸馏框架概述:我们基于高级闭源LLM的基础上提炼一个学生LLM,该LLM具有三个角色:教师、裁判和生成器。有三个迭代阶段:模仿阶段,对于一组指令,将学生的响应与老师的响应对齐;区分阶段,识别出难指令;生成阶段,根据识别出的难指令,产生新的难指令以增加对学生模型的挑战。

CPM全称Chinese Pretrained Model,Bee是该系列模型的第二个里程碑版本。CPM-Bee模型是基于CPM-Ant模型继续训练得到。后者是2022年5月到9月训练的大语言模型。而CPM-Bee则是从2022年10月13日开启训练,相比之前,模型在很多任务上做了优化,包括文字填空、文本生成、问答等。这是一个基于transformer架构的自回归模型,在高质量的中英文数据集上训练

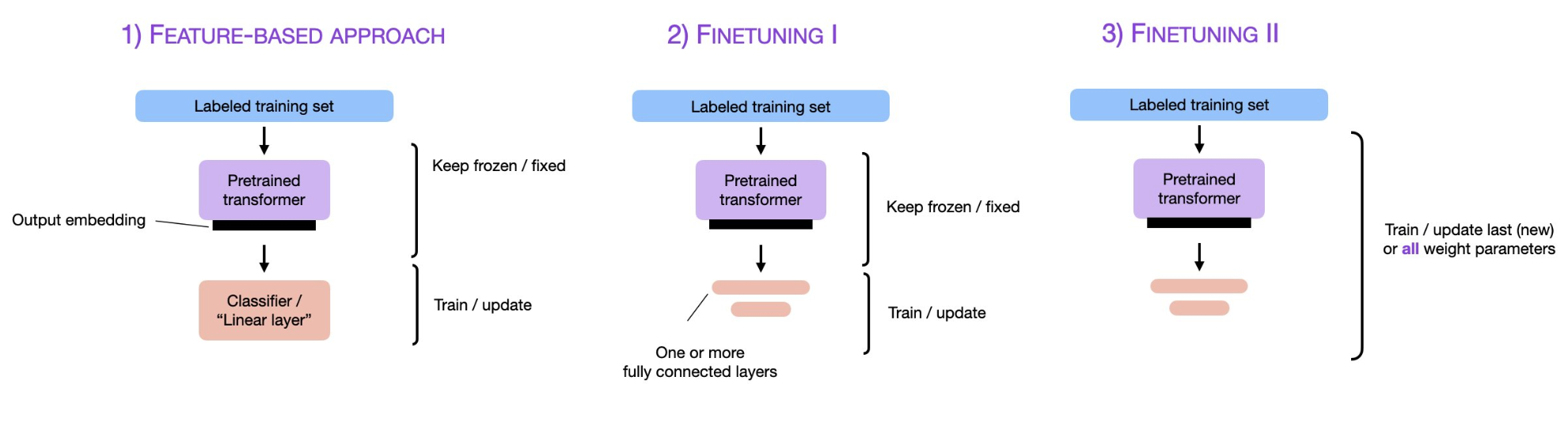

其实,从上述的总结中大家可以看到,微调技术的发展似乎与模型的发展规模息息相关。最早出现fine-tuning也是模型变大之后,使用原有模型的架构在新数据上训练成本过高且丢失了原有模型的能力,后来也是因为模型发展的规模增长远远超过硬件性能的发展,导致更加高效的微调技术出现。而当前最火热的prompt-tuning其实也就是几乎根本无法微调大模型而产生的一种替代方式。当然,模型本身能力的强大也使得该方

用Rag技术搭建一个本地的个人助手,使用的是AnythingLLM+DeepSeek的组合。体验下来,这个只能作为或体验之类的,很难真正实现一个工程性需求。

本篇文章共 25027 个词,一个字一个字手码的不容易,转载请标明出处:预训练语言模型的前世今生 - 从Word Embedding到BERT - 二十三岁的有德本文的主题是预训练语言模型的前世今生,会大致说下 NLP 中的预训练技术是一步一步如何发展到 Bert 模型的,从中可以很自然地看到 Bert 的思路是如何逐渐形成的,Bert 的历史沿革是什么,继承了什么,创新了什么,为什么效果那么好,

CPM全称Chinese Pretrained Model,Bee是该系列模型的第二个里程碑版本。CPM-Bee模型是基于CPM-Ant模型继续训练得到。后者是2022年5月到9月训练的大语言模型。而CPM-Bee则是从2022年10月13日开启训练,相比之前,模型在很多任务上做了优化,包括文字填空、文本生成、问答等。这是一个基于transformer架构的自回归模型,在高质量的中英文数据集上训练

通过上述的讲解,对图像预训练做个总结(可参照上图):对于一个具有少量数据的任务 A,首先通过一个现有的大量数据搭建一个 CNN 模型 A,由于 CNN的浅层学到的特征通用性特别强,因此在搭建一个 CNN 模型 B,其中模型 B 的浅层参数使用模型 A 的浅层参数,模型 B 的高层参数随机初始化,然后通过冻结或微调的方式利用任务 A 的数据训练模型 B,模型 B 就是对应任务 A 的模型。这其实是