简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

国内人形机器人行业快速发展,多家新兴企业崭露头角。智元机器人(上海)由华为前高管创立,获高瓴、红杉等投资,估值150亿元,产品远征A1拥有40+自由度。宇树科技(杭州)专注工业应用,其H1机器人扭矩达240Nm。傅里叶智能(上海)依托上海交大,研发康养机器人GR-1。星动纪元(北京)由清华孵化,获5亿元融资,L7机器人速度达3.6m/s。银河通用(北京)与北大合作研发工业机器人Galbot G1。

python 版本: 3.10.12。

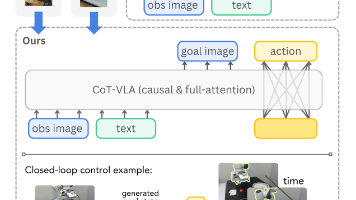

│ VLA 模型演进路线 ││ ││ 第一代 VLA(RT-2, OpenVLA) ││ └── 离散动作 token,精度低,速度慢 ││ │ ││ ▼ ││ ├── Flow Matching 连续动作 ││ ├── 双专家架构 ││ └── 灵巧操作能力强,但泛化有限 ││ │ ││ ▼ ││ ├── Co-Training 多源数据 ││ ├── 层次化推理 ││ └── 开放世界泛化能力

│ VLA 模型演进路线 ││ ││ 第一代 VLA(RT-2, OpenVLA) ││ └── 离散动作 token,精度低,速度慢 ││ │ ││ ▼ ││ ├── Flow Matching 连续动作 ││ ├── 双专家架构 ││ └── 灵巧操作能力强,但泛化有限 ││ │ ││ ▼ ││ ├── Co-Training 多源数据 ││ ├── 层次化推理 ││ └── 开放世界泛化能力

科研中最重要的2件事: 阅读文献和写代码。推荐2款大模型工具, 极大地提升科研效率!

CoT-VLA 用一张“想象中的未来照片”把大语言模型的“逐步思考”搬进机器人世界,让动作不再黑箱,让数据不再昂贵。留给我们的启发当 AI“会说会画”之后,“会想象”可能是通往通用机器人的下一站;若手机里的短视频都能变成机器人“脑内小剧场”,低成本大规模训练不再是梦。

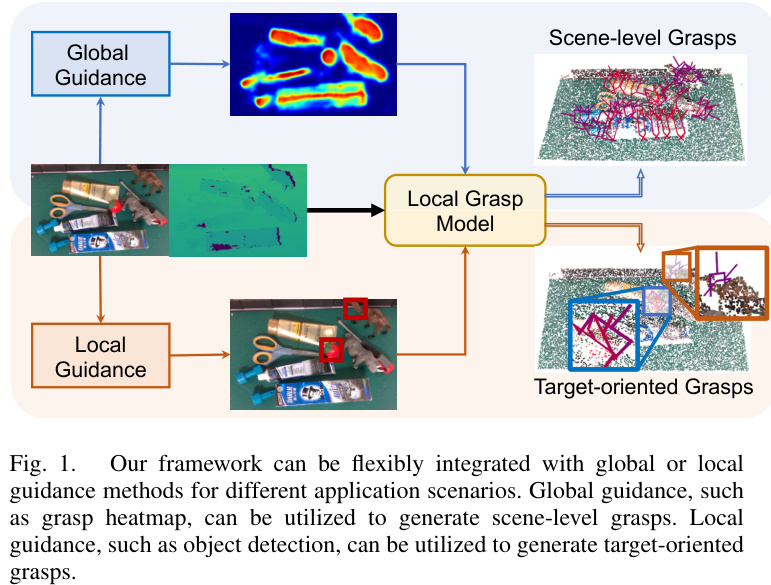

首先,定义了两种抓取性分数:点抓取性分数SpSp和视图抓取性分数SvSv。点抓取性分数表示每个点的抓取可能性,视图抓取性分数表示每个视图的抓取可能性。

你是否听说过一种能在程序运行时,动态修改甚至替换代码的“黑魔法”?它无需改动任何源代码文件,仅凭一行赋值语句,就能让一个库、一个类的行为发生翻天覆地的变化。这就是在 Python 等动态语言中既强大又危险的技术——猴子补丁 (Monkey-Patching)。本文将从一个生动的比喻入手,通过代码示例,最终揭示像Unsloth这样的高性能AI库是如何利用它来“魔改”HuggingFace Trans

假设你已经有了一个可以正常运行的单卡PyTorch训练脚本,现在想让它支持高效的多卡训练。这些繁琐的配置劝退了无数开发者。本文将为你介绍 Hugging Face 的。库,并与原生DDP做清晰对比,让你明白它如何用最少的代码,实现最优雅的多卡训练。你的脚本现在已经具备了在任何硬件上高效运行的能力。如果你想用原生PyTorch DDP进行多卡训练,你。标题:PyTorch分布式训练太复杂?:三行代码

这篇论文提出了一种灵活的 6-Dof 抓取检测框架 FlexLoG,通过局部抓取模型和灵活引导模块,能够处理场景级和目标导向抓取。:在 GraspNet-1Billion 数据集上,FlexLoG 在相似和新颖的分割上分别实现了 10.4/9.83 和5.73/3.89 的性能提升,优于现有方法。:FGM 能够兼容全局(如抓取热图)和局部(如视觉定位)引导方法,生成高质量的抓取。LoG 采用基于