简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

人工智能是让机器获得像人类一样具有思考和推理机制的智能技术,这一概念最早出现在 1956 年召开的达特茅斯会议上。其中深度学习可以理解为神经网络。刚开始只有神经网络的概念,随着神经网络的层数增加,就逐渐将神经网络叫做深度学习。神经网络的发展历程大致分为浅层神经网络阶段和深度学习阶段。

通过 堆叠两层3 × 3 3\times33×3的卷积核可以替代一层5 × 5 的卷积核,堆叠三层 3 × 3 的卷积核替代一层 7 × 7 的卷积核,可以看出,大卷积核完全可以由一系列 的3 × 3 卷积核来替代,那能不能再分解得更小一点呢?从上图可以看出,计算量主要来自高维卷积核的卷积操作,因而在每一个 卷积前先使用1 × 1卷积核将输入图片的feature map维度先降低,进行信息压 缩,

迁移学习(Transfer Learning)是一种机器学习方法,就是把为任务 A 开发 的模型作为初始点,重新使用在为任务 B 开发模型的过程中。迁移学习是通过 从已学习的相关任务中转移知识来改进学习的新任务,虽然大多数机器学习算 法都是为了解决单个任务而设计的,但是促进迁移学习的算法的开发是机器学 习社区持续关注的话题。迁移学习对人类来说很常见,例如,我们可能会发现 学习识别苹果可能有助于识别

2010年至2020年二次担任美国视觉、认知科学、AI领域跨学科合作项目MURI首席科学家;朱松纯的主要研究包括通用人工智能基础、计算机视觉、统计建模与计算、认知科学、机器学习、自主机器人等,长期致力于构建人工智能科学的统一数理框架( [3])。朱松纯(Song-Chun ZHU),1968年出生于湖北鄂州( [22]),博士,计算机视觉专家、统计与应用数学家、人工智能专家,( [18]),并当选

人工智能是让机器获得像人类一样具有思考和推理机制的智能技术,这一概念最早出现在 1956 年召开的达特茅斯会议上。其中深度学习可以理解为神经网络。刚开始只有神经网络的概念,随着神经网络的层数增加,就逐渐将神经网络叫做深度学习。神经网络的发展历程大致分为浅层神经网络阶段和深度学习阶段。

在很多模式识别的领域、手写文字的识别、字符识别、简单的人脸识别也开始用起来,这个领域一下子就热起来,一时之间,人们感觉人工智能大有可为。在某一定值以下,就不会兴奋。然而逻辑主义最后无法解决实用的问题,达不到人们对它的期望,引起了大家的反思,这时候人工神经网络(也就是联结主义)就慢慢占了上风。要想证明这些问题,需要把原来的条件和定义从形式化变成逻辑表达,然后用逻辑的方法去证明最后的结论是对的还是错的

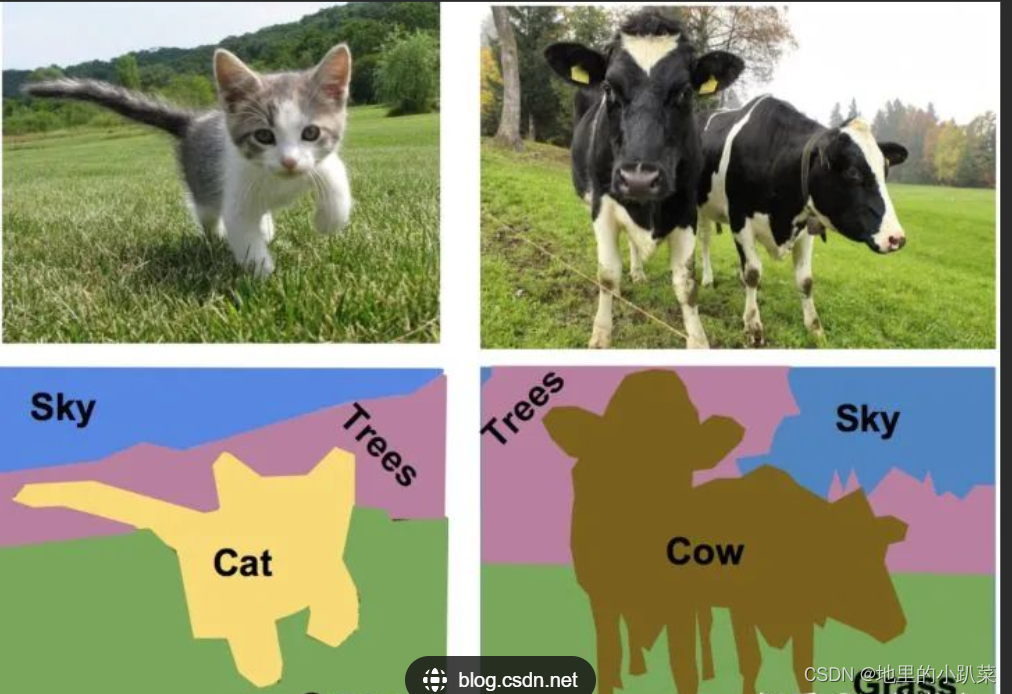

分类最终体现在对每个潜在框分类的11channel上,每个channel代表一个 分类,取值最大的channel作为最终分类;位置信息会用4个值来保存:被分类 的物体中它的框的坐标则为左上角的x和y坐标,以及宽和高的尺寸。对于语义分割来说,它提供的信息中位置信息和分类信息是有重叠的,即 通过标记每个像素的分类,同时也达到提供位置信息。目标检测的任务是对输入的图像进行物体检测,标注物体在图像上的位

2010年至2020年二次担任美国视觉、认知科学、AI领域跨学科合作项目MURI首席科学家;朱松纯的主要研究包括通用人工智能基础、计算机视觉、统计建模与计算、认知科学、机器学习、自主机器人等,长期致力于构建人工智能科学的统一数理框架( [3])。朱松纯(Song-Chun ZHU),1968年出生于湖北鄂州( [22]),博士,计算机视觉专家、统计与应用数学家、人工智能专家,( [18]),并当选

本文首先将介绍在目标跟踪任务中常用的和,然后介绍经典算法的工作流程以及对相关源码进行解析。YOLOv4+DeepSort实现行人追踪轨迹提取目前主流的目标跟踪算法都是基于策略,即基于目标检测的结果来进行目标跟踪。DeepSORT运用的就是这个策略,上面的视频是DeepSORT对人群进行跟踪的结果,每个bbox左上角的数字是用来标识某个人的唯一ID号。这里就有个问题,视频中不同时刻的同一个人,位置发

gain = torch.ones(7, device=targets.device),gain是输出的channel数, 包含image,class,x,y,w,h,conf。我们知道目标检测难点一直是对小目标的检测定位,主要原因是, 第一,coco数据集中大中小目标占比不均衡,小目标的数量很多,但出现的频 率却很低,这导致bp时对小目标的优化不足。作者提出Mosaic,随机使用4张图片,随机缩