简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

简单来说,Agent Skills 是一组可复用的模块化能力,它们包含具体的说明、元数据和可选资源(比如脚本、模板等),能够扩展 Claude 的功能。Skills 能让 Claude 在遇到特定任务时自动触发并加载相关逻辑,而不需要每次都重复写提示语。让 Claude 更专业 (Specialize Claude):为特定领域或任务定制专属能力减少重复工作 (Reduce repetition)

向量数据库是一种专门用于**存储、索引和搜索高维向量(通常是嵌入)**的数据库,广泛用于 AI / NLP / 计算机视觉 / 语义搜索 / 推荐系统等场景。向量数据库已经成为现代 AI 系统(尤其是 RAG)的核心基础设施。根据你的技术背景和业务需求,选择一个合适的数据库可以大大提高开发效率与产品性能。

随着自然语言处理(NLP)技术的飞速发展,传统的稀疏检索方法逐渐面临着密集检索技术的挑战。本文将介绍稀疏检索、密集检索与混合检索的基本概念,比较它们的优缺点,并介绍实现这些检索方法时所需的技术。随着信息检索需求的不断发展,稀疏检索、密集检索和混合检索都在各自的应用领域中发挥着重要作用。混合检索是结合稀疏检索和密集检索的优点的一种检索方法。通常,混合检索会首先使用稀疏检索(如BM25)从大量文档中快

CLIP,全称为Contrastive Language–Image Pre-training(对比语言-图像预训练),是一种跨模态模型。它的目标是学习一个可以同时理解图像和语言的通用视觉-语言表示空间。传统图像识别模型需要在每个任务上进行微调(fine-tuning),但 CLIP 只需简单的自然语言提示(prompt),就可以实现零样本图像分类(zero-shot classification

NVIDIA 作为全球领先的 GPU 供应商,其产品广泛应用于人工智能 (AI)、高性能计算 (HPC)、游戏、工作站和嵌入式系统等领域。本文将详细介绍 NVIDIA 主要的 GPU 系列,包括其特点和应用场景。

规划(Planing)子目标和分解(Subgoal and decomposition):代理将大型任务分解为更小的、可管理的子目标,从而能够有效地处理复杂的任务。反思和完善(Reflection and refinement):智能体可以对过去的行为进行自我批评和自我反思,从错误中吸取教训,并针对未来的步骤进行完善,从而提高最终结果的质量。记忆 (Memory)短期记忆(Short-term m

系列文章目录深度学习GAN(一)之简单介绍深度学习GAN(二)之DCGAN基于CIFAR10数据集的例子深度学习GAN(三)之DCGAN基于手写体Mnist数据集的例子深度学习GAN(四)之cGAN (Conditional GAN)的例子深度学习GAN(五)之PIX2PIX GAN的例子深度学习GAN(六)之CycleGAN的例子Pix2Pix GAN的例子系列文章目录1. Pix2Pix介绍2

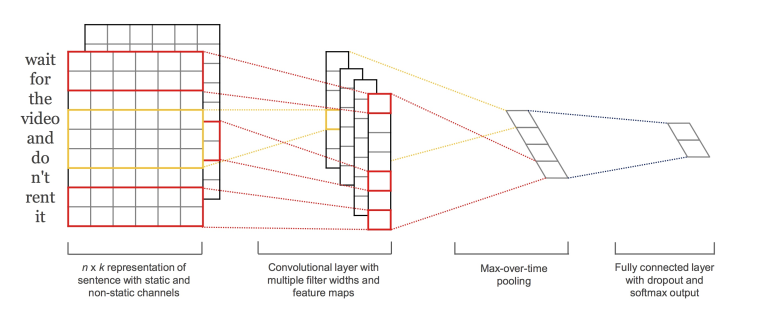

使用Tensorflow的Keras搭建卷积神经网络来进行情感分析在自然语言领域,卷积的作用在于利用文字的局部特征。一个词的前后几个词必然和这个词本身相关,这组成该词所代表的词群。词群进而会对段落文字的意思进行影响,决定这个段落到底是正向的还是负向的。对比传统方法,利用词包,和TF-IDF 等,其思想有相通之处。但最大的不同点在于,传统方法是人为构造用于分类的特征,而深度学习中的卷积让神经网络去构

LeNet5LeNet5不是CNN的起点,但却是它的hello world,让大家看到了卷积神经网络商用的前景。AlexNet是CNN向大规模商用打响的第一枪,夺得ImageNet 2012年分类冠军,宣告神经网络的王者归来。VGG以其简单的结构,在提出的若干年内在各大计算机视觉领域都成为了最广泛使用的benchmark。它们都有着简单而又优雅的结构,同出一门。诠释了增加深度是如何提高了深度...

深度学习的训练过程是指通过大量的数据来调整神经网络的参数,以使其能够对输入数据进行准确的预测或分类.