简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Anthropic的Claude Cowork智能体及其插件被视为AI从辅助工具向独立员工跨越的分水岭,能自主完成复杂工作。这一技术引发华尔街恐慌,导致多家软件公司股票被抛售,市场担忧AI将颠覆SaaS商业模式。Claude Cowork可在隔离环境中接管用户电脑执行多领域任务,可能减少企业对外部软件服务的依赖,威胁传统软件行业。AI 在代替人类之前,先要替代一大波软件?

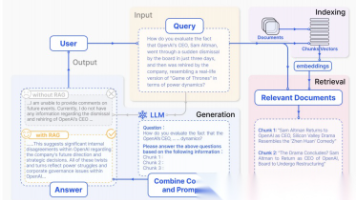

文章介绍Ollama+RAG+ChromaDB组合解决方案,解决AI模型记忆力有限问题。Ollama作为本地AI大脑,RAG实现检索增强生成,ChromaDB作为语义向量数据库存储知识。该组合使AI能基于最新、准确的信息回答,同时保持完全本地化、低成本,适用于客服、培训、知识管理等场景。但需注意知识库维护和文档质量对回答准确性的影响。

选择RAG的场景• 需要实时更新的知识(如新闻、股价)• 数据量庞大且频繁变动• 需要解释性强的应用场景(可溯源到具体文档)• 预算有限,无法承担微调成本选择Fine-tuning的场景• 需要改变模型行为风格(如特定语气、格式)• 领域知识非常固定且通用模型表现极差• 对延迟敏感(RAG需要额外检索时间)

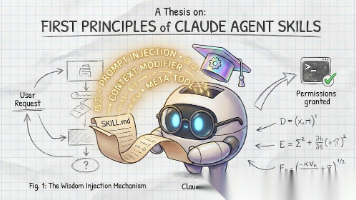

Claude 利用Skills来提升特定任务的执行效果。Skills被定义为包含指令、脚本和资源的文件夹,Claude可以在需要时加载它们。Claude 采用声明式、基于提示词的系统来实现Skills的发现和调用。AI 模型(Claude)根据系统提示中提供的文本描述来决定是否调用Skills。在代码层面,不存在算法驱动的Skills选择或 AI 驱动的意图检测。所有的决策都完全基于Skills描

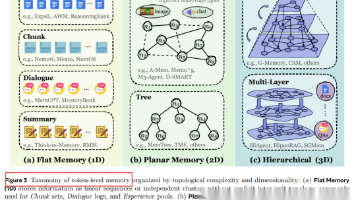

Memory in the Age of AI Agents》是由多所顶尖大学联合推出的系统性综述,创新提出"形态-功能-动力学"三维框架分析200+最新论文。文章突破传统记忆二分法,提出Token-level/Parametric/Latent三大记忆形态,系统阐述记忆形成、演化与检索的完整生命周期。同时展望生成式记忆、自动管理等7大前沿方向,为AI Agent记忆研究提供全面指导,是了解该领域

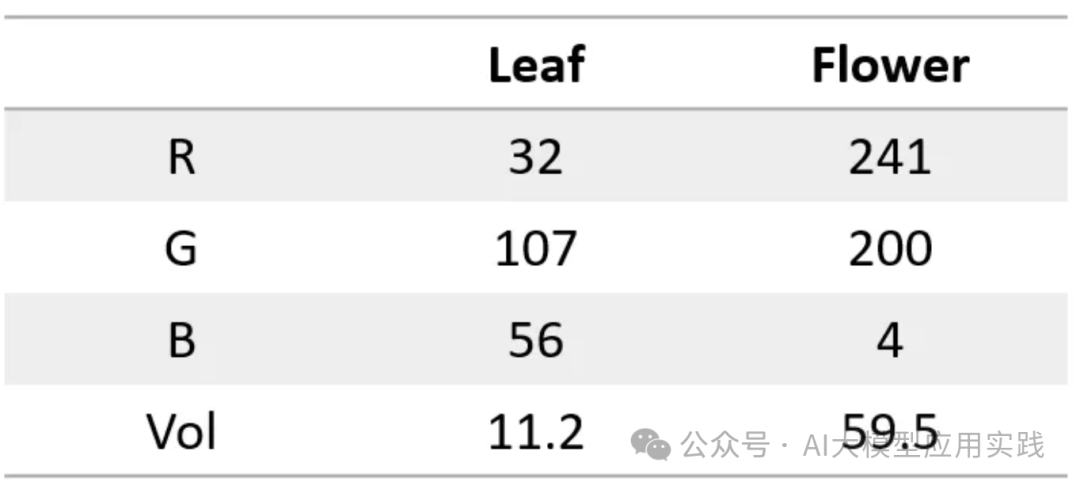

有趣的是,我们可以用同一个神经网络处理完全不同的任务。比如,输入云量、湿度等 4 个数字,输出“晴天”或“雨天”的概率。如果权重校准得当,那么这个神经网络就可以同时完成叶子/花朵分类和天气预测的任务!神经网络只会输出两个数字,至于如何解释这些数字,完全由我们决定。

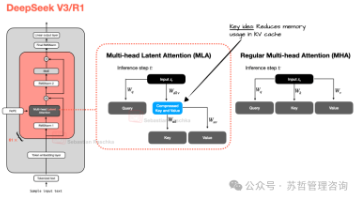

总的来说,DeepSeek-V3是一个庞大的6710亿参数模型,在推出时表现优于其他开放权重模型,包括4050亿的Llama 3。尽管规模更大,但由于其专家混合(MoE)架构,在推理时间上更加高效,每个标记仅激活了一个小子集(仅有370亿)的参数。另一个关键的区分特点是DeepSeek-V3使用多头潜在注意力(MLA)而不是分组查询注意力(GQA)。MLA和GQA都是标准多头注意力(MHA)的推理

PatientSeek 是首款开源的MED-LEGAL医学推理 AI 模型,专注于疾病诊断和法律医学关联分析,结合医疗和法律领域的深度推理能力,高效、安全、经济地支持复杂的专业需求,支持本地运行并优先保护数据隐私,性能优于其他开源模型且成本更低。WhyHow.AI。

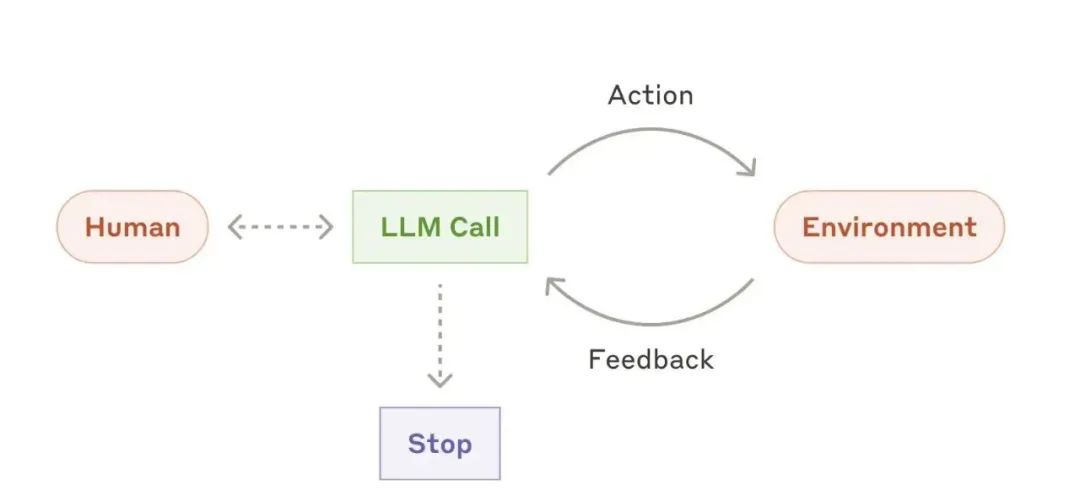

在LLM(大型语言模型)驱动的系统中,工作流和智能体是两个重要的概念,但它们有显著的不同。工作流是指在预定义代码路径中,LLM和工具按照固定顺序进行协调。这意味着任务的每个步骤都已经事先设定,LLM按照这些步骤执行任务。工作流适用于那些步骤已知且任务明确的场景。智能体则是指LLM在执行过程中,根据当前的情况和进展动态决定如何使用工具,并根据实际需求作出调整。这种方式适用于那些任务路径不可预知、复杂

给你学习,我国在这方面的相关人才比较紧缺,大模型行业确实也需要更多的有志之士加入进来,我也真心希望帮助大家学好这门技术,如果日后有什么学习上的问题,欢迎找我交流,有技术上面的问题,我是很愿意去帮助大家的!截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。在与AI的交互中,我们最需要保持的是,用比AI更提前的全景思维,经过“已知求