简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在2022中国数据与存储峰会上,来自英特尔的三位技术专家英特尔数据中心事业部 云解决方案架构师高伟、英特尔中国政企事务部及全球OEM解决方案经理吴国安、英特尔网络与边缘计算事业部云计算软件开发工程师裴迪分别从CSAL/WSR、持久内存存储和IPU SPDK存储卸载加速/优化的角度对数据存储的问题给出了解读。这些技术各有特色,依托各自强大的优势鼎立支持英特尔的技术发展。

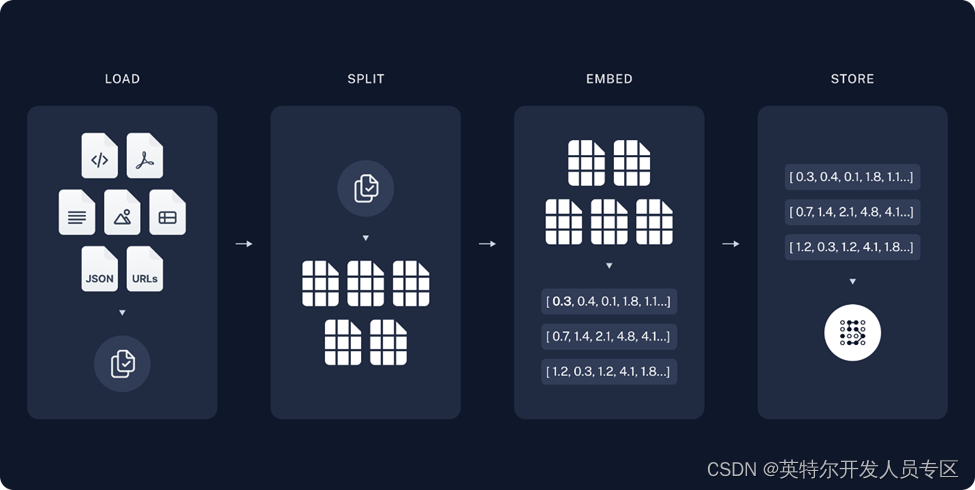

在医疗、工业等领域,行业知识库的构建已经成为了一个普遍需求,通过LLM与OpenVINO™的加持,我们可以让用户对于知识库的查询变得更加精准与高效,带来更加友好的交互体验。

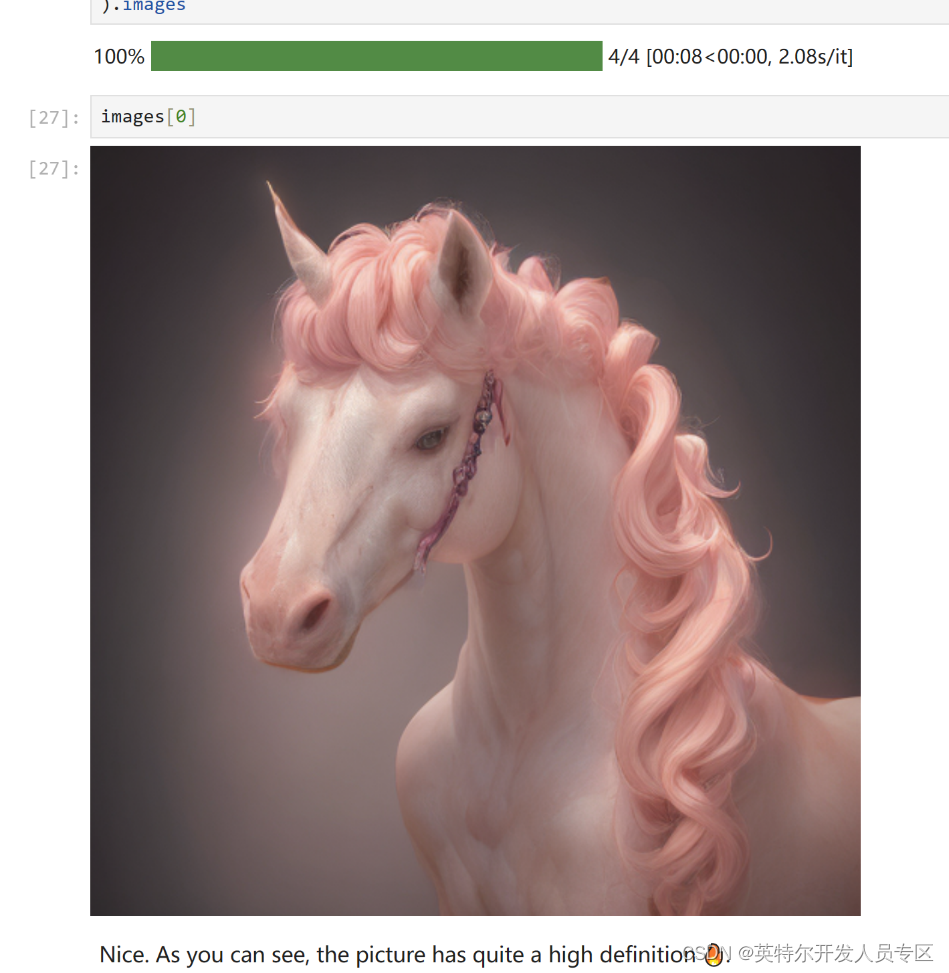

充满魔力的LCMs文生图模型,我们的OpenVINO™当然也可以对它进行完全的优化、压缩以及推理加速、快速部署的支持。接下来,就让我们通过我们常用的OpenVINO Notebooks仓库中关于LCMs模型的Jupyter Notebook代码和拆解,来进一步了解具体步骤吧

是人工智能研究工程师/科学家。在那次演讲中,Anomalib 是给人留下深刻印象的库之一,这个深度学习库用于评测、开发异常检测算法,这些算法可导出至 OpenVINO™ 中间表达(IR)格式,并方便快速地部署到英特尔硬件上。中,我们展示了Anomalib 是由工具、组件以及模块这几部分组成的,其中,我们把部署作为工具和模块的一部分,想表明这部分也包含在该库的范围内。借助内容广泛的 Anomalib

哪吒(Nezha)开发套件以信用卡大小(85 x 56mm)的开发板-哪吒(Nezha)为核心,哪吒采用Intel® N97处理器(Alder Lake-N),最大睿频3.6GHz,Intel® UHD Graphics内核GPU,可实现高分辨率显示;板载LPDDR5内存、eMMC存储及TPM 2.0,配备GPIO接口,支持Windows和Linux操作系统,这些功能和无风扇散热方式相结合,为各种

让我们一起看看本次版本如何继续推动我们的使命——让 AI 模型在 Intel 硬件上的部署变得更快、更高效、更易用

01概述本文是OpenVINO™ 工具套件与百度飞桨PaddlePaddle模型转换/部署系列的第二部。这篇文章专注于展示如何将百度飞桨PaddelSeg项目下的DeepLabV3+路面语义分割模型转换为OpenVINO™ 工具套件的IR模型并且部署到CPU上。为了使本文拥有更广的受众面,文章的目标部署平台选择了CPU和iGPU。关于如何部署到边缘设备例如Intel® Movidius Myrai

本文详细介绍了如何使用 OpenVINO™ 部署通义Z-Image-Turbo 模型,OpenVINO™为 Z-Image-Turbo 提供了显著的性能提升,作为轻量化模型的代表,Z-Image-Turbo特别适合在 Intel CPU/GPU 上进行推理部署。

Edge AI Box for Video Analytics Use CaseOverviewIntegrate video decode on multiple streams with video analytics. Configure your application end-to-end with flexible AI capacity and a Reference Video A

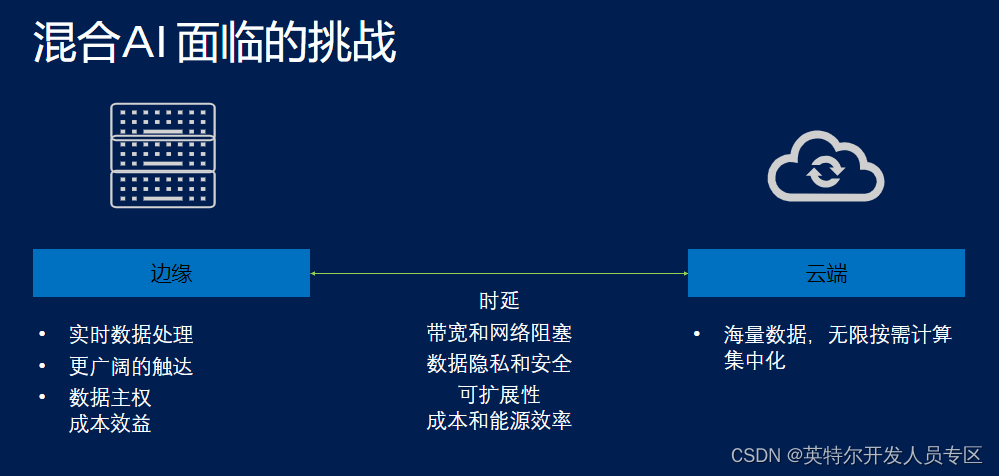

随着人工智能技术的飞速发展,AI的应用已经渗透到日常生活的各个方面。为了更有效地利用AI技术,混合式AI部署成为了一个重要趋势。这种部署方式结合了云端和边缘计算的优势,使得AI应用更为灵活和高效。本文将探讨OpenVINO™如何助力混合式AI部署,实现AI的无所不在。