简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

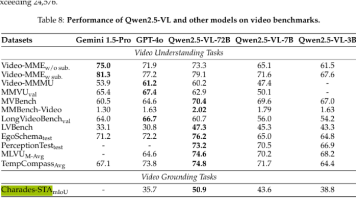

Qwen2.5-VL-72B在长视频理解和时间敏感任务上表现优异,在LVBench、MLVU基准和Charades-STA数据集(mIoU 50.9)上超越GPT-4o等竞品。TimeChat在时间戳定位任务(Charades-STA)的R@1指标达32.2分。实验设置方面,Qwen2.5-VL限制视频token不超过24,576,而LongVU为8,129。Qwen2.5-VL通过同步MRoPE

mysql 建立连接。

在本文中,我们介绍了Qwen-VL系列,这是一组大规模的视觉-语言模型(LVLMs),旨在感知和理解文本和图像。从Qwen-LM开始,我们通过精心设计的(i)视觉受体,(ii)输入-输出接口,(iii)3阶段训练管道,以及(iv)多语言多模态清洗语料库,赋予其视觉能力。除了传统的图像描述和问答,我们还通过图像-标题-框元组的对齐实现了Qwen-VLs的定位和文本阅读能力。

1.确认GPU型号和操作系统版本,本示例中以A100以及操作系统为Centos 7.9进行操作。准备GPU驱动和CUDA 11.2软件包,在nvidia官网进行驱动包和CUDA包下载链接:linux系统均选择 Linux 64-bitCUDA Toolkit选择最新版本如您需要老版本CUDA,请前往老版本CUDA下载本示例中使用CUDA 11.2。

paddlenlp智能问答系统安装落地流程

1.确认GPU型号和操作系统版本,本示例中以A100以及操作系统为Centos 7.9进行操作。准备GPU驱动和CUDA 11.2软件包,在nvidia官网进行驱动包和CUDA包下载链接:linux系统均选择 Linux 64-bitCUDA Toolkit选择最新版本如您需要老版本CUDA,请前往老版本CUDA下载本示例中使用CUDA 11.2。

角色身份+任务具体目标+任务背景+输出示例+原文内容。

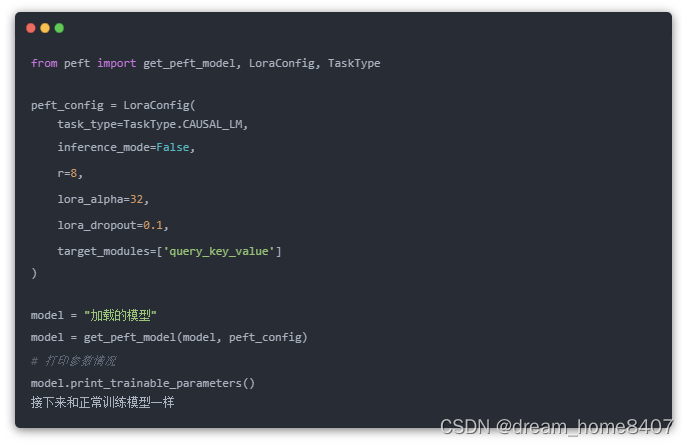

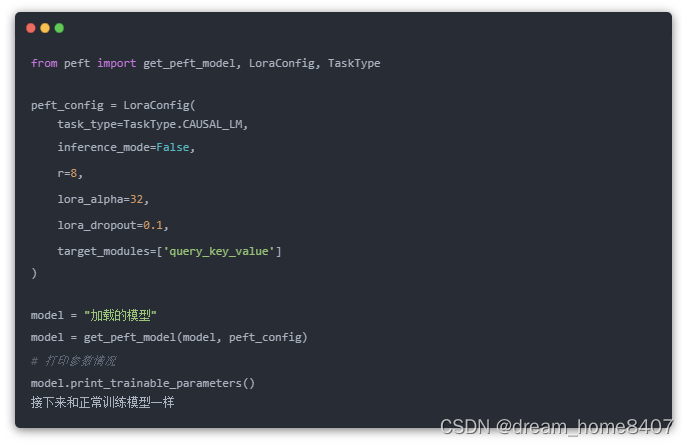

ChatGPT带领着大模型像雨后春笋一般层出不穷,大家都对大模型微调跃跃欲试,现在咱们聊聊其中的常见的算法。

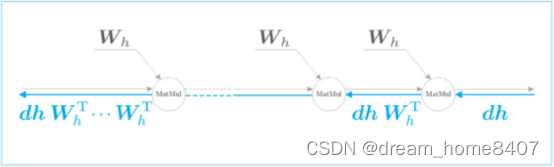

在学习正确解标签时,重要的是RNN层的存在,RNN层通过向过去传递有意义的梯度,能够学习时间方向上的依赖关系,此时梯度,包含哪些应该学习到有意义的信息,通过将这些信息向过去传递,RNN层学习长期的依赖关系,但是,如果这个梯度在中途变弱,则权重参数将不会被更新,也就是说,RNN层无法学习长期的依赖关系,

ChatGPT带领着大模型像雨后春笋一般层出不穷,大家都对大模型微调跃跃欲试,现在咱们聊聊其中的常见的算法。