简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

多模态模型在音乐流派和情感分类任务中表现优于单模态模型,例如在Music4All数据集上,多模态模型在情感分类任务中达到了48.53%的准确率,相比歌词模型(32.33%)和音频模型(48.29%)均有提升;实验表明,使用更大规模的语言解码器(如13B模型)可以显著提升多模态推理性能,与7B模型相比,准确率提升了近5%,这为未来使用更大模型进行科学多模态任务提供了有力支持。提出了FakeBench

这种对应关系可以是时间维度的(如视频中的画面与声音的时间同步),也可以是空间维度的(如图像中的区域与文本描述的对应)。通过计算图像令牌和文本令牌之间的相似度来选择相关的图像块,提高了模型对图像和文本之间相关性的理解,例如在Flickr-30k数据集上的图像-文本检索任务中,mTR/mIR性能提升了+5.1%/3.7%。在十二个NLG任务上的广泛实验表明,ZeroNLG在没有任何标记的下游数据对训练

DeepSeek的横空出世打乱了AI圈原本的安宁,我趁着这段时间总结了一套deepseek的论文王炸打法,亲测用这个方法改论文,起码省下三四天的时间,需要的朋友速码~确保每个论点都有充分的证据和解释支持如果某个部分或论点跳跃性较大,可能需要添加更多细节或背景信息来填补逻辑上的空白,确保论文的完整性和深度。如有必要,考虑重组论文。为论文及其各部分选择具有指导性和信息性的标题,这些标题应准确反映每部分

深度学习是人工智能领域的一个重要分支,它通过模拟人脑神经网络的工作原理,实现对复杂数据的高效处理。本文将为大家介绍深度学习领域的十大经典算法,帮助大家更好地理解和应用深度学习技术。1.卷积神经网络(CNN)卷积神经网络(Convolutional Neural Networks,简称CNN)是一种专门用于处理具有类似网格结构的数据(如图像)的神经网络。CNN通过卷积层、池化层和全连接层等组件,实现

边界注意力(Boundary Attention)是一种新型的注意力机制,主要用于从图像中检测和推断边界结构,包括边缘、角点、交叉点等。我还整理出了相关的论文+开源代码,以下是精选部分论文更多论文料可以关注:AI科技探寻,发送:111领取更多[论文+开源码】标题:Boundary-Aware Axial Attention Network for High-Quality Pavement Cra

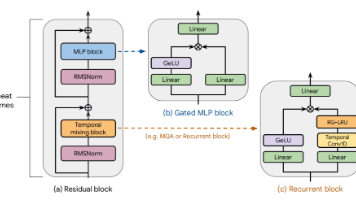

ALiBi在训练时使用的输入序列长度为1024,但在测试时能够处理长度为2048的序列,并且在困惑度上与训练长度为2048的正弦位置编码模型相当,同时训练速度提升11%,内存使用减少11%。在训练时,Griffin与Transformer的硬件效率相当,且在推理时具有更低的延迟和更高的吞吐量。在训练时使用的token数量比Llama-2少6倍的情况下,Griffin匹配了Llama-2的性能。通过

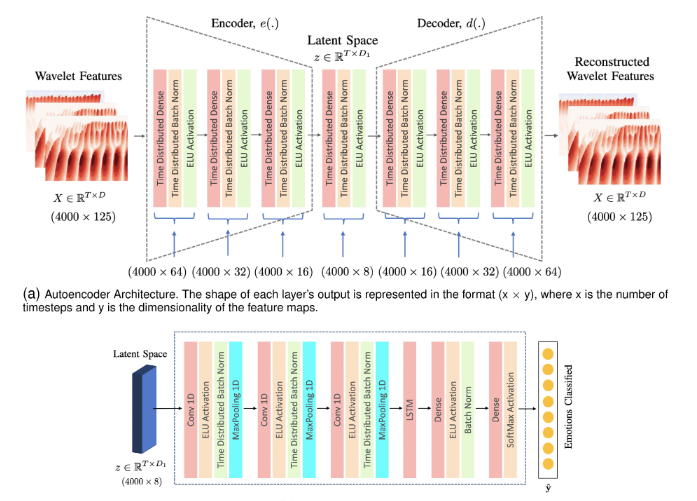

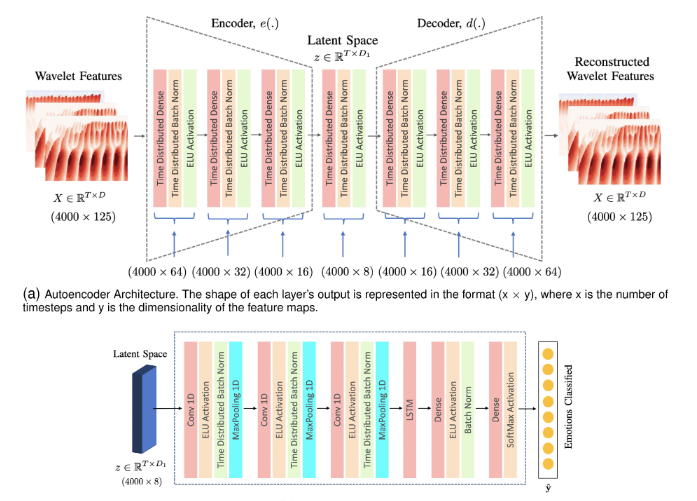

实验表明,即使在只有少量短时训练样本的情况下,提出的混合架构也能成功执行有效的特征提取,相对改进了约20%(Librispeech数据集上,相比于CNN-raw和SincNet)。:在16×16或更小像素尺寸的非常低分辨率人脸图像上实现了高达16倍的放大,且在定量和定性上都优于现有的超分辨率方法。:小波变换的应用揭示了在处理不平等类分布时,CNN模型的局限性,为未来的空气质量预测系统提供了改进的方

实验表明,即使在只有少量短时训练样本的情况下,提出的混合架构也能成功执行有效的特征提取,相对改进了约20%(Librispeech数据集上,相比于CNN-raw和SincNet)。:在16×16或更小像素尺寸的非常低分辨率人脸图像上实现了高达16倍的放大,且在定量和定性上都优于现有的超分辨率方法。:小波变换的应用揭示了在处理不平等类分布时,CNN模型的局限性,为未来的空气质量预测系统提供了改进的方

深度LSTM能够支持高达24层的深度Transformer的收敛,而12层使用深度LSTM的Transformer已经达到了24层普通Transformer的性能水平,表明深度LSTM在参数使用上比基线方法更高效。提出了一种将深度LSTM与Transformer层和子层连接的方法,将堆叠Transformer层的输出视为时间序列中的步骤,并管理层内和层间的表示聚合。训练一个带有注意力机制的双向长短

深度LSTM能够支持高达24层的深度Transformer的收敛,而12层使用深度LSTM的Transformer已经达到了24层普通Transformer的性能水平,表明深度LSTM在参数使用上比基线方法更高效。提出了一种将深度LSTM与Transformer层和子层连接的方法,将堆叠Transformer层的输出视为时间序列中的步骤,并管理层内和层间的表示聚合。训练一个带有注意力机制的双向长短