简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

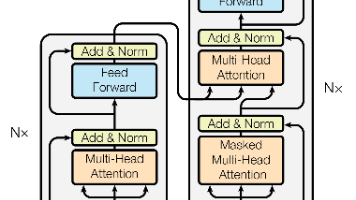

《Attention Is All You Need》论文摘要: Transformer是一种基于纯注意力机制的序列转换模型,摒弃了传统的循环和卷积结构。其核心创新包括:1)多头自注意力机制,通过并行计算实现全局依赖建模;2)位置编码,使用正弦函数注入序列顺序信息;3)位置前馈网络增强非线性表达能力。实验表明,Transformer在机器翻译任务中取得SOTA效果(英德28.4 BLEU,英法41

LSTM(长短期记忆网络)通过引入单元状态和门控机制解决了传统RNN的梯度消失问题。其核心结构包括遗忘门、输入门和输出门,分别控制长期记忆的保留、当前输入的存储和最终输出。前向传播中使用sigmoid和tanh激活函数计算门控状态和单元状态。反向传播时,误差项通过时间反向传播(BPTT)和权重梯度计算实现参数更新。数学推导表明,LSTM能够有效捕捉长距离依赖关系,适用于序列建模任务。该网络通过门控

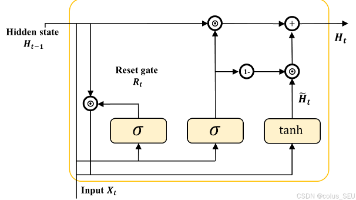

GRU(门控循环单元)是通过简化LSTM结构提出的循环神经网络变体,于2014年提出。其核心包含重置门和更新门两个门控机制,分别控制短期记忆和长期记忆的保留程度。GRU通过候选隐状态的计算和门控融合实现信息流动,相比LSTM减少了参数数量(6组参数vs.LSTM的8组)和计算复杂度,同时保持相近的长期依赖处理能力。结构上GRU仅维护一个隐藏状态,而LSTM需要额外维护细胞状态。实际应用中,GRU在

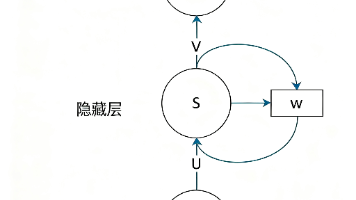

摘要:RNN(循环神经网络)是为处理序列数据而设计的,能够捕捉前后输入间的关联性(如自然语言处理中的词性标注)。其核心结构通过隐藏层状态传递历史信息,采用BPTT算法进行训练。RNN优点包括参数共享和处理变长序列,但存在梯度消失/爆炸问题。改进方法包括使用LSTM/GRU结构、调整激活函数等。RNN广泛应用于语音识别、机器翻译等时序任务中,成为处理序列问题的关键深度学习模型。(149字)

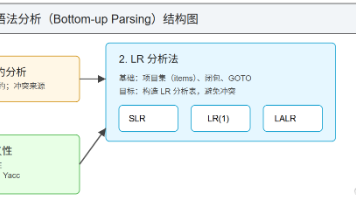

本文系统介绍了自底向上语法分析技术,重点阐述了移进-归约分析中的冲突问题及解决方法。首先通过id*id实例展示了SLR分析表构造过程,包括增广文法、状态转移图和FOLLOW集计算。随后详细讲解了更强大的LR(1)分析方法,包括项目集构造算法、闭包计算和规范分析表生成。最后探讨了LALR的合并核心状态思想,并通过优先级解决冲突的实例(如运算符优先级和悬垂else问题)说明了二义性文法的处理策略。全文

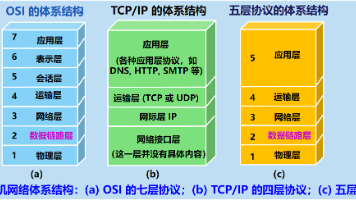

本文摘要:数据链路层是网络体系结构中的重要组成部分,主要功能包括帧封装、链路管理、差错控制和流量控制。它通过物理链路实现节点间的可靠数据传输,使用MAC地址进行寻址,并采用CSMA/CD等协议解决共享信道的冲突问题。文章详细介绍了数据链路层的服务、差错控制机制(如CRC校验)、介质访问控制方法(包括信道划分和随机访问协议),以及局域网技术(以太网、交换机、VLAN等)。特别阐述了ARP协议实现IP

本文介绍了前馈神经网络(MLP)的实现与优化方法,包含三个核心任务:1. 使用NumPy从零实现3层MLP解决XOR问题,验证了隐藏层对非线性问题的必要性;2. 基于PyTorch构建MLP在MNIST上达到98.2%准确率,采用Xavier初始化、SGD优化和Dropout正则化;3. 在更复杂的CIFAR-10数据集上系统比较优化器(SGD/Adam/Adagrad)、初始化方法(Kaimin