简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

LangGraph 基于 LangChain 之上,是一个基更高级的 AI Agent 编排框架,可以处理复杂的 Workflow 编排和 Multi-Agent 编排。

使用cursor等软件总是遇到调用次数限制的问题,用一阵就不能再使用了。于是,就希望能够通过Ollama来使用本地部署的代码大模型。然后就找到了twinny这个vscode的插件。

LLaMA Factory是一款开源低代码大模型微调框架,集成了业界最广泛使用的微调技术,支持通过Web UI界面零代码微调大模型,目前已经成为开源社区内最受欢迎的微调框架。

人工智能技术领域持续火热,智能助手已经成为企业和个人提高效率、获取信息的重要工具。构建一个私有化智能助手,不仅可以满足个性化需求,还可以确保数据安全和隐私保护!智能助手已经成为我们日常生活和工作中不可或缺的一部分。本文将详细介绍如何基于 Dify、大模型(LLM)和智能体(Agent)从零开始构建一个功能强大、易于扩展、私有化智能助手,帮助读者了解整个构建过程和涉及的关键技术。

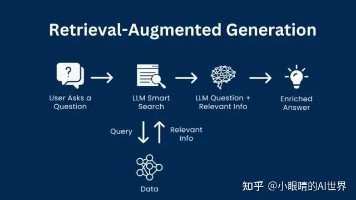

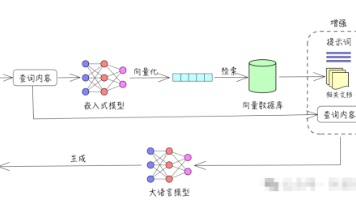

RAG(检索增强生成)技术,通过为AI巧妙地连接上一个内容可信、可持续更新的外部知识库,成功实现了“先检索、再生成”的智能化、高可信度回答模式。这使得AI的回答不仅在准确性上得到显著提升,其信息也更加新鲜、时效,并且每一份答案都做到了有理有据,从而有效地解决了大语言模型固有的“幻觉”问题和知识更新滞后的痛点。对于每一位希望从AI处获取可靠信息,或是期望AI能更深入理解并服务于特定领域知识应用场景的

RAG,本质上是一种结合搜索技术和大型语言模型(LLMs)的技术。它通过从数据源中检索信息来辅助LLM生成答案。

在此文章中汇总梳理了目前国内外的很多开源大模型,这些开源大模型基本都是免费的,可以在本地部署自己的开源模型,也可以部署再服务器中,通过域名随时可以访问,可以说如果学会了如何部署开源大模型,完全可以构建一个自己的ChatGPT!

这一差异揭示了当前AI技术的两大核心分支——大模型与AI Agent的本质区别:前者是“语言专家”,擅长理解与生成文本;后者是“行动执行者”,能基于目标完成决策与任务落地。二者并非替代关系,而是在协同中重塑AI的应用边界,成为企业数字化转型的关键工具。

简单记录下Dify系统的部署,以及可能遇到的各种问题,然后演示一下如何快速的搭建一个问答系统。

Ollama是一款专注于简化大型语言模型本地部署和运行的开源框架,基于Go语言实现,支持跨平台运行,并以“开箱即用”为核心理念,适合个人开发者和轻量化场景。