简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

产品经理转行大模型领域的优势与学习路径 摘要:产品经理转向大模型领域可结合产品思维与技术能力,获得多重优势:深入技术理解、创新产品设计、优化用户体验、数据驱动决策等。学习路径分为四个阶段:初阶应用(10天)掌握AI基础与提示工程;高阶应用(30天)构建RAG系统和对话机器人;模型训练(30天)学习微调与多模态训练;商业闭环(20天)掌握部署与商业化策略。该转型可提升个人竞争力,目前国内大模型岗位缺

摘要:本文探讨如何利用大模型技术提升数据开发全流程效率,覆盖需求理解、SQL开发、数据质量管理等关键环节。文章比较了推理型与非推理型大模型的应用场景,提出基于Prompt Engineering的解决方案,包括自然语言需求解析、智能数据探查和Text-to-SQL转换等实用方法。实践案例显示,某电商企业通过LLM需求助手将需求澄清时间缩短75%。研究强调资产平台与大模型的结合,为数据开发人员提供可

vLLM和SGLang大模型推理框架对比分析 本文对比了vLLM和SGLang两款高效推理框架的技术特点与适用场景。vLLM采用PagedAttention技术,通过分页机制优化显存管理,在高并发单轮场景下吞吐量提升10-25倍,特别适合实时客服、内容生成等低延迟需求场景。SGLang基于RadixAttention技术,通过基数树管理KV缓存,在多轮对话场景下缓存命中率提升3-5倍,更适用于复杂

vLLM和SGLang大模型推理框架对比分析 本文对比了vLLM和SGLang两款高效推理框架的技术特点与适用场景。vLLM采用PagedAttention技术,通过分页机制优化显存管理,在高并发单轮场景下吞吐量提升10-25倍,特别适合实时客服、内容生成等低延迟需求场景。SGLang基于RadixAttention技术,通过基数树管理KV缓存,在多轮对话场景下缓存命中率提升3-5倍,更适用于复杂

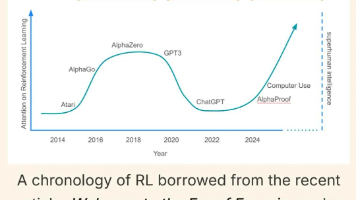

文章分析了Agent技术的两种发展路线,指出将能力内化到模型中的端到端训练方案能力上限更高,可实现完全自主演化。通过分析字节跳动ReTool、百川ReSearch/ReCall及Bespoke Labs等研究,揭示出当前技术趋势:使用简单奖励信号驱动强化学习,让模型自主决定工具调用策略。这种方法避免了人工干预,使模型能够发展出复杂的工具使用能力,是构建通用智能体的关键进化路线。

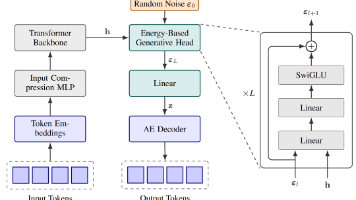

本文介绍了一种名为CALM的连续自回归语言模型新范式,通过将传统模型逐字生成转变为一次预测包含K个词的连续向量,实现了生成步数的指数级减少。文章提出高保真自动编码器实现词块与向量的无损转换,并创新性地解决了连续向量预测中的"无可能性"问题,包括能量损失训练方法、BrierLM评估指标和无可能性温度采样算法。实验证明,CALM在显著降低计算成本的同时,能够达到与传统Transformer相当甚至更好

本文总结了AIGC面试中常见的模型训练相关问题及解答。内容涵盖正则化方法(L1/L2)、过拟合解决方案、Dropout原理、激活函数比较、数据不平衡处理、学习率调整策略、Warmup使用场景、模型压缩技术、局部极小值问题、资源受限时的数据增强方法等核心知识点。特别强调面试回答时需避免机械背诵,应结合实际经验深入阐述。文章还提供了大模型学习资源,包括思维导图、书籍和实战教程,帮助读者系统掌握AI大模

摘要 本文介绍了基于vLLM和Kubernetes的大模型推理服务弹性部署方案。vLLM通过PagedAttention、Continuous Batching和Tensor Parallelism三项核心技术,显著提升GPU利用率至95%以上,降低延迟30-50%。文章详细对比了主流推理框架特性,推荐vLLM作为生产环境首选方案,并提供了完整的部署流程:包括GPU节点准备、NVIDIA Oper

摘要 本文介绍了基于vLLM和Kubernetes的大模型推理服务弹性部署方案。vLLM通过PagedAttention、Continuous Batching和Tensor Parallelism三项核心技术,显著提升GPU利用率至95%以上,降低延迟30-50%。文章详细对比了主流推理框架特性,推荐vLLM作为生产环境首选方案,并提供了完整的部署流程:包括GPU节点准备、NVIDIA Oper

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视