简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

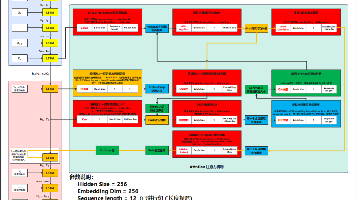

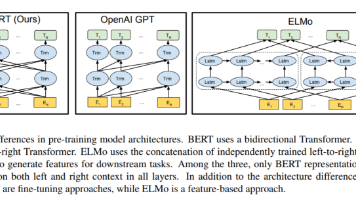

BERT模型是NLP领域的里程碑,由Google AI在2018年提出。它采用双向Transformer架构,通过MLM和NSP预训练任务实现上下文理解,在11项NLP任务中刷新SOTA。与单向GPT不同,BERT更适合语义理解任务(如分类、问答)。后续变体如轻量化的AlBERT、优化的RoBERTa和中文适配的MacBERT进一步提升了性能。BERT的"预训练+微调"模式极大

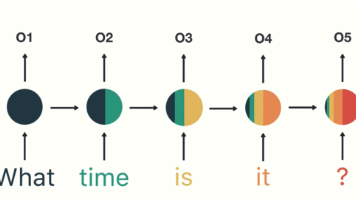

摘要: 本文系统解析了循环神经网络(RNN)及其改进模型LSTM的核心机制与应用。传统RNN通过循环记忆结构处理序列数据,但存在梯度消失问题。LSTM引入遗忘门、输入门、输出门和细胞状态四大机制,有效解决了长期依赖问题。文章详细对比了RNN与LSTM的数学表达、PyTorch实现及计算示例,并通过人名特征提取案例演示了RNN的时序计算过程。RNN适用于语音识别、文本分类等场景,而LSTM在长序列任

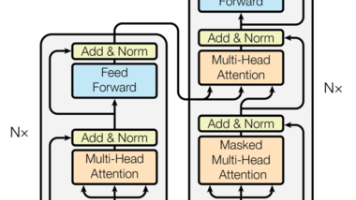

Transformer模型发展与应用 Transformer模型自2017年提出以来,经历了从基础架构到大规模预训练模型的演进过程: 技术突破 2017年提出自注意力机制,实现序列并行处理 2018年BERT和GPT分别展示了双向和单向预训练的优势 2020年后发展为GPT-3等大语言模型(LLM) 核心架构 基于编码器-解码器结构 关键组件: • 词嵌入与位置编码(解决序列位置问题) • 多头自

摘要:NLP模型评估指标是技术落地的关键,不同任务需适配不同指标。二分类任务基于混淆矩阵,衍生出准确率、精确率、召回率和F1-Score四大指标,各有适用场景:准确率适用于均衡数据,精确率关注预测准确性(如垃圾邮件过滤),召回率强调覆盖完整性(如疾病诊断),F1-Score平衡两者(如简历筛选)。文本生成任务则使用BLEU(机器翻译)、ROUGE(摘要生成)等专用指标。指标选择直接影响业务价值,需

AI 目标是让机器具人类智能,ML 是实现路径(从数据学规律),DL 是 ML 分支(用多层网络处理高维数据),三者呈 AI>ML>DL 层级。发展依赖数据(决定上限)、算法(提取规律)、算力(GPU/TPU 加速)。数据由样本、特征(预测依据)、标签(目标)构成,需划训练 / 测试集防过拟合。特征工程含提取、归一化 / 标准化预处理、降维及交叉 / 多项式组合。模型需平衡复杂度防过拟合 / 欠拟

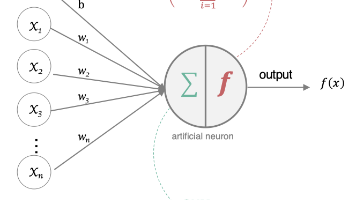

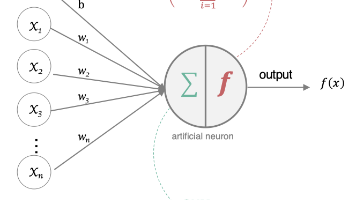

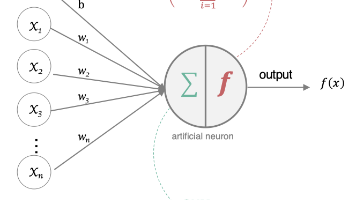

人工神经网络(ANN)是一种基于生物神经元结构的计算模型,通过多层非线性变换实现复杂模式学习。其核心由输入层、隐藏层和输出层组成,每层神经元通过加权求和和激活函数处理信息。前向传播过程将输入数据逐层转换为预测输出,反向传播则通过梯度下降优化网络参数。以包含1个隐藏层的网络为例,详细展示了从单个神经元计算到完整网络前向传播和反向传播的数学过程,包括权值更新和误差反向传递机制。这种结构使ANN能够有效

人工神经网络(ANN)是一种基于生物神经元结构的计算模型,通过多层非线性变换实现复杂模式学习。其核心由输入层、隐藏层和输出层组成,每层神经元通过加权求和和激活函数处理信息。前向传播过程将输入数据逐层转换为预测输出,反向传播则通过梯度下降优化网络参数。以包含1个隐藏层的网络为例,详细展示了从单个神经元计算到完整网络前向传播和反向传播的数学过程,包括权值更新和误差反向传递机制。这种结构使ANN能够有效

人工神经网络(ANN)是一种基于生物神经元结构的计算模型,通过多层非线性变换实现复杂模式学习。其核心由输入层、隐藏层和输出层组成,每层神经元通过加权求和和激活函数处理信息。前向传播过程将输入数据逐层转换为预测输出,反向传播则通过梯度下降优化网络参数。以包含1个隐藏层的网络为例,详细展示了从单个神经元计算到完整网络前向传播和反向传播的数学过程,包括权值更新和误差反向传递机制。这种结构使ANN能够有效

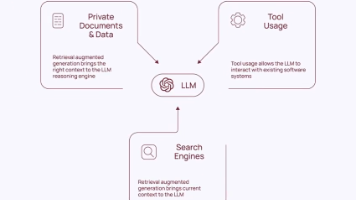

LangChain:大模型应用的工业级连接器 LangChain由Harrison Chase于2022年创建,现已成为GitHub明星项目(7万+星),被IBM、AWS等巨头采用。其核心价值在于: 统一模型接口:支持OpenAI、LLaMA等主流模型的无缝切换 精准提示控制:通过模板和示例引导模型输出 可复用任务链:串联多个组件形成自动化流程 智能决策代理:支持工具调用和自主规划 典型应用包括:

本文通过一个英法翻译案例,详细解析了基于RNN的Encoder-Decoder架构中注意力机制的实现原理。文章首先介绍了数据处理流程,包括文本规范化、词表构建和数据加载模块;然后阐述了模型架构设计,采用LSTM编码器与带注意力机制的解码器;最后展示了注意力机制如何动态聚焦输入序列的关键部分。通过PyTorch实现,案例直观演示了注意力权重在翻译过程中的动态变化,揭示了注意力机制提升长句子翻译质量的