简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1. 新增swanlab.Settings方法,支持更精细化的实验行为控制,进一步增强开放性2. 修复了sync_wandb的一些问题3. 修复了Obejct3D类的一些问题## 🔌插件1. 官方插件增加Slack通知、Discord通知,进一步打通海外生态## 💻硬件模块1. 支持了寒武纪MLU的硬件记录和资源监控,国产卡支持+12. 昇腾NPU的硬件记录,支持记录CANN版本3. 英伟达G

SwanLab在跟踪实验的过程中,会机器的硬件资源情况,并记录到当中。目前SwanLab已支持监控3款)的硬件资源情况,涵盖显卡利用率、显存占用率、显卡温度、显卡功率等指标。除此之外,SwanLab还支持监控等硬件资源情况。很开心,我们与昇腾计算团队合作,为训练师提供更多的国产算力使用体验。

摘要:MLX LM是Apple开发的开源Python工具包,专为Apple Silicon芯片优化,支持本地高效运行和微调大型语言模型。它基于MLX框架,利用统一内存架构和Metal性能着色器提升性能。用户可通过简单配置进行Lora微调,如示例中的Qwen3-0.6B模型训练,并集成SwanLab实现训练可视化。安装只需pip install mlx-lm swanlab,运行命令mlx_lm.l

smolagents是HuggingFace官方推出的Agent开发库,HF出品的库,往往的设计理念是“低门槛,高天花板,可拓展”,所以知道HF出了Agent相关的框架后,也是很快体验了一下。首先来介绍一下smolagents吧,smol是small的俏皮用法,故smolagents的含义是“轻量的agent工具”。smolagents库提供:✨:Agent逻辑仅需约千行代码即可实现。在原生代码之

SwanLab环境变量列表,包含SWANLAB_SAVE_DIR、SWANLAB_LOG_DIR、SWANLAB_MODE等常用的环境变量

EasyR1是基于veRL的一个高效、可扩展、多模态强化学习LLM训练框架,由LLaMA Factory作者hiyouga打造,很很短的时间内获得了1.8k Star。EasyR1 受益于 veRL 的 HybridEngine 和 vLLM 0.7 的 SPMD mode,并适配了 Qwen2.5-VL 模型,在多模态几何题任务 Geometry3k 上通过 30 个 batch 的 GRPO

DiffSynth Studio是推出的一个开源的扩散模型引擎,专注于图像与视频的风格迁移与生成任务。它通过优化架构设计(如文本编码器、UNet、VAE 等组件),在保持与开源社区模型兼容性的同时,显著提升计算性能,为用户提供高效、灵活的创作工具。DiffSynth Studio 支持多种扩散模型,包括 Wan-Video、StepVideo、HunyuanVideo、CogVideoX、FLUX

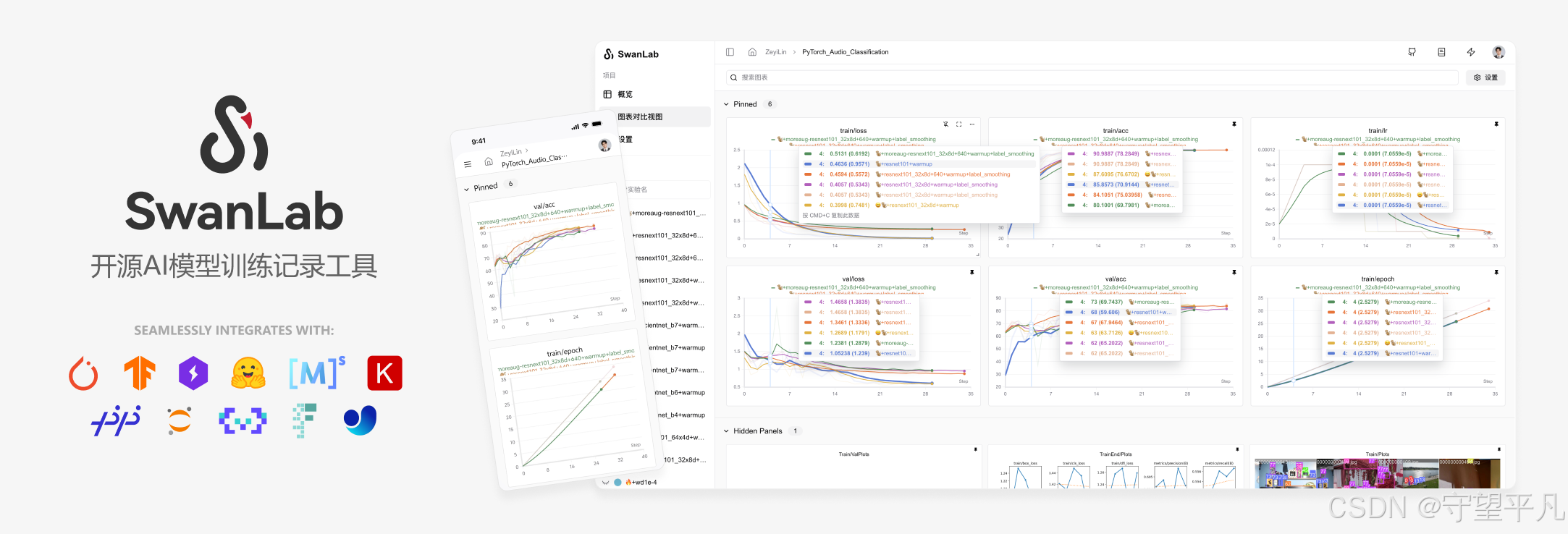

SwanLab是一个开源、现代化设计的深度学习训练跟踪与可视化工具,常被称为"中国版 Weights & Biases + Tensorboard"。SwanLab同时支持云端和离线使用,并适配了从再到等30多种主流AI训练框架,Python API设计也简洁易上手,能轻松嵌入你的训练代码。面向人工智能研究者,SwanLab设计了友好的Python API 和漂亮的UI界面,并提供训练可视化、自动

Ms-swift的是一个集模型训练、微调、推理、部署于一体的框架。🍲是 ModelScope 社区提供的官方框架,用于微调和部署大型语言模型和多模态大型模型。它目前支持大型模型和多模态大型模型的训练(预训练、微调、人工对齐)、推理、评估、量化和部署。🍔 此外,ms-swift 还采用了,包括,以及等人工对齐训练方法。ms-swift 支持使用 vLLM 和 LMDeploy 加速推理、评估和部

MiniCPM-O-2.6 多模态大模型微调实战。本文我们将简要介绍基于 transformers、peft 等框架,使用 MiniCPM-O-2.6模型在上进行Lora微调训练,同时使用监控训练过程与评估模型效果。