简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最大熵原理是概率模型学习的一个准则,最大熵原理认为,学习概率模型时,在所有可能的概率模型(分布)中,熵最大的模型就是最好的模型,通常使用模型的约束条件来确定概率模型的集合,所以最大熵原理也可以表述为在满足约束条件的模型集合中选择上最大的模型。 这里,n个约束条件; 真实分布和经验分布为: 未知的只有条件分布 p(y|x),得到了待选模型集合最大熵模型就是由公式(6.22)、公式(6.23)表示的条

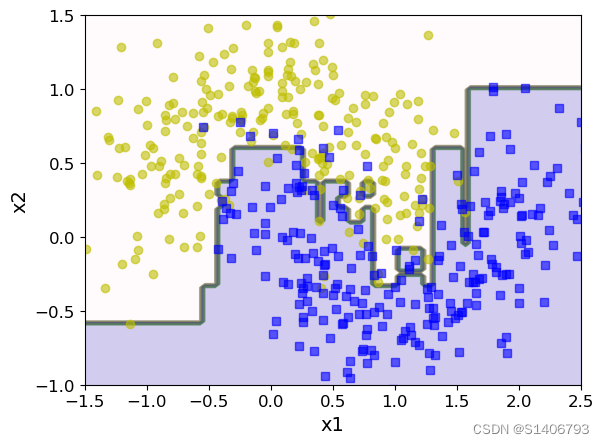

Gradient Boosting 是一种梯度下降模型,每一轮迭代都会训练一个新的基模型,然后将其加入到模型中,但是每个基模型的权重并不是固定的,而是根据残差的梯度来确定的。在每一轮迭代中,Gradient Boosting 会调整样本的权重,并使用残差来训练新的基模型,这样可以使得模型越来越关注于难以拟合的样本。在GBDT中,每一棵决策树都是在前一棵树的残差基础上进行训练。在每一轮迭代中,Ada

物流行业数据项目

最大熵原理是概率模型学习的一个准则,最大熵原理认为,学习概率模型时,在所有可能的概率模型(分布)中,熵最大的模型就是最好的模型,通常使用模型的约束条件来确定概率模型的集合,所以最大熵原理也可以表述为在满足约束条件的模型集合中选择上最大的模型。 这里,n个约束条件; 真实分布和经验分布为: 未知的只有条件分布 p(y|x),得到了待选模型集合最大熵模型就是由公式(6.22)、公式(6.23)表示的条

1、概述编辑2、决策树模型3、决策树学习4、决策树的构建——三步骤4.1 特征选择4.1.1 熵(Entropy)4.1.2 条件熵(Conditional Entropy)H(Y|X)4.1.3 信息增益(Information Gain)4.1.4 信息增益比4.2决策树算法4.2.1 ID3算法4.2.2 C4.5算法4.2.3 Python实现ID3、C4.5算法4.3 决策树的剪枝引言

物流行业数据项目

(1)数据仓库是一个面向主题的、集成的、非易失的且随时间变化的数据集合。(2)主要用于组织积累的历史数据,并使用分析方法(OLAP、数据分析)进行分析整理,进而辅助決策,为管理者、企业系统提供数据支持,构建商业智能。

级联操作对原始数据(表格)进行横向或者纵向的拼接,和np.concatenate函数类似。需要保证拼接的行列索引的一致;如果不一致,会补空(外级联)或者 只级联能够级联的部分(内级联)import numpy as npimport pandas as pdfrom pandas import DataFramepd.concat((df1,df2),axis=0) #按列进行级联匹配级联和不匹配

(1)数据仓库是一个面向主题的、集成的、非易失的且随时间变化的数据集合。(2)主要用于组织积累的历史数据,并使用分析方法(OLAP、数据分析)进行分析整理,进而辅助決策,为管理者、企业系统提供数据支持,构建商业智能。