简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Ollama是一款简化大语言模型部署的开源工具,支持Llama2、Mistral等主流模型,通过命令行操作即可实现本地或远程服务器的一站式部署。文章详细介绍了远程部署Llama3的步骤,包括环境搭建、Ollama安装和模型验证。同时指出Ollama采用量化技术降低硬件要求,但精度有所损失,更适合个人开发者使用。相比而言,企业级应用更推荐vllm,因其具备高性能、扩展性和专业支持。不同用户需根据实际

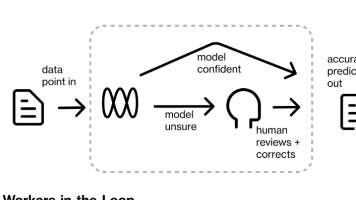

Claude 与 n8n 的结合,特别是通过 MCP 的加持,为 AI 自动化带来了前所未有的可能性。它不仅大大降低了构建复杂自动化工作流的门槛,还通过“人在循环内”的模式,确保了 AI 驱动的自动化更加可靠和可控。这种强大的协作模式,使得个人开发者和小型团队也能在短时间内构建出功能强大、具有商业价值的 AI 应用。它预示着 AI 和开发者工具将更加紧密地融合,人类的想法将以前所未有的速度转化为可

本文介绍了基于Dify和MCP开发AI理财助手的完整方案。文章从技术选型、环境部署入手,详细讲解了智能体架构设计、插件开发、金融数据抓取和微信公众号接入等关键环节。系统采用Dify作为LLMOps平台,结合MCP协议实现模块化工具调用,支持实时行情查询、资产组合分析和个性化投资建议等功能。开发部分包含Python代码示例,涵盖数据获取、MCP动作定义及微信公众号对接等核心模块。文章还探讨了运维安全

在数字化转型的大潮中,企业积累了大量的数据,这些数据包含了丰富的业务信息和潜在的价值。传统的指标管理平台虽然已经能够帮助企业有效地收集、计算、管理和展示关键指标,但在业务分析层面,面对日益复杂的数据环境和业务需求,单纯依靠人工分析已经难以满足高效、精准的管理要求。数据采集与预处理:从各业务系统中采集数据,并进行清洗、转换和标准化处理,基于业务主题生成并落地对应的指标体系,这部分可以由传统数仓和标准

提示词(Prompt)是输入给大模型(LLM)的文本指令,用于明确地告诉大模型你想要解决的问题或完成的任务,也是大语言模型理解用户需求并生成准确答案的基础。因此 prompt 使用的好坏,直接决定了大模型生成结果的质量(是否符合预期)。提示词(Prompt)是输入给大模型(LLM)的文本指令,用于明确地告诉大模型你想要解决的问题或完成的任务,也是大语言模型理解用户需求并生成准确答案的基础。因此 p

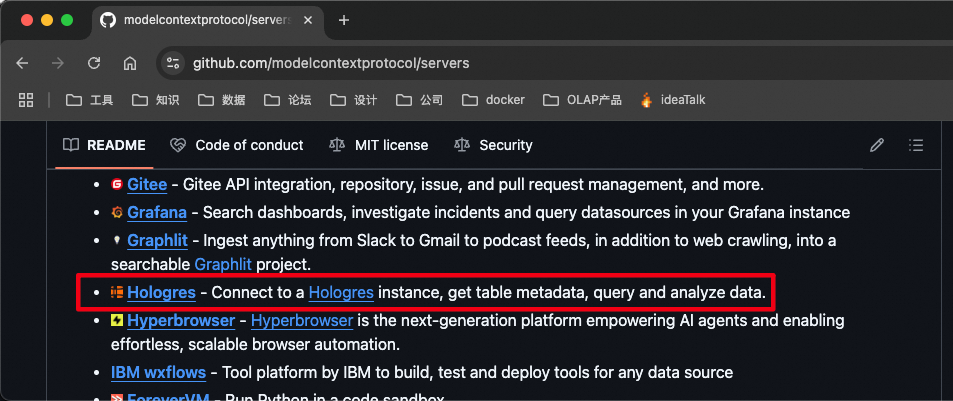

模型上下文协议(Model Context Protocol,MCP)是 Anthropic 于 2024 年推出的开源标准,旨在解决大模型与外部工具、数据源的集成难题。其核心作用是通过标准化接口架构,将 AI 模型的决策逻辑与外部资源解耦,形成 "智能大脑 + 外接四肢" 的协同模式。

因为大模型的知识库存在于训练期间,因此对于一些最新发生的事或者是专业性问题可能会出现不准确或者是幻觉,因此可以使用RAG技术给大模型外挂知识库来达到精准回答的目的。如果只是想简单尝试下大模型+知识库,那么gpt4all和ima都可以,毕竟都是图形化点点点就行,如果想要去自定义一些模型或者本身依赖ollama运行模型的话,可以选择open-webui,其可以有更多的自定义能力,如果想要在工程化中使用

本文系统介绍了大语言模型微调技术,包括全参数微调和参数高效微调(PEFT)两类方法。重点阐述了LoRA、适配器等技术原理,并提供了中文GPT-2模型微调为对话系统的完整实践案例,涵盖数据准备、训练配置到模型评估的全流程。针对显存限制问题,提出了混合精度训练、梯度累积等优化策略,并比较了不同微调方法的适用场景。最后总结了过拟合、灾难性遗忘等常见问题的解决方案,为开发者定制大模型提供了实用指导。

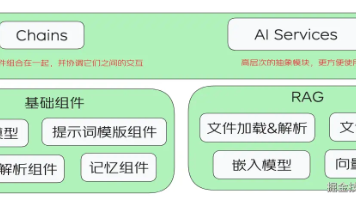

本文主要对LangChain4j框架是什么,LangChain4j有什么并且能干什么进行了说明,并接入Ollama qwen:7b大模型实现简单的对话功能,后续文章继续对LangChain4j框架进行讲解!

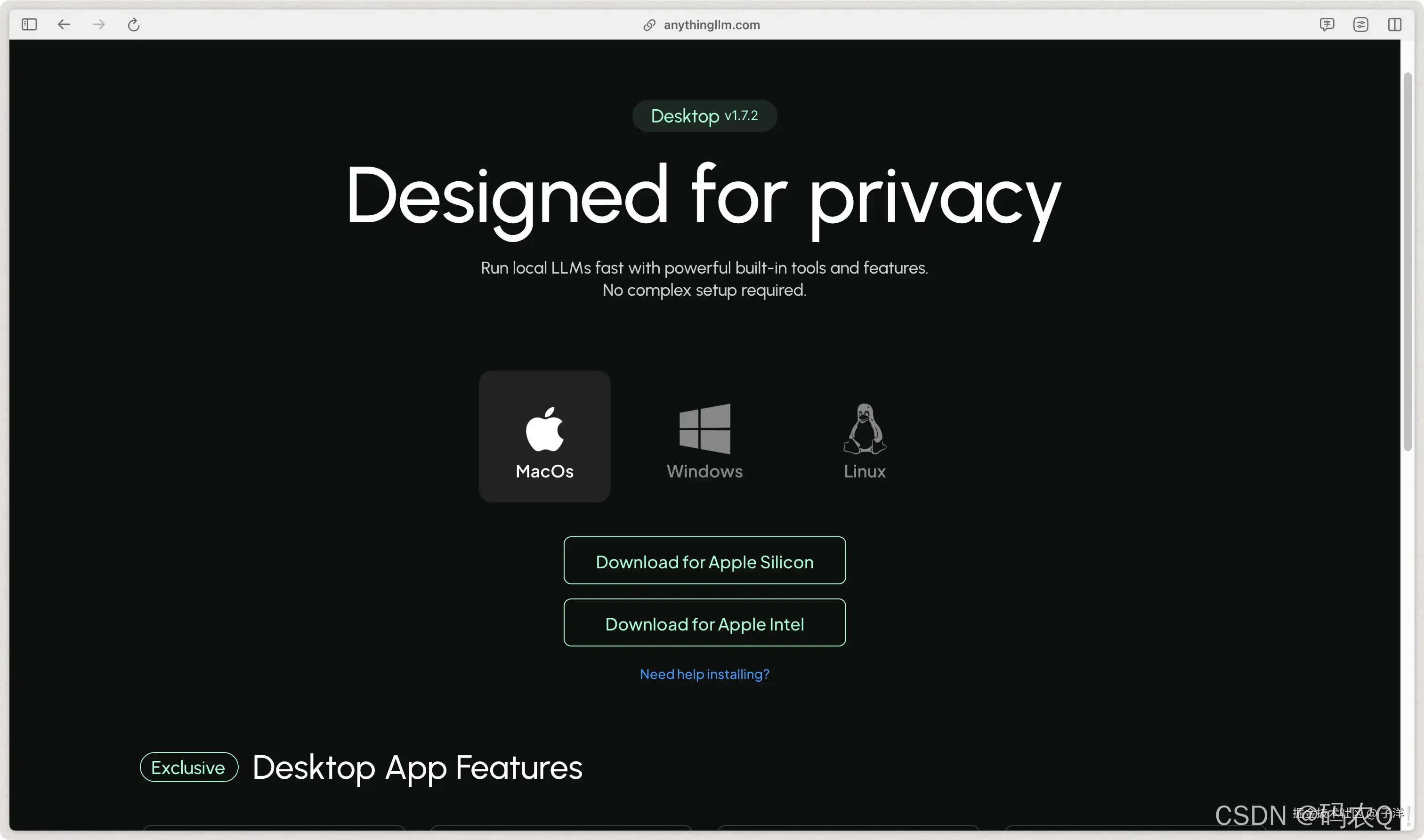

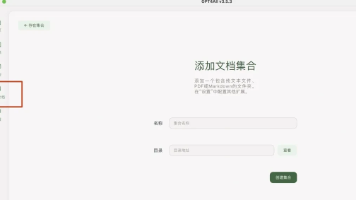

是一款开箱即用的一体化 AI 应用,支持 RAG(检索增强生成)、AI 代理等功能。它无需编写代码或处理复杂的基础设施问题,适合快速搭建私有知识库和智能问答系统。通过和Ollama的结合,我们成功搭建了一个具备私有知识库能力的 AI 应用。私有知识库不仅可以让 AI 回答通用问题,还能基于私有文档(如企业内部资料、图书等)生成更精准的答案。注意: 随着知识库中文档数量的增加,回答的准确性可能会受到