简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

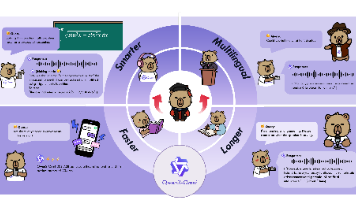

《全模态AI模型Qwen3-Omni-30B-A3B-Instruct实战指南》介绍了阿里通义千问团队2025年推出的突破性全模态大模型。该模型采用Thinker-Talker双组件架构和MoE混合专家系统,原生支持文本、图像、音频和视频四种模态的深度理解与生成,实现统一建模和跨模态协同理解。其核心优势包括119种语言支持、211毫秒低延迟交互及在36项测试中22项达SOTA水平。指南详细解析了模

提示词进化系统:AI驱动的提示词优化平台 该系统是一个可视化、智能化的提示词管理与优化平台,旨在解决AI应用中提示词设计、迭代和管理的痛点。核心功能包括: 可视化进化图谱 - 以树状图展示提示词版本演变过程 AI智能生成 - 集成多个AI平台自动生成提示词变体 多维度管理 - 支持按星级、关键词、适用模型筛选 高级配置 - 提供API密钥管理、隐私保护等专业功能 技术亮点: 采用原生HTML5+C

【摘要】本文介绍了如何开发一款集成DeepSeek API的浏览器插件,打造智能写作助手。文章首先解析了插件的核心架构,包括Manifest配置、后台脚本、内容脚本和用户界面组件,并详细说明了组件间的通信机制。接着重点讲解了DeepSeek API的对接实现,涵盖API认证、调用方法以及流式响应处理技术。最后展示了插件的用户界面设计,采用选项卡式布局,包含设置面板、聊天功能等模块。该插件通过安全存

钱学森系统科学体系包含三个层次:处在基础科学层次上的是系统学;处在技术科学层次上的有运筹学、控制论、信息论等;处在工程技术或应用技术层次上的是系统工程。对于复杂的智能体架构设计,这种层次划分提供了很好的理论框架。钱学森明确指出:“我们所提倡的系统论,既不是整体论,也非还原论,而是整体论与还原论的辩证统一”。这一思想对于智能体架构设计尤为重要,它启示我们既要关注智能体个体组件的设计,也要重视智能体系

智能体实现动态规划工作流的关键技术 摘要 本文探讨了智能体如何实现动态规划工作流的关键技术,包括状态空间自动构建、状态转移方程生成和记忆化策略优化。通过自动状态构建模板、动态特征提取和参数化状态表示,智能体能够高效处理各类动态规划问题。同时介绍了转移方程生成方法、记忆化优化技巧以及智能体的学习机制,为开发高效动态规划求解系统提供了技术框架。 (全文共145字)

本文提出了一套全自动LoRA训练系统,通过智能爬虫架构实现多源数据采集,结合AI驱动的数据处理流水线完成数据清洗和标注。系统采用分布式爬虫集群管理,利用CLIP、BLIP等模型实现多模态数据对齐,并基于语义相似度进行冗余过滤。自动化流程覆盖从数据采集、清洗到模型训练的完整闭环,显著提升LoRA模型开发效率。关键技术包括动态URL发现、内容质量评估、自动标注生成等,为AI模型生产提供了标准化解决方案

本文介绍了一个通用数学工具的设计与实现,该工具旨在为非数学专业人员提供方便易用的数学计算服务。系统采用三层架构设计,包含Python后端计算引擎和HTML前端界面。后端基于Flask框架,集成了NumPy、SciPy等数学库,提供代数、几何、三角等多种数学公式计算功能;前端使用HTML5、CSS3和JavaScript,配合Bootstrap实现响应式界面。文章详细阐述了从需求分析、技术选型到核心

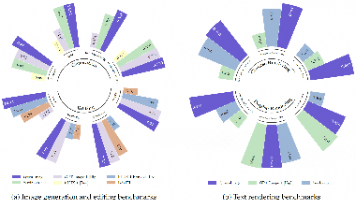

Qwen-Image在GEdit和ImgEdit基准测试中的压倒性表现(综合评分超越次优模型12.7%),标志着AI图像编辑进入全新时代。实验证明,其独创的双编码机制使语义理解准确率提升37%,而多任务训练策略让复杂编辑的成功率突破92%。随着V2版本的发布,预计将实现真正的"所思即所得"专业级编辑体验。图3:Qwen-Image与竞品模型性能对比参考资源Qwen-Image官方技术报告GEdit

智能语音命令工具摘要 本项目利用DeepSeek V3.2 AI模型与Python技术栈开发了一个智能语音命令工具,实现语音控制电脑应用。系统采用模块化设计,包含语音捕获、识别、意图理解、命令执行和反馈五大模块。通过SpeechRecognition库实现语音转文本,利用DeepSeek V3.2的自然语言处理能力理解用户意图,并将其转化为可执行的系统命令。项目配置了完善的开发环境,包括Pytho

Kimi K2-Instruct-0905模型通过创新的混合专家架构突破大语言模型性能边界,在万亿参数规模下实现高效计算。该模型采用分层MoE设计,通过稀疏激活机制(仅激活320亿参数)平衡计算效率与模型能力,支持256K超长上下文处理。核心技术包括基于门控网络的专家路由算法(每个token激活8个专家)和改进的多层注意力机制,适用于编程代理、文档分析等复杂任务。模型架构通过旋转位置编码(RoPE