简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

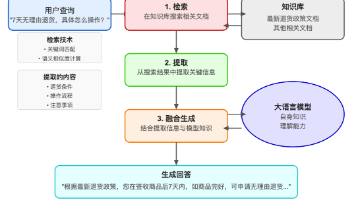

随着AI技术的火热发展,企业和个人用户需要搭建知识库的需求越来越迫切。如果自己动手搭建一个功能强大的知识库对于非专业技术人员来说可能面临挑战,更别说那些非专业人士了。我在网上看了大量相关的教程,大多数都是搬砖,偶尔看到一些非搬砖大佬写的教程,总会省略一些细节,导致很多人就算面对教程也是各种踩坑,折腾很久最后也都放弃了。

这种灵活性,再加上 Google Cloud 的可扩展基础设施,使 Vertex AI Agent Builder 成为那些希望在各种规模上部署 AI 解决方案的企业的强有力竞争者,从小型部门项目到潜在的大型企业范围的倡议。crewAI 的突出特点仍然是其基于角色的代理设计,能够创建高度专业化的 AI 团队,能够处理需要多样专业知识和观点的复杂工作流程。从AutoGen的复杂多代理系统到Cogni

以智能音箱为例,亚马逊Echo、谷歌Home等明星产品,凭借先进的语音识别与自然语言处理技术,成为了家庭中的智能小助手,只需简单的语音指令,便能轻松掌控家中的灯光、空调、电视等设备。自主智能体(Autonomous Agents),作为其中的佼佼者,它们如同拥有独立思维的探险家,在无需人类直接干预的情况下,凭借预设的规则与目标,勇敢地踏上自主完成任务的征途。在智能交通的宏伟蓝图中,智能体通过精准的

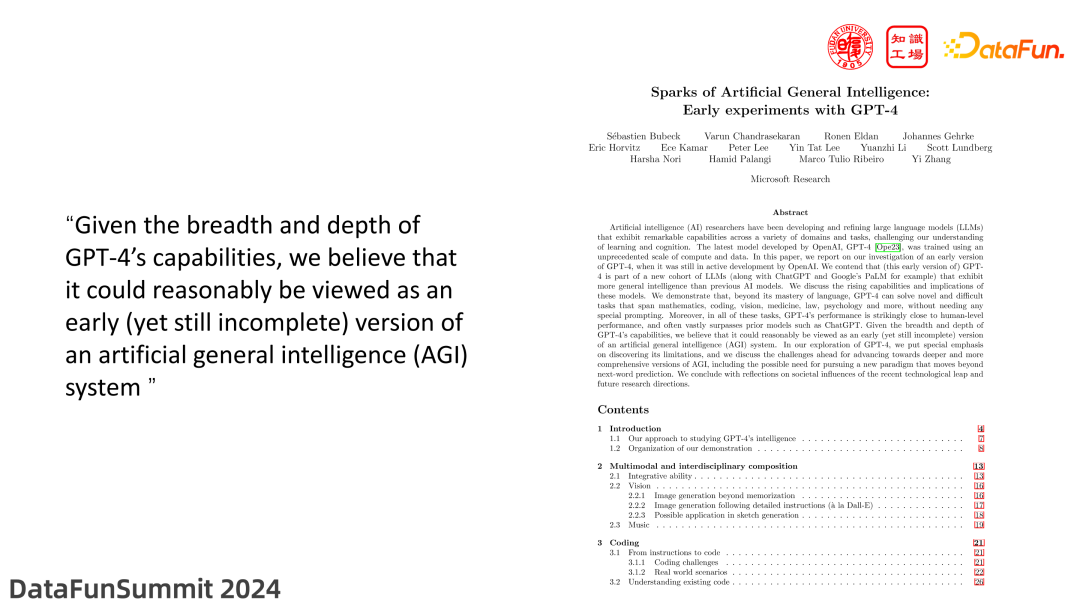

我们设计了一个大模型“内在的自我纠正”机制,设计构造自我纠正数据集,通过指令微调,并提出了部分答案掩码(PAM)训练方法,激发大模型在问答时进行自我迭代修正。构建和使用大模型都需要大量资源,且在实际应用中大模型的推理速度相对较慢,即使是经过优化的版本,处理文本分析仍需数秒。因此,大模型与现有业务人员或系统的对接能力,即其协同能力和可控性,显得尤为重要。在训练大模型时,无论是预训练还是微调,我们为语

分享一下我的整体思路。我觉得方法都是次要的,因为每个人的需求、情况都不同——唯有思路可以借鉴。出发点和对应解法:

蒸馏”技术实际上是指知识蒸馏(Knowledge Distillation),这是一种用于压缩和优化大模型的机器学习方法。其核心思想类似于传统蒸馏:大模型(教师模型)包含丰富的知识,而小模型(学生模型)通过学习大模型的输出,从而在保持高性能的同时降低计算成本。前排提示,文末有大模型AGI-CSDN独家资料包哦!1.知识蒸馏的过程教师模型(Teacher Model)训练先训练一个大规模基础模型,这

本地部署大语言模型可以通过多种工具和软件实现,每个工具都有其独特的优势和适用场景。通过上述步骤,您可以在本地环境中高效地运行和管理大语言模型,满足不同的应用需求。

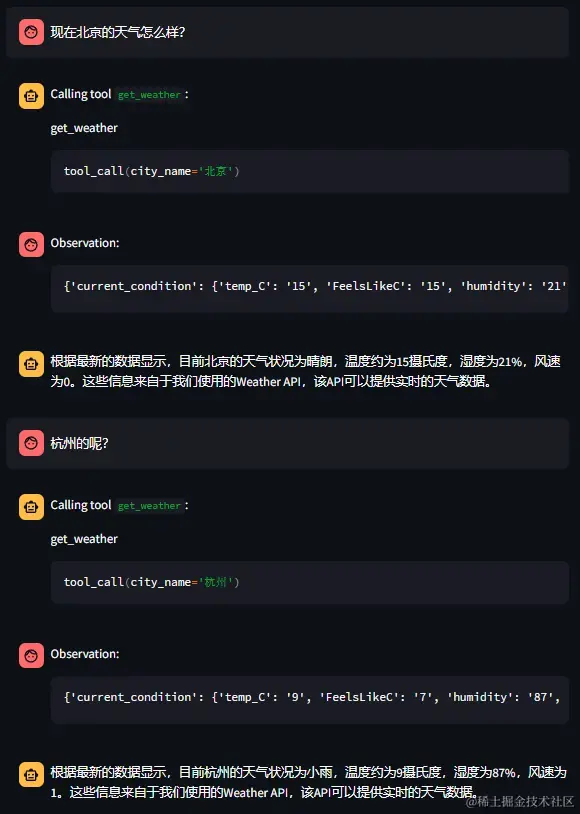

AI Agent,即人工智能代理,是一种能够感知环境、进行自主理解、决策和执行动作的智能体。它不仅可以处理自然语言,还具备决策制定、问题解决、与外部环境的互动和操作执行等广泛能力。AI Agent的工作流程通常包括感知、规划(或思考)、决策和行动四个关键环节,通过不断学习和优化,实现自主完成任务的目标。Manus作为一款全球首款通用AI Agent产品,以其独特的技术优势和市场表现,有望成为AI

CSDN独家福利最近,人工智能大模型火得一塌糊涂,各种新名词也层出不穷:RAG、Agent、微调、提示词工程……是不是听着就头大?别担心,今天咱们就用大白话,把这些概念一次性讲清楚,让你彻底搞懂它们是什么、有什么用,以及它们之间的区别和联系。

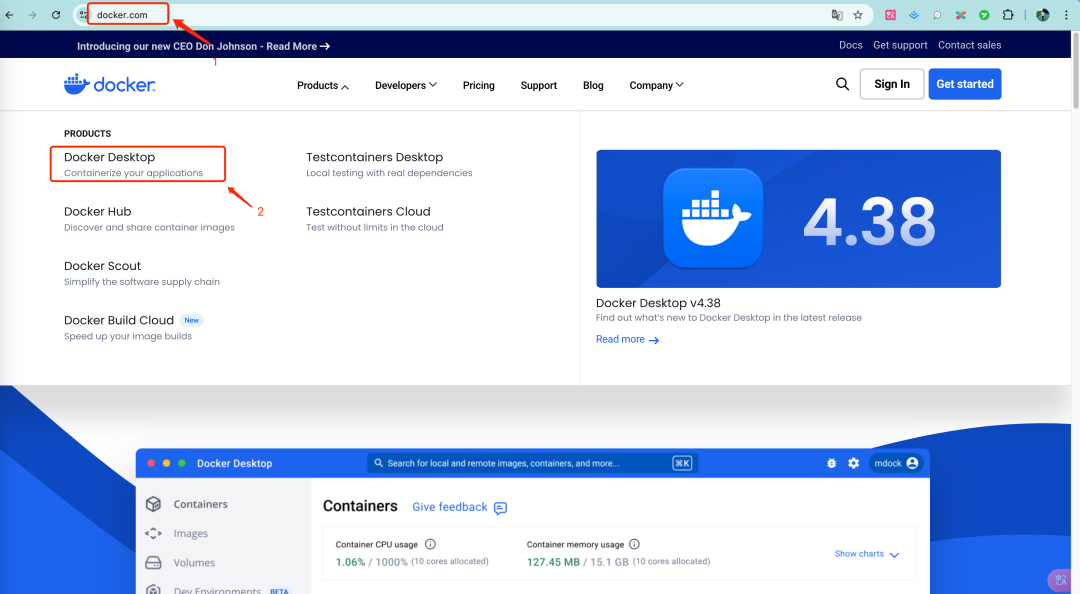

部署一个自己的大模型,没事的时候玩两下,这可能是很多技术同学想做但又迟迟没下手的事情,没下手的原因很可能是成本太高,近万元的RTX3090显卡,想想都肉疼,又或者官方的部署说明过于简单,安装的时候总是遇到各种奇奇怪怪的问题,难以解决。本文就来分享下我的安装部署经验,包括本地和租用云服务器的方式,以及如何通过API调用大模型开发自己的AI应用,希望能解决一些下不去手的问题。