简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

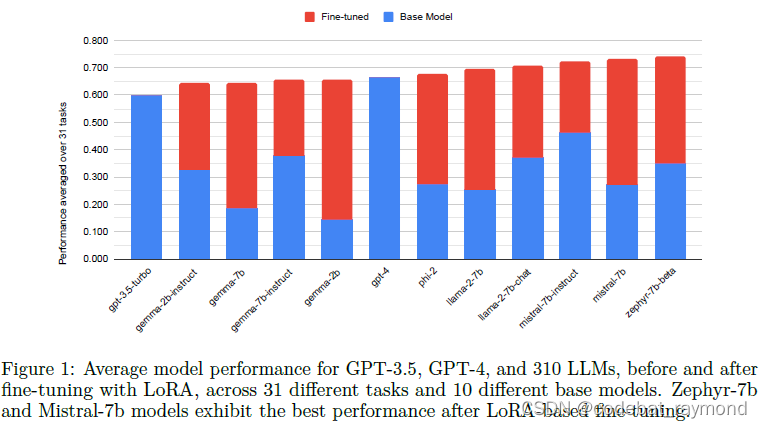

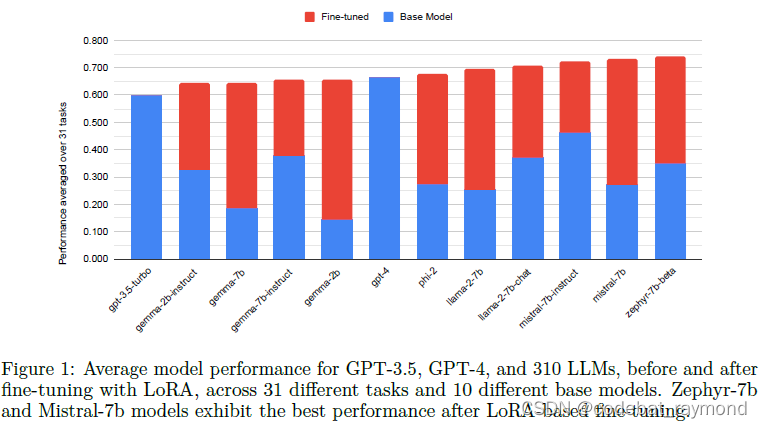

全面评估了LoRA微调在提升语言模型性能方面的有效性。通过在大量任务和基础模型上的实验,证实了LoRA作为一种参数有效微调技术的优势。4位量化LoRA微调模型能够以较小的开销达到甚至超过GPT-4的性能,这一结果非常振奋人心。

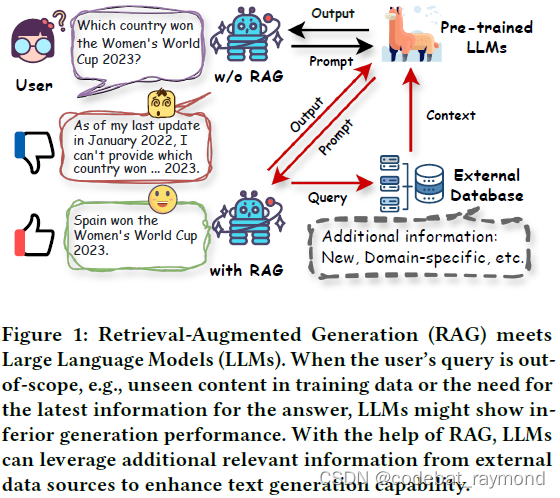

作为最基础的数据挖掘技术之一,检索旨在理解输入查询并从外部数据源中提取相关信息。它在各个领域都有广泛的应用,如搜索、问答和推荐系统。例如,搜索引擎(如谷歌、必应和百度)是检索在行业中最成功的应用;它们可以过滤和检索与用户查询最相关的网页或文档,使用户能够有效地找到所需信息。同时,通过在外部数据库中有效地维护数据,检索模型可以提供可靠和及时的外部知识,从而在各种知识密集型任务中发挥重要作用。由于其强

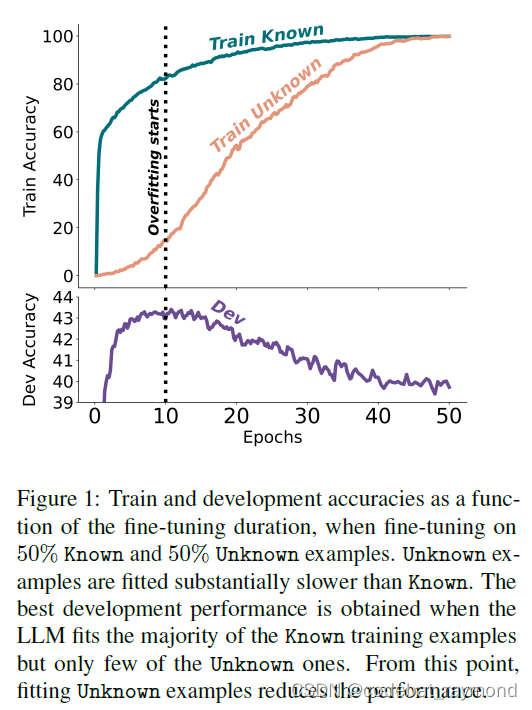

当大型语言模型通过监督式微调进行对齐时,它们可能会遇到在预训练期间没有获得的新事实信息。人们经常推测,这可能会教导模型产生事实上不正确的回应的行为,因为模型被训练成生成没有基于其预先存在的知识的事实。在这项工作中,Google研究了这种暴露在新知识下对微调后模型利用其预先存在知识的能力之影响。为此,他们设计了一个受控的设置,专注于闭书问答,改变引入新知识的微调样本的比例证明,大型语言模型在通过微调

多年來,大型語言模型(LLMs)已成為一項突破性技術,在醫療保健的各個方面都有巨大的潛力。這些模型,如GPT-3、GPT-4和Med-PaLM 2,在理解和生成類人文本方面表現出卓越的能力,使其成為應對復雜醫療任務和改善患者護理的寶貴工具。它們在各種醫療應用中都顯示出前景,例如醫療問答(QA)、對話系統和文本生成。此外,隨著電子健康記錄(EHRs)、醫學文獻和患者生成數據的指數級增長,LLMs可以

全面评估了LoRA微调在提升语言模型性能方面的有效性。通过在大量任务和基础模型上的实验,证实了LoRA作为一种参数有效微调技术的优势。4位量化LoRA微调模型能够以较小的开销达到甚至超过GPT-4的性能,这一结果非常振奋人心。

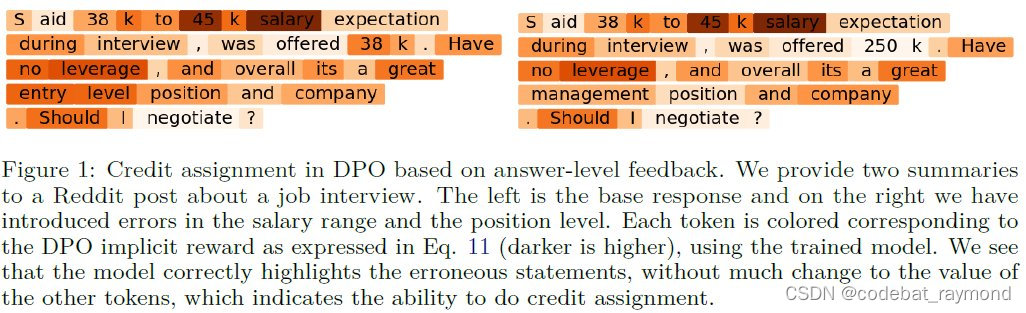

值得注意的是,由于语言的顺序特性,token级MDP具有独特的树形结构(tree structure),即在给定输入提示(初始状态)的情况下,模型的每个决策都会导向一个全新的状态,这与一般的MDP(例如棋类游戏)不同。DPO算法的目标就是调整模型参数,使其所对应的奖励函数符合人类偏好,同时DPO能够学习任意密集奖励函数对应的最优策略。近年来,随着深度学习的发展,深度Q网络(DQN)等算法将神经网络

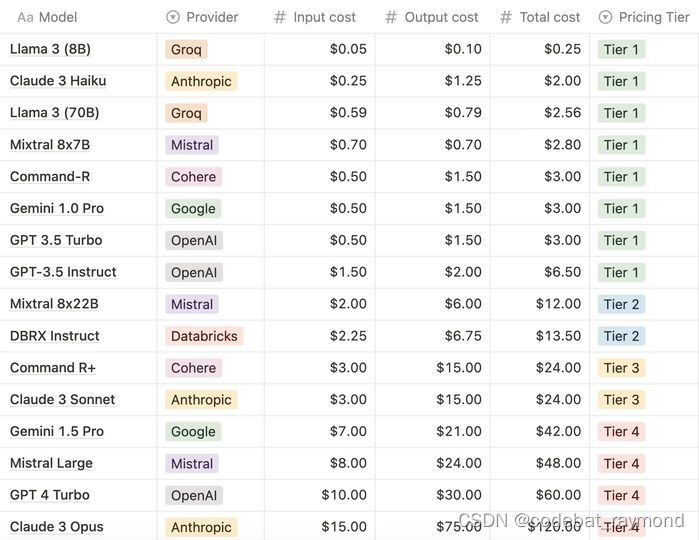

Groq的llama 3 70B、Databricks的DBRX Instruct、Cohere的Command r+,以及AnthropicAI的Opus,它们的性能和适用场景有所不同,因此选择哪个模型还需要考虑到您的具体需求和预算。如果需要具体的应用建议或进一步的成本分析,请提供更多详情。实际成本可能会根据具体的使用量、可能的折扣政策、订阅级别等因素有所不同。特别是大规模使用时,通常可以和服务

当大家还在讨论AI是否能进行复杂推理的时候,另一个有"破坏力创造"的进步却在悄然发生。那就是AI与基因编辑技术的结合!!我曾经参与生物芯片公司的运营, 所以从实务上深入分析这个应用带来的影响, 但是如果产业知识对您过于艰涩, 您可以直接看我的结论。基因工程技术的引入彻底改变了生物医学研究,使得对基因信息进行精确修改成为可能。然而,创建一个高效的基因编辑系统需要对CRISPR技术和复杂的实验系统有深