简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

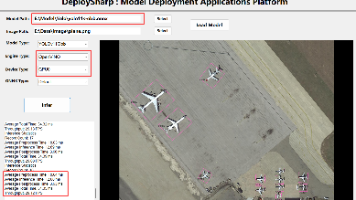

基于.NET Framework 4.8 开发的深度学习模型部署测试平台,提供了YOLO框架的主流系列模型,包括YOLOv8~v9,以及其系列下的Det、Seg、Pose、Obb、Cls等应用场景,同时支持图像与视频检测。模型部署引擎使用的是OpenVINO™、TensorRT、ONNX runtime以及OpenCV DNN,支持CPU、IGPU以及GPU多种设备推理。

摘要:基于DeploySharp开发的深度学习模型部署测试平台支持YOLOv5~v13系列模型,涵盖检测、分割、目标框和姿态估计等任务。平台提供OpenVINO和ONNX Runtime引擎,支持CPU、IGPU和GPU设备推理。项目提供.NET 6.0和.NET Framework 4.8版本,并展示了不同模型在不同硬件上的FPS性能测试结果。详细项目信息和性能数据可参考GitHub仓库链接。

基于.NET Framework 4.8 开发的深度学习模型部署测试平台,提供了YOLO框架的主流系列模型,包括YOLOv8~v9,以及其系列下的Det、Seg、Pose、Obb、Cls等应用场景,同时支持图像与视频检测。模型部署引擎使用的是OpenVINO™、TensorRT、ONNX runtime以及OpenCV DNN,支持CPU、IGPU以及GPU多种设备推理。

NVIDIA TensorRT™ 是用于高性能深度学习推理的 SDK,可为深度学习推理应用提供低延迟和高吞吐量。基于 NVIDIA TensorRT 的应用程序在推理过程中的执行速度比仅使用 CPU 的平台快 36 倍,使开发人员能够优化在所有主要框架上训练的神经网络模型,以高精度校准以降低精度,并部署到超大规模数据中心、嵌入式平台或汽车产品平台。

在深入参与开源项目的过程中,我也广泛参考了网上的一些成功项目经验,得到了无数宝贵的经验和技能提升,这使得我的技术层次上升到了全新的高度。经过两年的探索与实践,技术能力得到了显著的提高,而更重要的是,我的努力得到了越来越多人的认可和支持,从而扩大了我在技术社区的影响力。时值我开展开源项目的两周年,有机会整理与分享我从一个技术新手逐步成长到拥有自己开源项目的经验与感想。我希望我的分享能为刚刚踏入开源领

2024 Intel®“走近开发者”互动活动-哪吒开发套件免费试用AI创新计划:哪吒开发板是专为支持入门级边缘AI应用程序和设备而设计,能够满足人工智能学习、开发、实训等应用场景。为了测试该开发板的推理性能,同时测试所推出的OpenVINO™ C# API项目能否应用到该开发板上,我们使用该开发板,结合OpenVINO™ C#

OpenVINO™是一个用于优化和部署深度学习模型的开源工具包,是英特尔基于自身现有的硬件平台开发的一种可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,用于快速开发应用程序和解决方案,以解决各种任务(包括人类视觉模拟、自动语音识别、自然语言处理和推荐系统等)。官方发行的OpenVINO™未提供C#编程语言接口,因此在使用时无法实现在C#中利用OpenVINO™进行模型部署。

最新版的OpenVINO 2022.1 版本不在默认附带OpenCV工具,所以我们需要额外安装OpenCV工具。

最新版的OpenVINO 2022.1 版本不在默认附带OpenCV工具,所以我们需要额外安装OpenCV工具。