简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

神经符号人工智能(Neuro-Symbolic AI)是连接主义与符号主义深度融合的AI子领域,旨在结合神经网络的数据学习能力和符号系统的逻辑推理能力。其核心优势在于互补性:神经网络擅长感知任务(如图像识别),符号系统擅长认知任务(如逻辑推理)。近年来,深度学习的技术突破推动了该领域的复兴,同时产业对可解释性AI的需求也加速了其发展。主要研究方向包括用深度学习解决符号问题(如逻辑推理)和用符号知识

本文提出SELF-RAG框架,通过自我反思实现检索增强生成。传统RAG方法固定检索且缺乏评估,而SELF-RAG创新性地引入反思令牌,使模型能自适应检索并评估生成内容。该方法训练一个统一模型,在推理时通过反思令牌(如判断检索需求、评估相关性和事实支持度)实现可控生成。实验表明,SELF-RAG在多项任务上超越现有模型,尤其在事实准确性和引用质量方面表现突出。该框架通过自我监控机制,在提升生成可信度

《Native Sparse Attention (NSA)》提出了一种革命性的稀疏注意力机制,通过三条并行分支显著提升长文本处理效率:全局压缩注意力(复杂度O(m²))、选择性注意力(O(nk))和滑动窗口注意力(O(ws))。实验显示,该方法在64k序列长度下实现11.6倍加速,显存消耗降低35%,同时精度提升0.022-0.034。相比传统全注意力(O(n²))和其他稀疏方案,NSA通过动态

AI Layer时代:互联网入口的范式变革 摘要:AI正在重构互联网入口模式,从传统GUI(图形界面)转向LUI(自然语言交互)的意图理解层(AI Layer)。这一中间件层通过语义理解、任务拆解和服务调度,连接人类意图与数字服务。商业逻辑随之从"流量变现"转向"服务分发",软件形态也将后端化。未来竞争力在于Prompt工程能力和批判性思维,而非工具操作熟练

摘要: Yann LeCun 在访谈中批判了硅谷对 Scaling Law 的盲目信仰,指出大语言模型(LLM)的能力提升仅是统计拟合的增强,而非真正的智能突破。他认为 LLM 缺乏对世界的本质理解,其语言能力掩盖了智能缺陷,关键在于缺失“世界模型”——即预测和推理的能力。LeCun 强调,真正的通用智能(AGI)应是多系统协同,而非单一模型无限扩展。这一观点提醒我们区分“表现智能”与“真正理解”

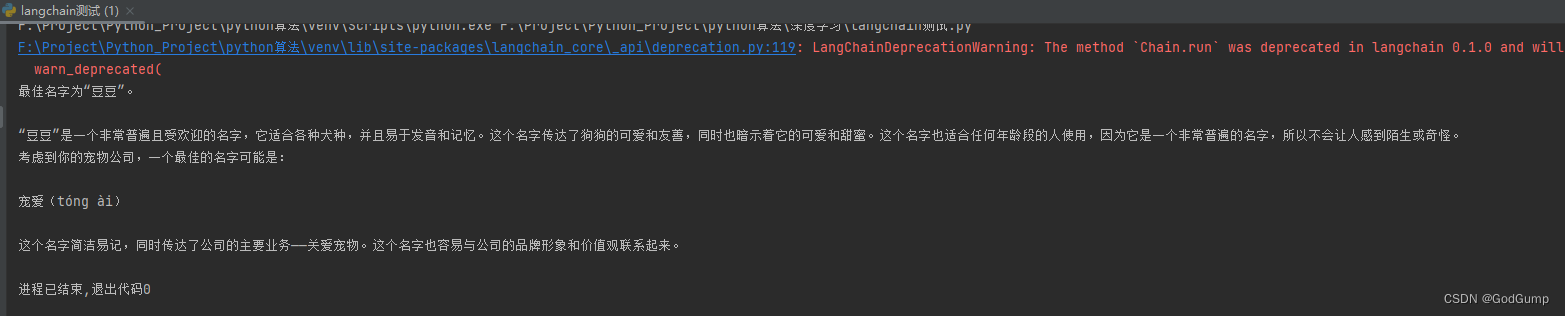

LangChain是一个基于大语言模型(如ChatGPT)的Python框架,专为构建端到端语言模型应用而设计。它提供了一套全面的工具、组件和接口,旨在简化与大型语言模型(LLM)和聊天模型的交互过程,从而轻松创建出功能强大的应用程序。LangChain不仅方便管理语言模型的交互,还能将多个组件灵活链接,满足各种应用场景的需求。使用LangChain,您可以更加高效地构建出具有创新性和实用性的语言

先安装fasttext文本分类种类二分类:文本被分类两个类别中, 往往这两个类别是对立面, 比如: 判断一句评论是好评还是差评.单标签多分类:文本被分入到多个类别中, 且每条文本只能属于某一个类别(即被打上某一个标签), 比如: 输入一个人名, 判断它是来自哪个国家的人名.多标签多分类:文本被分人到多个类别中, 但每条文本可以属于多个类别(即被打上多个标签), 比如: 输入一段描述, 判断可能是和

2.此目录为我的安装目录,如果不是默认的安装目录,则根据自己的安装情况进行更改。1.V后面的数字表示版本,请根据自己的版本进行更改。一般右键有个打开终端,没有只能cmd用cd导入了。

文章目录特征解释代碼分布解析导包构建数据集创建模型模型训练模型预测效果特征解释battery_power:电池一次可储存的总能量,单位为毫安时blue :是否有蓝牙clock_speed:微处理器执行指令的速度dual_sim:是否支持双卡fc:前置摄像头百万像素four_g:是否有4Gint_memory:内存(GB)m_dep:移动深度(cm)mobile_wt:手机重量n_cores:处理器

以连接数据库并显示为列子,我还用了2个数据控件更好地理解一些常用属性:数据源在这里,这里我选的是Sql的然后对数据源进行配置:先右键数据库的服务器属性(右边那个就是服务属性,我这里是DES开头)右键点击配置数据源配置好数据库,接下来配置查询语句(相对灵活,也可以直接点完)这样配置简单些GridView和FormView进行对数据控件的分析在属性里面进行修改(上图字体变黑...