简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

如何通过知识图谱+大语言模型提高本地问答系统准确性,大模型入门到精通,收藏这篇就足够了!

这样我们把在知识图谱查到的上下问信息再拿到向量数据库做相似度匹配,我们就能够搜索到更多的有用信息,然后再把这些信息丢给大模型进行处理,我们就能够得到更准确的答案。

关于如何搭建anythingllm+ollama(deepseekr1、嵌入模型)+milvus的本地知识库语言模型

关于如何搭建anythingllm+ollama(deepseekr1、嵌入模型)+milvus的本地知识库语言模型

MaxKB基于大语言模型和 RAG 的知识库问答系统

MaxKB 是一款基于大语言模型和 RAG(检索增强生成)的开源知识库问答系统,专为智能客服、企业知识库管理、学术研究和教育等多场景设计。

【大模型学习路线】初学者该怎么入门大语言模型(LLM)附学习路线?

大语言模型盛出不穷,特别是ChatGPT和GPT4出来之后,各家厂商就一直在大模型领域上内卷。

大模型开发入门到进阶:学习路线图分享,大模型入门到精通,收藏这篇就足够了!

大模型开发入门到进阶:学习路线图分享,大模型入门到精通,收藏这篇就足够了!

最详细的大模型学习路线整理出来啦!手把手教你最高效的大模型学习方法

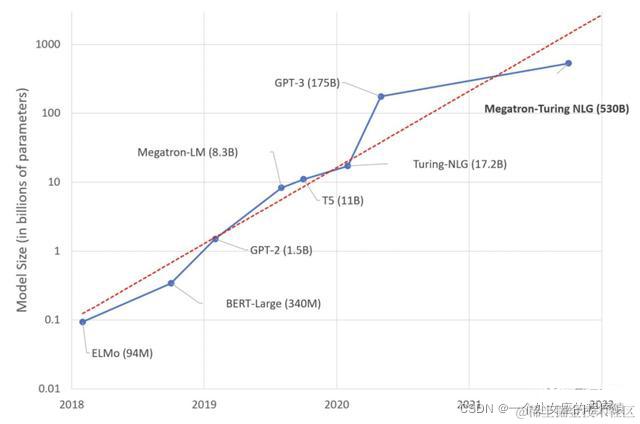

千亿乃至万亿参数规模的大模型相继涌现,各大企业与高校纷纷发布研究成果,预示着通用人工智能时代的到来。

32岁转行AI大模型,从传统行业到技术专家,我的5个关键转折点

32岁转行AI大模型,从传统行业到技术专家,我的5个关键转折点

别再被“水课”坑了!大模型入门,这门课就够了

从笔者的视角来看,市面上很多AI讲师本质上啥也不懂,很多人讲课都是尽提供一些可有可无的情绪价值。

35岁裸辞,被拒 112 次后,我拿下了 Agent offer

35岁裸辞,被拒 112 次后,我拿下了 Agent offer

AI下一代浪潮?—人工智能的大语言模型(LLMs)的简介、发展以及未来趋势

大型语言模型(LLMs)是在包含巨大数据量的大规模数据集上训练的。