简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

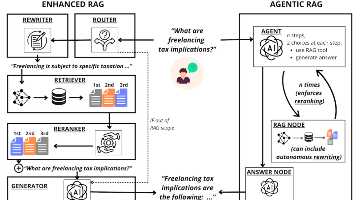

RAG系统对比研究:Enhanced与Agentic架构的实测分析 研究对比了两种检索增强生成(RAG)架构:规则化的Enhanced RAG与自主决策的Agentic RAG。实验显示,在金融等特定领域,Agentic的意图识别准确率高达98.8%,查询改写环节NDCG指标平均提升2.8点;但在开放域任务中,Enhanced的固定流程更稳定。成本方面,Agentic的token消耗是Enhanc

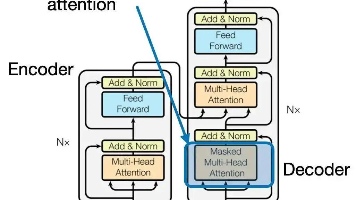

自注意力机制的发展与应用 自注意力机制(Self-Attention)是Transformer架构的核心组件,最早由Google Brain团队在2017年提出。与传统注意力机制依赖外部信息源不同,自注意力机制完全在输入序列内部进行信息交互,通过计算查询(Q)、键(K)、值(V)三个向量之间的关系来捕捉序列内部的依赖关系。该机制解决了RNN类模型难以并行化和长距离依赖的问题,显著提升了模型性能。其

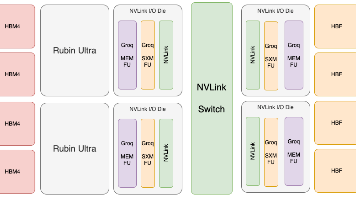

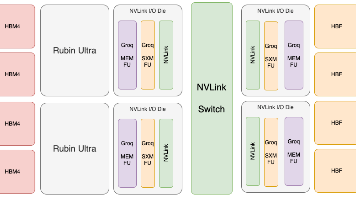

本文探讨了大型语言模型(LLM)推理面临的内存带宽和互连延迟等关键挑战。作者指出,随着模型规模扩大和多模态应用增多,内存容量和带宽成为主要瓶颈,而非计算能力。论文提出了四个研究方向:高带宽闪存(HBF)提供大容量存储、近存计算(PNM)提升内存带宽、3D堆叠技术优化集成密度,以及低延迟互连加速芯片间通信。这些方案旨在解决当前GPU/TPU架构在推理效率上的不足,为下一代AI硬件设计提供新思路。文章

本文探讨了大型语言模型(LLM)推理面临的内存带宽和互连延迟等关键挑战。作者指出,随着模型规模扩大和多模态应用增多,内存容量和带宽成为主要瓶颈,而非计算能力。论文提出了四个研究方向:高带宽闪存(HBF)提供大容量存储、近存计算(PNM)提升内存带宽、3D堆叠技术优化集成密度,以及低延迟互连加速芯片间通信。这些方案旨在解决当前GPU/TPU架构在推理效率上的不足,为下一代AI硬件设计提供新思路。文章

2025年全球大模型行业进入"三足鼎立"格局,OpenAI、Anthropic和Google成为主导力量。OpenAI凭借GPT-5系列、微软支持及行业定义能力保持领先;Anthropic以安全为核心理念,获得亚马逊、谷歌等巨头投资;Google则通过Gemini 2.0深度整合自家生态。三家公司凭借顶尖人才、巨额资本和体系化工程优势形成难以逾越的行业壁垒。这场AI竞赛已从技术

Transformer是现代大模型的基础架构,以自注意力为核心,实现序列并行处理。它由Encoder和Decoder组成,包含嵌入、位置编码、自注意力、多头注意力、前馈网络、残差连接和层归一化等组件。Transformer具有高效并行计算、强长距离建模能力、训练稳定易扩展等优势,广泛应用于自然语言处理、计算机视觉和音频处理等领域。

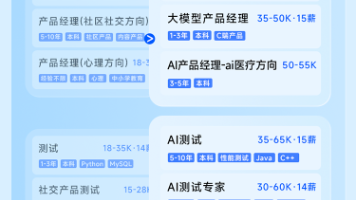

近年来,当你试图搜寻AI产品经理的JD时,会发现一个明显的趋势:2024年初那些“对AI有热情”、“愿意探索新方向”的模糊要求,在2025年已被“有真实项目经历”、“熟悉大模型技术”、“负责AI商业化策略”等硬核、具体的指标所取代。

2025年初,杭州DeepSeek公司发布的DeepSeek-R1模型,以仅560万美元的训练成本达到世界顶级性能,彻底打破了AI大模型仅属于科技巨头的神话。AI技术的普及化浪潮已经来临,企业纷纷寻求将AI能力融入现有系统。此时,全球运行着的25亿多个Java应用、超过90%的服务端Java系统,正面临一场前所未有的AI化转型挑战。那些只会调用API的Java程序员将面临被淘汰的风险,而掌握工程化

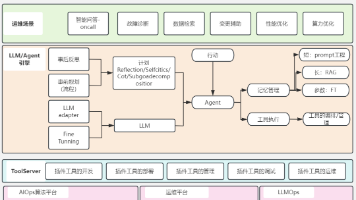

在数字化转型的浪潮中,企业的IT系统正变得越来越复杂:微服务架构、混合云环境、容器编排平台、跨区域部署……每一个组件都在高频运转,也都可能成为潜在的“隐雷”。对于运维团队而言,这种复杂度带来的挑战前所未有。

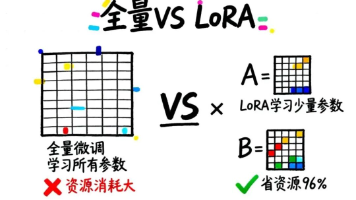

当我们拿到一个大语言模型(如Llama、Qwen)时,常常发现它在某些任务上表现不够好。这时候,微调(Fine-tuning)就成了提升模型能力的关键手段。但问题来了:微调一个70B参数的模型,可能需要数百GB显存和数万元成本。有没有更经济的方法?今天我们要讲的LoRA(Low-Rank Adaptation)技术,能让你用不到4%的资源完成微调,效果还不差!这是怎么做到的?让我们从微调的本质说起