简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

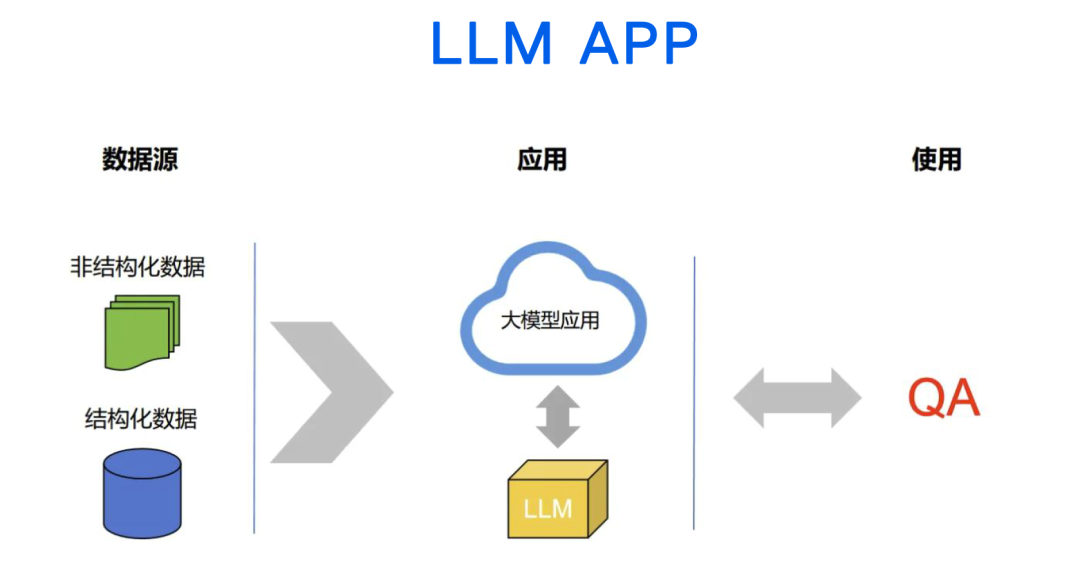

LangChain是一个基于大语言模型(LLMs)构建应用的开源框架,它为开发者提供了一系列强大的工具和接口,使得创建由LLMs支持的应用程序变得更加简单高效。无论是聊天机器人还是图生文、文生图等复杂任务,LangChain都能轻松应对。这一框架通过提供统一的抽象层,让开发者可以将更多精力投入到业务逻辑上,而不是重复造轮子。此外,LangChain还具备通用性,通过API或网站即可与LLM进行交互

近年来,AI的火爆程度有目共睹。从日常使用的智能语音助手、推荐算法,到企业中的智能客服、数据分析工具,AI技术的应用场景不断拓展。随着技术的不断迭代,AI大模型的能力越来越强,能够处理的任务也越来越复杂。这种广泛的应用需求,推动了AI产业的快速发展,也催生了大量相关的就业岗位。

本文分享了在无GPU的本地电脑上部署DeepSeek R1大模型与RAGFlow的实践过程。作者使用AMD Ryzen 5 5600G处理器、16GB内存的Windows 11环境,通过虚拟机运行CentOS 7.9和Docker完成部署。步骤包括:安装Ollama并下载DeepSeek模型(7B和1.5B版本)、配置RAGFlow完整版(含Embedding模型)、解决Elasticsearch

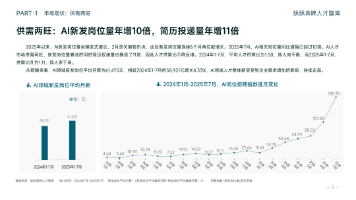

《2025年AI人才流动报告》显示AI领域"供需两旺",岗位量暴涨10倍。大模型算法岗需求最旺,AI科学家月薪超13万。中小企业AI岗位增长13倍,非技术岗需求增7.7倍,表明AI从技术走向业务落地。人才流动频繁,平均司龄仅2.02年。求职者应关注算法核心岗和"AI+垂直行业"复合能力。

LangChain与LangGraph作为大模型开发框架各有侧重:LangChain提供丰富组件库和LCEL编排能力,适合简单一次性任务;LangGraph采用图结构架构,支持复杂状态管理和多智能体协作,适合构建Agent系统。选择应基于项目需求:简单任务选LangChain,复杂Agent系统选LangGraph,两者可组合使用。文章从技术架构、应用场景等维度深入分析,为开发者提供框架选型决策参

本文将从生物神经网络、人工神经网络、神经网络训练、分类与应用四个方面,带您一文搞懂人工神经网络ANN

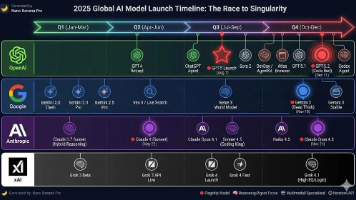

2025年AI产业进入商业爆发期,大模型从技术竞赛转向价值导向,多模态融合、轻量化部署、高实用性优化成为主流趋势。算力产业链完善支撑产业基础,商业化落地聚焦垂直场景,具身智能与自动驾驶打开万亿市场。中国AI市场规模突破1.2万亿元,全球朝万亿级迈进,算力、应用和新兴场景是三大投资主线。

AI大模型竞赛已进入周级节奏,技术优势不再是护城河。智能成本持续下降,推动生成式AI应用即将大规模爆发。AI正从Chatbot向Agent转变,但面临多步复合误差挑战。传统行业专业领域因"认知负载结构性超载"而快速采纳AI。2026年将迎来AI应用爆发期,关键是从Bolt-on模式转向AI-First产品理念,将60分模型做成生产级产品。

【深度研究】AI Agent赋能传统企业转型:30个智能体应用案例剖析【实战指南】AI Agent商业案例精选,助你技术选型和落地实施AI Agent商业应用指南:30个典型场景解读【案例精选】AI Agent改变企业效率的革命:30个应用项目复盘AI Agent重塑企业未来:30个创新应用与发展方向双12期间,电商领域没有激起太多波澜,人工智能界仍然声浪迭起。这一边,OpenAI开启12场直播的

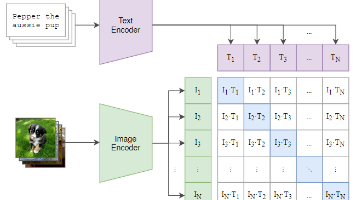

CLIP是OpenAI开发的突破性多模态模型,通过对比学习让模型从4亿组互联网图文对中自主学习,实现对视觉信息的语义理解。该模型包含视觉编码器和语言编码器,采用图文匹配任务进行训练,实现了零样本学习能力,无需针对特定任务微调即可完成预测。CLIP解决了传统计算机视觉模型依赖人工标注、类别封闭、泛化能力不足等问题,但面对细粒度分类任务时性能仍有局限。