简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大模型领域作为人工智能的热点,正处于蓬勃发展阶段,对高效、智能解决方案的需求日益增长。转行大模型领域不仅来得及,而且非常明智。文章分析了市场需求、个人成长、行业门槛等因素,指出程序员转行大模型的优势,并提供了转行步骤,包括基础知识学习、实践操作、关注行业动态、建立专业网络等。此外,文章还详细介绍了大模型学习的三个阶段:初阶应用、高阶应用和模型训练,以及商业闭环的探索,旨在帮助程序员成功转行并掌握大

2026年春节前后,中国AI企业深度求索(DeepSeek)将发布新一代旗舰模型DeepSeek V4,有望在编程能力上首次超越GPT和Claude等国际顶尖模型。该模型采用条件记忆模块和稀疏模型优化等创新技术,在SWE-Bench Pro测试中以58%准确率领先GPT-5.3-Codex 3.6个百分点,部分垂直场景准确率超85%。DeepSeek V4在性能方面优势显著,响应时间仅为GPT的一

本文系统介绍了AI大模型应用开发的完整学习路径,分为四个阶段:大模型基础、RAG应用开发、Agent应用架构和微调部署。针对后端开发者转型AI开发的需求,强调这不仅是技术栈转换,更是思维方式和工程经验的迁移。文章指出AI应用开发的核心在于将大模型视为强大API,通过Prompt设计、上下文处理和业务逻辑组织实现功能。提供了详细的学习建议和丰富的资源,包括学习路线图、商业化方案、视频教程等,帮助开发

离最后一场面试过去一段时间了,是时候做一个小小的复盘。从4月份开始自学大模型,最开始我连llm是什么都不知道。我的路线是先做定位为大模型应用。每天下班学几个小时。 从4月到11月,基本就是学基础,总结八股,看书,同时保持每天刷2道左右Leetcode。(期间只要有节假日基本都请假去旅游,所有估计有2个月都在玩,不过学习的时候也是有认真学)

马斯克旗下AI助手Grok推出"智能伴侣"功能,基于Grok4大模型实现3D交互式角色扮演。首批上线动漫角色Ani和小熊猫Rudy,支持语音对话和动作互动,其中Ani还包含NSFW模式。该功能引发热议,支持者认为创新了AI交互方式,批评者则质疑角色设计过于轻浮。实测显示中文对话存在机械感,但动画流畅度较高。此举被视为进军AI情感陪伴市场,与Character.AI等产品形成竞争。同时Grok4在游

本文为想要进入AI大模型领域的程序员及小白提供了职业规划与学习指南。文章首先详细解析了模型研发、算法工程师、AI产品经理等6大热门岗位的技能要求与职业前景;随后分享了一套从系统设计到垂直领域微调的7阶段进阶学习路线;最后文末附赠了包含视频教程、PDF书籍及面试题库在内的全套免费学习资料,助力读者系统掌握大模型技术

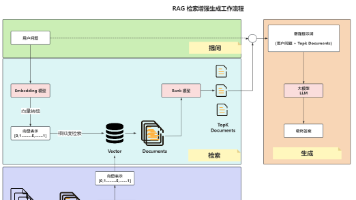

文章介绍了使用Spring AI实现RAG技术的两种方法:手动查询向量数据库拼接提示词,或使用QuestionAnswerAdvisor API简化实现。通过复用知识库构建逻辑,将本地向量数据库相关数据与用户问题一起发送给大模型处理,实现智能问答功能。Advisor API底层实现逻辑与手动方法一致,都是查询向量数据库并拼接提示词。

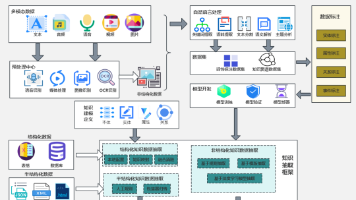

本文详细解析AI大模型应用架构,从多模态数据接入、预处理、知识与模型中台,到业务应用落地及持续优化的全链路设计。通过分层剖析各关键模块与技术实现,为读者提供从数据到业务落地的完整技术路线图,帮助开发者搭建智能化系统,让大模型真正成为业务升级的核心引擎。

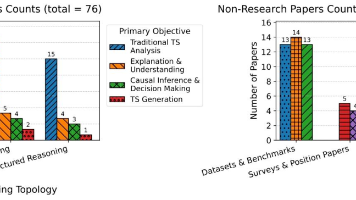

时间序列推理(Time Series Reasoning, TSR)是将大语言模型(LLMs)的推理能力与时间序列数据深度融合的新兴领域,解决传统方法缺乏解释性、难以处理因果等问题。该综述构建了"推理拓扑-核心目标-属性标签"三维分类框架,系统梳理研究成果,并指出未来方向:从"窄精度"迈向"大规模可靠性",实现可解释、能决策的智能分析系统,为金融、医疗等领域提供新范式。

2024年和2025年是大模型和AI技术快速崛起的两年, 目前大模型已经在改变我们的工作方式,程序员应该如何顺应这一浪潮?以下是个人的一些思考AI 可以帮助程序员写代码,但理解业务逻辑、架构设计、系统优化等仍然需要人来做。与其被 AI 取代,不如学会如何利用 AI 提高效率。大模型降低了开发门槛,未来个人开发者或小团队可以借助 AI 更快实现产品,探索创业机会。未来的程序员更像是,不仅写代码,还需