简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

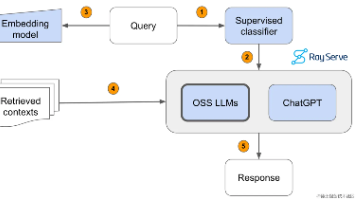

RAG是的缩写,翻译为中文的意思就检索增强,以基于最新,最准确的数据建立LLM的语料知识库。LLMLangChain是一个用于开发由语言模型驱动的应用程序的框架。具有上下文感知能力:将语言模型与上下文源(提示说明、少量镜头示例、基于其响应的内容等)联系起来。原因:依靠语言模型进行推理(关于如何根据提供的上下文回答,采取什么行动等)import osos.environ["QIANFAN_AK"]

LLaMA-Factory 是一个强大且高效的工具库,旨在简化和加速 LLaMA(Large Language Model Meta AI)模型的训练、微调和部署过程。

微调 LLaMA(Large Language Model Meta AI)大模型是一个重要的步骤,能够使模型适应特定的任务或数据集,提高其在特定应用场景下的表现。

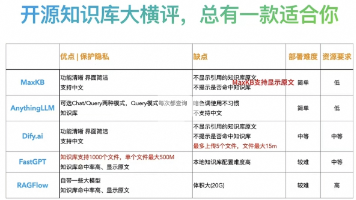

它能够帮助企业高效地管理知识,并提供智能问答功能。想象一下,你有一个虚拟助手,可以回答各种关于公司内部知识的问题,无论是政策、流程,还是技术文档,MaxKB 都能快速准确地给出答案:比如公司内网如何访问、如何提交视觉设计需求等等

Ollama 目标在于简化在 Docker 容器中部署大型语言模型的过程,使得非专业用户也能方便地管理和运行这些复杂的模型。

Mem0 作为一种革命性的AI记忆技术,为构建个性化的AI应用提供了全新的解决方案。Mem0 不仅可以提高AI代理的智能水平,还可以为用户带来更加个性化和人性化的AI体验。

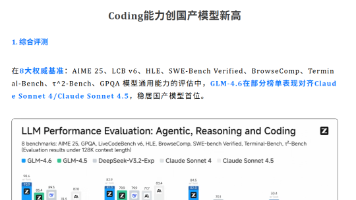

最强编程Agent Claude Code结合最强国产开源模型GLM4.6部署教程

今天我们探讨一个话题:在大模型项目落地的过程中,如何判断是选择RAG还是微调。我相信这也是困扰很多朋友的问题。为了深入讨论这个话题,我首先跟大家对比一下RAG和微调的本质区别。

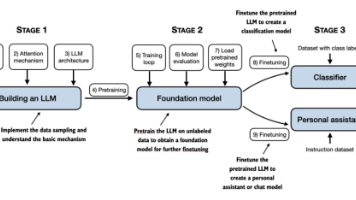

今天,推荐给大家的是目前英文版本位列Amazon数据处理类图书榜单第一、中文版本在京东已售7万+的图书《Build a Large Language Model (From Scratch)》(中文名《从零构建大模型》)。

Function的调用时Agent实现很重要的一步,只有了解了这个原理才可以更好的创建Agent。