简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文详细介绍了RAG系统中核心的Embedding和Rerank模型。Embedding模型负责将文本向量化以进行相似度检索,而Rerank模型则在检索基础上进一步精确排序,提升相关性。文章从功能目标、应用阶段和技术实现三个维度对比了两种模型,并辅以实例说明,适合初学者和程序员学习大模型基础知识。Embedding和Rerank模型是RAG系统中的核心模型。在RAG系统中,有两个非常重要的模型一个

MemVerge推出MemMachine通用记忆层方案,通过"图+表+向量"三层架构解决AI Agent记忆问题。相比传统RAG,它能精准存储用户偏好、历史互动等结构化信息,降低开发门槛并提升产品粘性。支持私有化部署和MCP生态,特别适合医疗、金融等需要长期记忆的场景,助力AI从实验性产品向实用工具转型。该方案通过结构化记忆构建差异化竞争优势,为AI产品建立用户迁移壁垒。

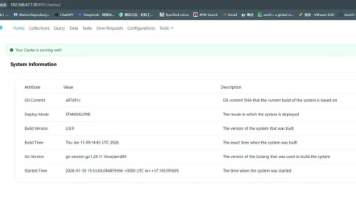

本文介绍了基于SpringAI框架构建本地知识库系统的实现方案,整合了Qwen3-8B大语言模型、bge-large-zh-v1.5嵌入模型和Milvus向量数据库。文章详细说明了环境配置要求,包括24G+显卡、Python运行环境及模型部署方式,并提供了完整的代码实现,涵盖依赖配置、模型初始化、数据加载和问答接口设计。系统采用三国演义知识问答数据集,实现了基于向量检索增强的智能问答功能,所有代码

摘要:大模型应用开发应遵循"简单至上"原则,复杂流程会增加系统风险。由于模型存在幻觉等不稳定特性,建议在非关键环节使用模型提高效率,在核心环节采用workflow工作流确保稳定性。系统稳定性比功能强大更重要,尤其在安全敏感领域。开发者需在技术创新与系统可靠性之间找到平衡点,能用简单方案(RAG等)解决的问题就不使用复杂技术(Agent等)。(149字)

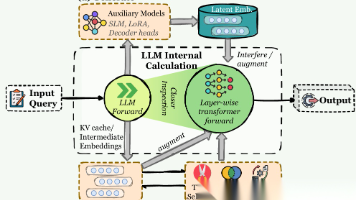

本文系统阐述了AI智能体记忆系统的多维架构与运作机制。从形式层面划分了词元级、参数和潜在三种记忆类型;功能层面区分了事实记忆、经验记忆和工作记忆;动态层面解析了记忆的形成、演化和检索过程。文章辨析了智能体记忆与大语言模型记忆、RAG及上下文工程等概念的区别,指出智能体记忆具有跨任务持久性、环境适应性和主动管理能力等特征。研究表明,智能体记忆是实现持续学习与环境交互的基础,为构建具有长期适应能力的智

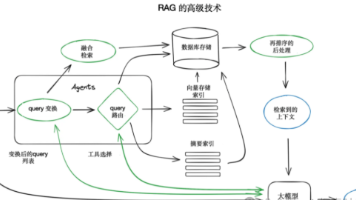

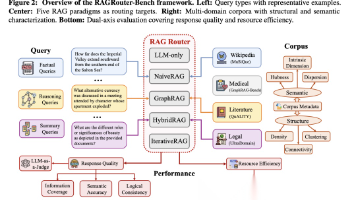

本文系统梳理了RAG技术的最新发展,重点分析了5种主流范式(LLM-only、NaiveRAG等)的适用场景与性能表现,并介绍了AgenticRAG的创新A-RAG方案。研究基于RAGRouter-Bench数据集,通过分层检索工具和智能体循环机制,显著提升了多跳问答的准确性。文章为开发者提供了根据查询类型和语料特性选择RAG范式的实用建议,同时指出复杂范式需权衡效果与资源成本的考量要点。

大模型入门没有“门槛”,但需要“耐心”和“实操”。零基础小白无需害怕,按照“明确方向→夯实基础→核心技术→实战落地→职业规划”的路径,一步一个脚印,3-6个月就能实现从“新手”到“能落地项目”的突破;程序员可借助自身优势,快速进阶,拓展职业边界。

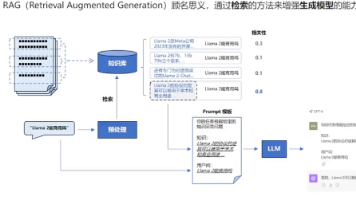

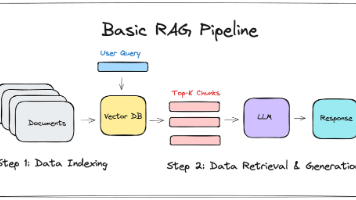

RAGRetrieval Augmented Generation,检索增强生成),本质是给LLM“装一个外部知识库”——让大模型在回答问题前,先从你指定的数据库中检索相关上下文,再结合自身能力生成答案,核心目的是提升回答的准确性、时效性和可信度。很多小白会疑惑:LLM已经训练了海量数据,为什么还需要RAG?关键问题在于:LLM的训练数据有时效性上限(比如训练到2023年,就无法回答2024、20

AI风口吹了这么久,你还在围观徘徊、无从下手吗?看着身边程序员靠AI算法拿下30W+高薪Offer,有人转型AI产品实现职业跃迁,而自己却连NLP和CV的核心区别都搞不清;想切入赛道又被年龄焦虑困住——25岁怕没项目经验、35岁怕被行业淘汰、40岁不敢迈出转行第一步,甚至零基础小白连入门门槛都摸不透……别慌!从最值得入局的5大细分领域、头部企业城市分布,到不同年龄段专属突围路径,再到外行人跨行避坑

Token 可以理解为语言的最小计量单位,是大语言模型理解和处理文本的基本单位(可以直观地认为是“一个词”)。Tokenizer(分词器)作用是当你输入自然语言文本时,模型第一步不是直接处理原始字符,而是先把文本拆成token对中文来说,通常一个汉字或一个词可以算作一个 token,但也可能按分词规则拆成更小的单位。对英文来说,一个 token 不一定等于一个完整单词,有时是单词的一部分,甚至可能