简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

l值:l = V[$_CAHJk(326)](yt[$_CAIAL(291)](o), r[$_CAHJk(766)]()),其中yt[$_CAIAL(291)]其实就JSON.stringify方法,r[$_CAHJk(766)]()就是之前生成的随机字符串。V[$_CAHJk(326)]直接扣代码即可。其中this[$_CBGAs(766)](t)是一个随机字符串生成函数,可以固定写死,new

一、array类型建表语句:create table 表名(要素1 类型,要素2 类型,要素3 array)row format delimited filedsterminated by '\t' collection items terminated by ',';

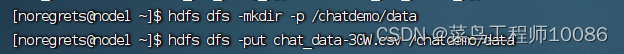

聊天平台每天都会有大量的用户在线,会出现大量的聊天数据,通过对聊天数据的统计分析,可以更好的对用户构建精准的用户画像,为用户提供更好的服务以及实现高 ROI 的平台运营推广,给公司的发展决策提供精确的数据支撑。项目将基于一个社交平台 App 的用户数据,完成相关指标的统计分析并结合 BI 工具对指标进行可视化展现。从 A 抽取数据 (E) ,进行数据转换过滤 (T) ,将结果加载到 B(L) ,就

包含Hive、MySQL等安装配置

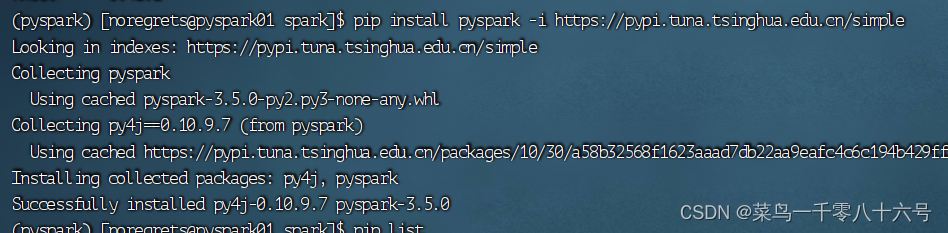

一、pyspark类库类库:一堆别人写好的代码,可以直接导入使用,例如Pandas就是Python的类库。框架:可以独立运行,并提供编程结构的一种软件产品,例如Spark就是一个独立的框架。PySpark是Spark官方提供的一个Python类库,内置了完全的Spark API,可以通过PySpark类库来编写Spark应用程序,并将其提交到Spark集群中运行。(1)下载PySpark库。

一、array类型建表语句:create table 表名(要素1 类型,要素2 类型,要素3 array)row format delimited filedsterminated by '\t' collection items terminated by ',';

无免费的午餐定理:没有一个数据分析算法可以在任何领域总是产生最准确的数据分析结果,必须针对具体问题讨论具体适用的数据分析方法。数据采集、数据存储、数据清洗、特征提取、特征选择、模型选择、模型训练、模型评测、数据可视化。丑小鸭定理:世界上不存在分类的客观标准,一切分类的标准都是主观的。偏差检测:对分析对象中少数的、极端的特例的描述,揭示内在的原因。大数定律:大量重复实验出现的结果的平均值一定接近于某

进入到网络配置文件中。快照,是对虚拟机的当前状态进行保存,在虚拟机出现问题无法解决,可以通过返回快照,使虚拟机返回到快照拍摄状态。4.配置jdk软连接 命令:ln -s /export/servers/jdk1.8.0_361 /export/servers/jdk。3.选择克隆对象,一共有两种方式,第一种是直接克隆虚拟机的当前状态,第二种是选取虚拟机的快照,克隆指定快照的虚拟机状态。构建软连接: