简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

与其他主要语言如C语言和Java语言相比,Python以非常强大和简单的方式实现了面向对象编程:Python是一种完全面向对象的语言,函数、模块、数字和字符串都是对象,完全支持继承、重载、派生和多重继承,这有利于提高源代码的可重用性。进阶就是专注于Python的某个领域做深入研究了,Python主要包含了AI领域(NLP,深度学习,图像处理啥的,反正无所不能),Web开发(后端服务,爬虫),数据处

自2018年BERT发布以来,“预训练+微调”成为语言模型的通用范式。以ChatGPT为代表的大语言模型针对不同任务构造Prompt来训练,本质上仍然是预训练与微调的使用范式。千亿规模的参数微调需要大量算力,即使提供了预训练的基座模型,一般的研究机构也很难对其进行全量微调(即对所有参数进行微调)。为了应对这个问题,相关学者提出了PEFT(Parameter-Efficient Fine-Tunin

在人工智能领域,特别是模型训练和推理阶段,显卡性能极为关键。随着模型规模的增加,对算力的需求也在不断上升。因此,挑选合适的显卡,实现高性能与性价比的平衡,成为众多开发者关注的焦点。市面上的加速卡种类繁多,但谈到适合大模型推理的显卡,4090无疑是当前的佼佼者。尽管在性能上不及H100,在价格上不如3090,但4090凭借其出色的性价比和性能,成为大模型推理的首选。4090显卡基于Ada Lovel

自2018年BERT发布以来,“预训练+微调”成为语言模型的通用范式。以ChatGPT为代表的大语言模型针对不同任务构造Prompt来训练,本质上仍然是预训练与微调的使用范式。千亿规模的参数微调需要大量算力,即使提供了预训练的基座模型,一般的研究机构也很难对其进行全量微调(即对所有参数进行微调)。为了应对这个问题,相关学者提出了PEFT(Parameter-Efficient Fine-Tunin

什么?炼个大模型还嫌贵?到底哪里贵了!??争先恐后训练大模型,搞得现在“算力慌”“一卡难求”,算力当然水涨船高了!“特供版”GPU又贵又缩水,大家自己愿意当“冤大头”囤卡,还好意思埋怨贵了?这么多年有没有认真工作?为什么这么多算力还依赖进口!自己为什么不能制造芯片?有没有在自主化上想想办法?数据需要存,接入AI模型需要网,部署AI模型需要终端。哪个不需要投入了!任何一个地方出现短板,就会出现木桶效

Python数据可视化,完整版实操指南 !闭眼入!!

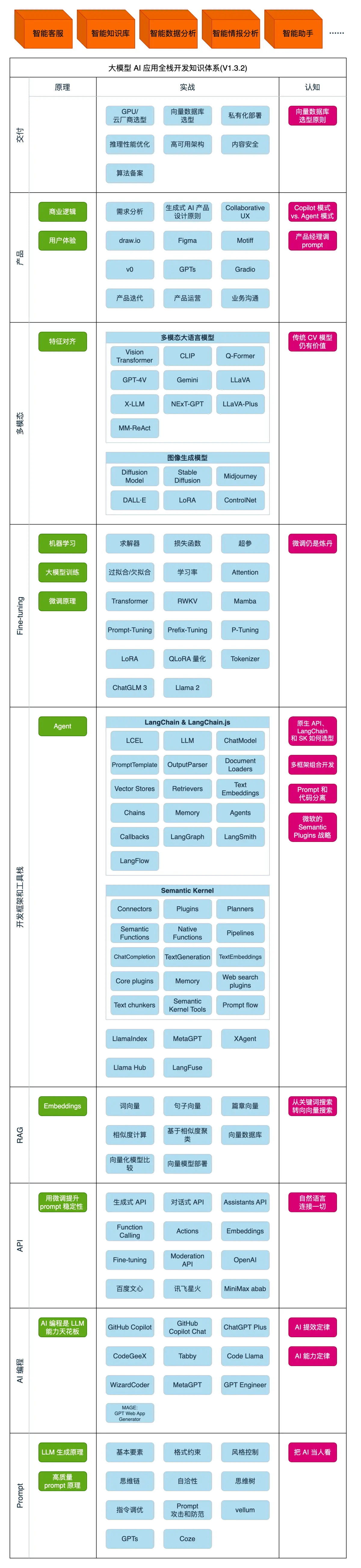

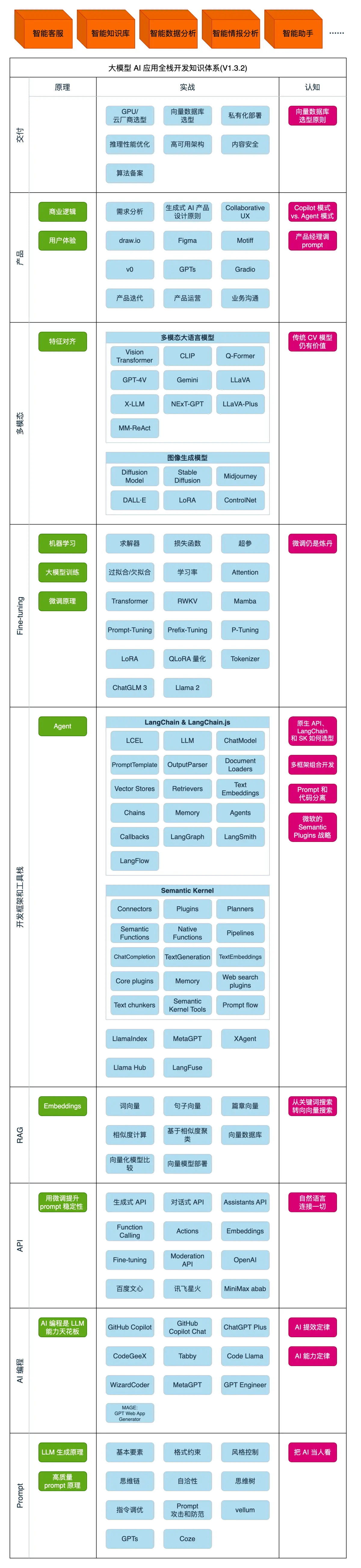

1、了解大模型能做什么2、整体了解大模型应用开发技术栈3、浅尝OpenAI API的调用AI全栈工程师:懂AI、懂编程、懂业务的超级个体,会是AGI(Artificial General Intelligence 通用人工智能)时代最重要的人。

1、了解大模型能做什么2、整体了解大模型应用开发技术栈3、浅尝OpenAI API的调用AI全栈工程师:懂AI、懂编程、懂业务的超级个体,会是AGI(Artificial General Intelligence 通用人工智能)时代最重要的人。

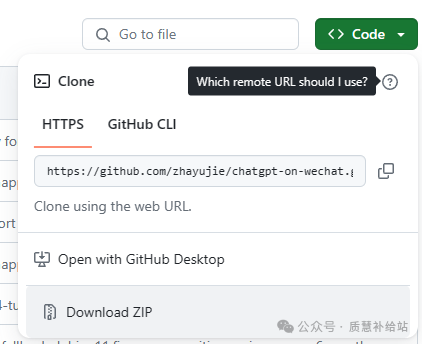

想象一下,你的微信群或公众号中,有一个AI问答专家随时待命,帮助你和你的朋友们解答各种问题,是不是很酷?首先,确保你有一个Python环境。这就像是我们的魔法工坊,所有的魔法都从这里开始。接着是我们的主角——chatgpt-on-wechat。这个项目就像是我们的魔杖,帮助我们在微信世界中施展魔法。我们需要连接到具有API接口的各种大型语言模型。你可以把它们想象成我们的魔法书,里面充满了知识和智慧

2023年,让整个人类最为振奋的AI技术就是ChatGPT。“大语言模型(Large Language Model)”这个词也随之映入人们的眼帘。ChatGPT让人觉得惊艳之处,能够结合上下文,像人一样有逻辑性地回答问题,就算生成超长的文本也不会跑偏。)是一种机器学习算法,它可以根据给定文本来预测下一个词语或字符的出现的概率,通过大量的文本数据来学习语言的统计特征,进而生成具有相似统计特征的新文本