简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这篇综述系统性梳理了强化学习(RL)在大型推理模型(LRM)领域的最新进展。研究表明,相比监督微调(SFT),RLVR(可验证奖励的强化学习)通过提供客观、可验证的奖励信号,能更有效提升模型的泛化推理能力。综述指出RLVR的三大关键要素:可验证奖励机制、无Critic优化算法和动态采样策略,并探讨了当前关于RL是否创造新知识的核心争议。最后提出了包括持续强化学习、基于模型的RL等九大未来研究方向,

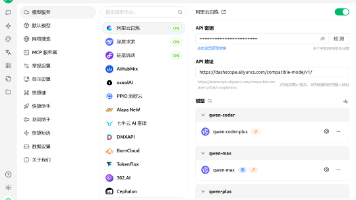

本文介绍了如何搭建本地MCP服务的完整流程。首先通过uv工具初始化Python项目并安装MCP包,然后使用FastMCP SDK开发了一个查询天气的MCP Server工具。文章详细演示了调试过程,包括使用MCP Inspector测试工具功能,以及通过Cherry Studio客户端连接本地MCP服务的配置方法。最后还展示了如何编写自定义MCP Client来连接本地MCP Server。整个流

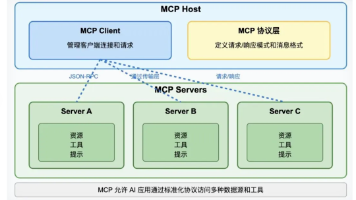

微软Teams通过MCP协议实现深度集成第三方应用,该协议优势主要体现在:1)统一接口标准,实现多端兼容;2)基于JSON-RPC 2.0协议,支持跨平台复用;3)协议层解耦设计,使模型与工具可独立迭代。这些特性打破生态壁垒,推动AI生态互联互通,实现"模型可换、工具可换、业务不换"的灵活协作。

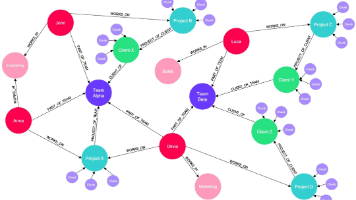

本文深入分析了GraphRAG技术如何突破传统RAG架构的瓶颈,提升企业级Agent的数据洞察能力。传统RAG虽能解决基础问答需求,但在处理复杂关系和全局性问题时存在局限。GraphRAG通过引入知识图谱技术,将非结构化数据转化为结构化认知,实现了从数据检索到推理洞察的质变。文章详细阐述了GraphRAG的技术原理、优势(如多跳推理能力、全局分析能力)以及面临的工程挑战(构建成本、图谱质量维护等)

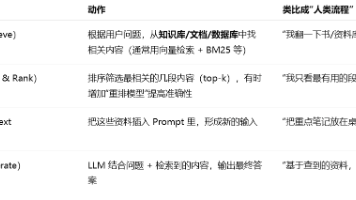

RAG(检索增强生成)摘要 RAG通过结合检索系统与大模型,实现了"先查资料再回答"的智能模式,有效提升回答准确性和可信度。本地部署大模型时,建议叠加RAG技术以获得更专业的领域知识响应。实现流程包括:语料准备→清洗分块→向量化→检索→重排→生成回答。 关键步骤: 收集整理代码/文档语料,按功能逻辑分块 构建本地向量库(FAISS)和BM25索引 混合检索策略(向量+关键词)获

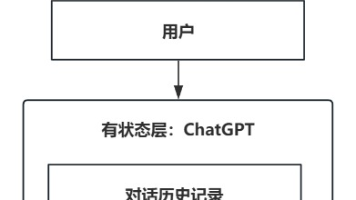

文章摘要: 本文探讨了应用从无状态到有状态的演变过程,重点分析了HTTP协议的无状态特性及其局限性。通过餐厅点餐的类比,解释了无状态和有状态系统的核心区别:前者处理独立请求,后者能记忆历史交互。文章指出,基础大语言模型(LLM)如GPT-3/4本质是无状态的,但通过上下文窗口管理、记忆存储等技术,上层应用(如ChatGPT)可实现有状态体验。有状态LLM适用于多轮对话、个性化推荐等场景,能提供更连

本文介绍了如何搭建本地MCP服务的完整流程。首先通过uv工具初始化Python项目并安装MCP包,然后使用FastMCP SDK开发了一个查询天气的MCP Server工具。文章详细演示了调试过程,包括使用MCP Inspector测试工具功能,以及通过Cherry Studio客户端连接本地MCP服务的配置方法。最后还展示了如何编写自定义MCP Client来连接本地MCP Server。整个流

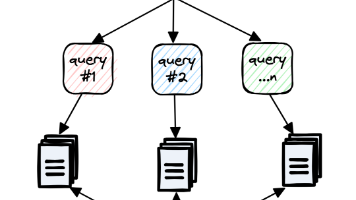

本文探讨了LLM系列中的Deep Research技术,分析了其从纯推理到研究型推理的演进过程。文章指出传统LLM存在信息过时和幻觉问题,而Deep Research通过模块化架构(包括查询分解、动态规划、信息检索和执行引擎)实现了更可靠的研究能力。详细比较了线性规划(CoT、Self-Ask)与多路径规划(ToT)方法的优劣,强调Deep Research通过主动审查外部信息、多步骤验证和自我批

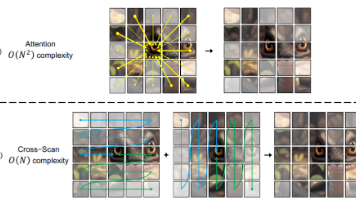

摘要 状态空间模型(SSM)作为一种新型架构,正在挑战Transformer在AI领域的地位。如Mamba和VisionMamba等模型已证明其在NLP和CV任务中的高效性。SSM采用线性计算复杂度机制,通过状态转移和输出方程处理序列数据,特别适合长文本处理。其关键创新在于利用零阶保持技术将离散信号连续化,并引入专家混合技术优化计算效率。相比Transformer,SSM在保持性能的同时显著降低了

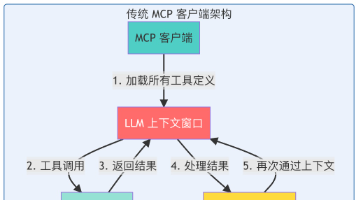

摘要:MCP代码执行优化方案显著提升AI Agent效率 Anthropic提出的Model Context Protocol(MCP)为解决AI Agent连接外部系统的性能瓶颈提供创新方案。传统工具调用方式面临两大核心问题:工具定义占用过多上下文空间(数十万tokens)和中间结果重复加载导致效率低下。通过将MCP服务器呈现为代码API,实现从"AI直接调用工具"到&quo