简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

用Deepseek R1模型构建自己的业务领域大模型

DeepSeek-V3以低成本和高通用性见长,适合广泛的应用场景,能够高效处理各种文本生成、摘要和对话任务。DeepSeek-R1通过强化学习实现了专业领域的推理突破,并在开源生态中提供了灵活的蒸馏方案,适用于推理密集型任务。

这篇文章,我将教大家如何在客户端接入OpenAI和DeepSeek V3在线模型进行对话。这套Client代码代码同样适用于接入其他LLM大模型,比如GPT 4O模型。

相比传统的pip,uv采用Rust编写,运行速度更快。无需virtualenv,可以直接使用__pypackages__进行管理。支持requirements.txt和pyproject.toml依赖管理。提供uv venv进行虚拟环境管理,比venv更轻量。支持Windows、macOS和Linux。

相比传统的pip,uv采用Rust编写,运行速度更快。无需virtualenv,可以直接使用__pypackages__进行管理。支持requirements.txt和pyproject.toml依赖管理。提供uv venv进行虚拟环境管理,比venv更轻量。支持Windows、macOS和Linux。

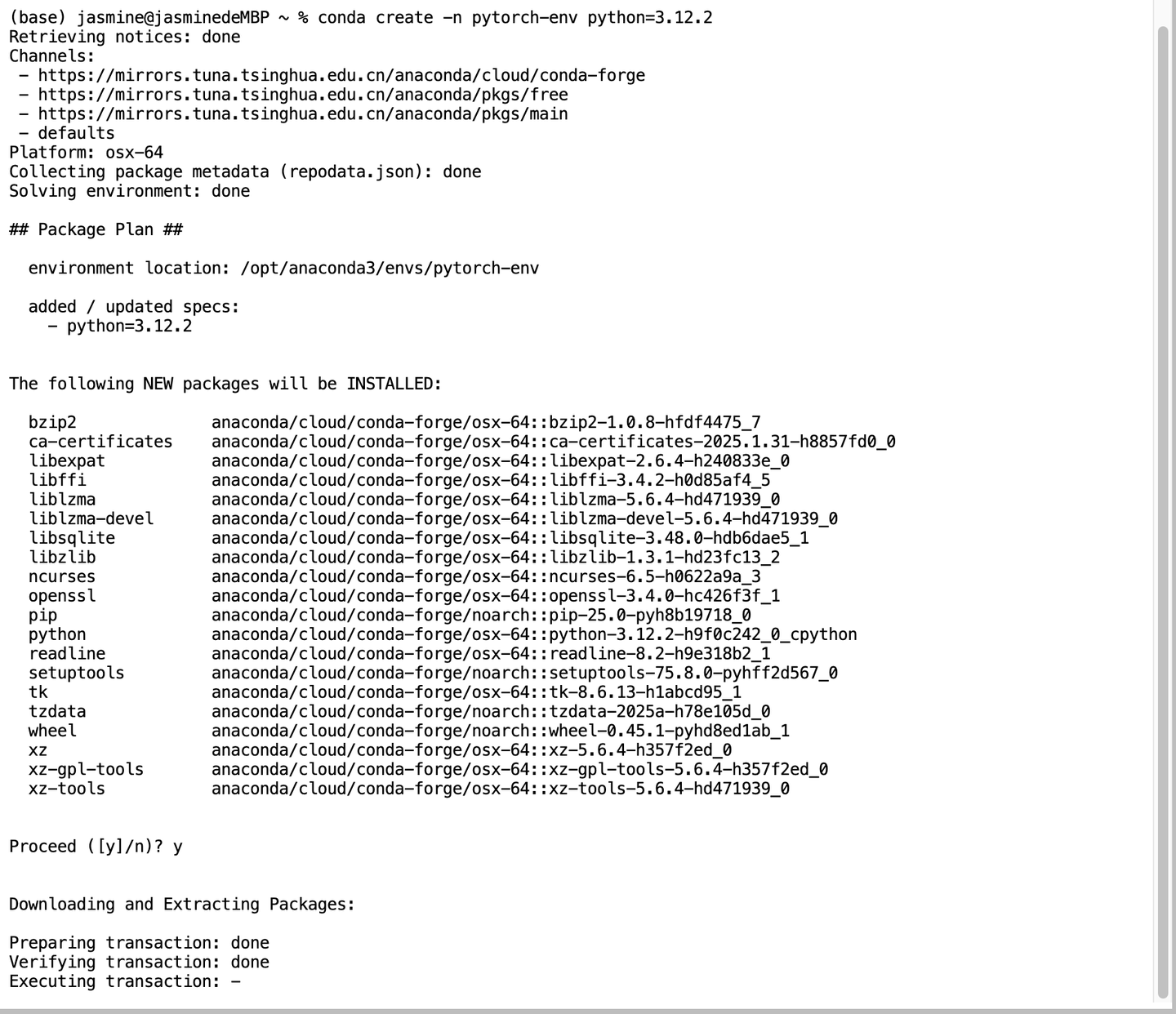

如果你的计算机上有 NVIDIA GPU,并且你希望加速深度学习计算,可以安装 GPU 版本的 PyTorch。我的电脑是M3 Mac Pro,虽然有GPU,但是不是NVIDIA GPU,如果要启用GPU的能力,需要从源代码编译PyTorch,并确保安装了必要的依赖项。为了更好的管理不同项目的Python项目,通常建议创建一个虚拟环境。可以隔离不同项目的依赖项,避免项目之间的冲突。安装 PyTor

由于我的电脑是M3 Mac Pro,虽然有GPU,但是不是NVIDIA GPU,如果要启用GPU的能力,需要从源代码编译PyTorch,并确保安装了必要的依赖项。下面我把详细步骤写下来,供各位参考。根据最新的信息,Mac M3 Pro可以安装支持GPU加速的PyTorch版本,但需要从源代码编译PyTorch,并确保安装了必要的依赖项。

DeepSeek-V3以低成本和高通用性见长,适合广泛的应用场景,能够高效处理各种文本生成、摘要和对话任务。DeepSeek-R1通过强化学习实现了专业领域的推理突破,并在开源生态中提供了灵活的蒸馏方案,适用于推理密集型任务。

这篇文章,我将教大家如何在客户端接入OpenAI和DeepSeek V3在线模型进行对话。这套Client代码代码同样适用于接入其他LLM大模型,比如GPT 4O模型。

用Deepseek R1模型构建自己的业务领域大模型