简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

整体伪代码如下初始化价值网络 V 和策略网络 pi对于 i 在范围 1500 内循环:# 通过自对弈收集数据环境重置()初始化根节点当未完成时循环:动作, 动作概率 = 玩家获取动作()# 通常在 get_action 函数中涉及 400 次选择和扩展。# 如果任何一次迭代达到游戏结束,更新 MCTS 节点的值。当前状态 = 下一状态将根节点移至当前状态的节点如果收集到的数据 > 批量大小:使用收

代码都是学习别人的,但我分享几点我踩过的大坑。1.蒙特卡洛的V值2.样本不是独立同分布之后再 详述一下""""""import torch.nn.functional as Fimport torchvision.models as modelsimport retroimport hiddenlayer as hlimport torch# import retroimport pandas a

import gymimport numpy as npimport matplotlib.pyplot as pltenv=gym.make("Blackjack-v0")observation=env.reset()print("观测={}".format(observation))while True:print("玩家={},庄家={},".format(env.player,env.de

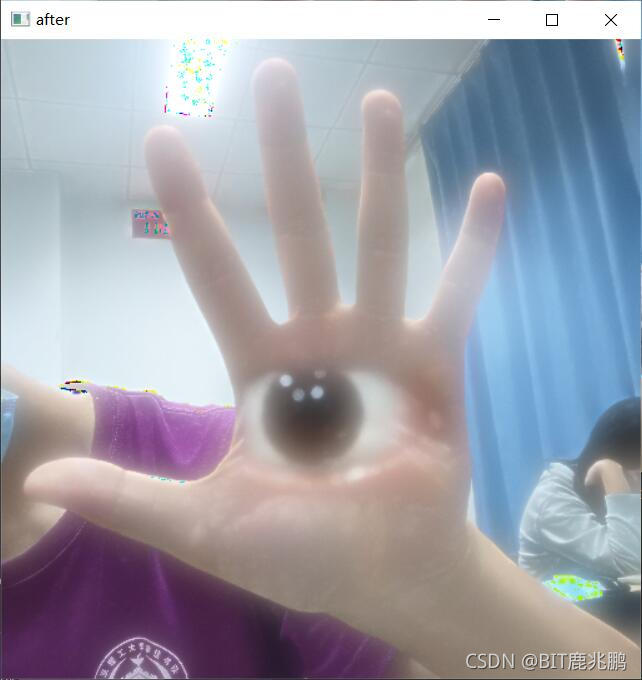

import cv2import numpy as npglobal imgglobal point1,point2global g_rectdef on_mouse(event,x,y,flag,param):global img, point1,point2,g_rectimg2=img.copy()if event ==cv2.EVENT_LBUTTONDOWN:print("1-EVENT

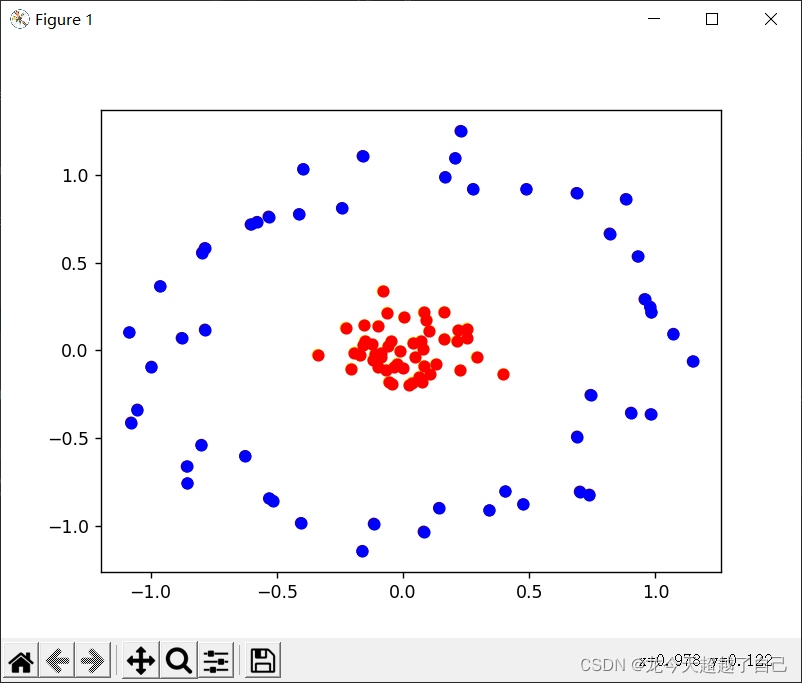

代码SMO部分参考书籍为《机器学习实践》首先,我们认识到SVM其实就是求一个最优(超)平面的过程,说svm有三宝,间隔,对偶,核技巧间隔就是说要求得的平面距离所有点间隔最大,这是一个最优化问题,可以用拉格朗日乘数法,解决。化为这个形式后,求它的对偶问题,求解的对偶问题的答案,按照以下公式反推到原问题的答案两种常用的求解算法:1.SGD将原问题转变为一个最小损失函数的问题,用梯度下降的方法,优化参数

方法:1.wget ‘网址’网址在这里找,动作讲究一个快准狠,慢了链接就失效了

第一次用商汤的mmdetection,遇到很多错误mmdetection中网络的配置文件缺东西,至少缺了log_level参数的值

import mathx=[[0,1,"no"],[0,1,"no"],[1,0,"no"],[1,1,"yes"],[1,1,"no"],[1,1,"no"],[1,1,"maybe"],[1,1,"maybe"],[1,1,"maybe"]]# x=[[0,1,"no"],[0,1,"no"],[1,0,"no"],[1,1,"yes"],[1,1,"yes"],]def majorityCn

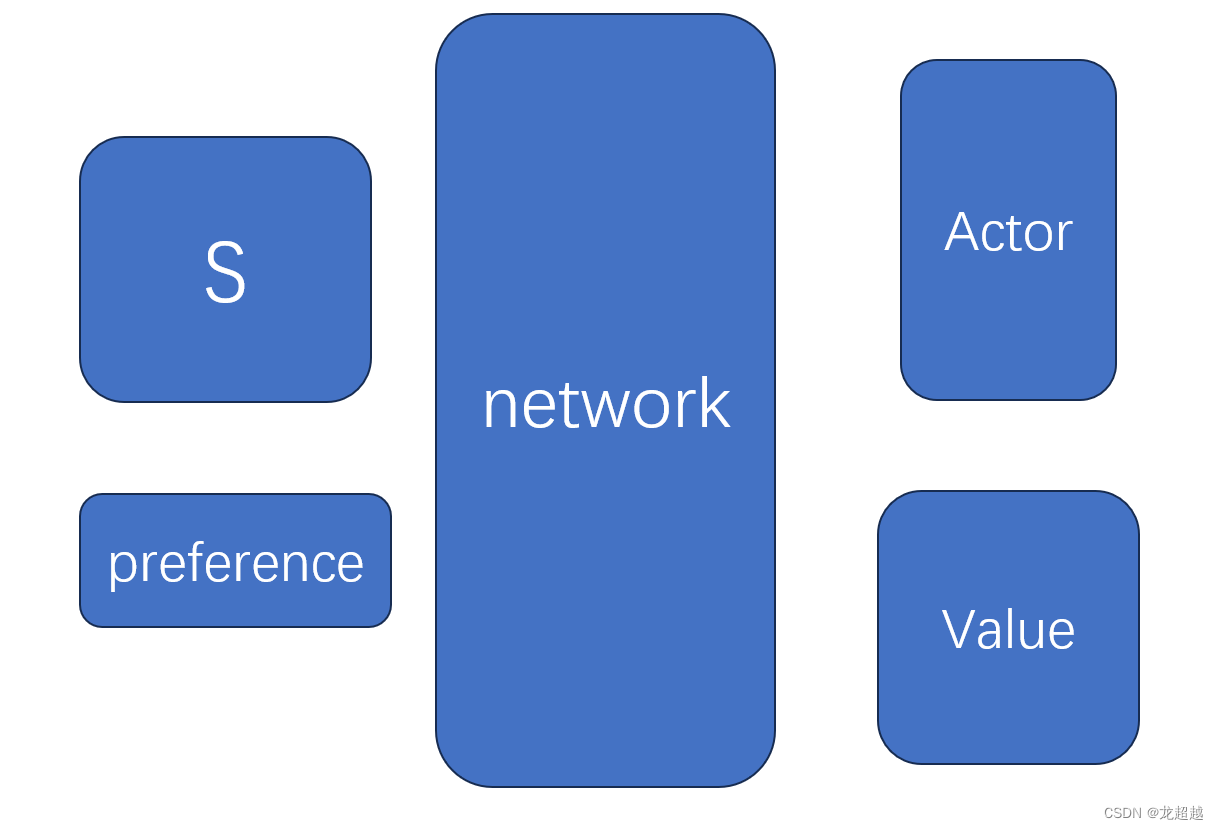

这一部分就很明了了,计算前面提到的几种loss,给与不同权重后反向传播,唯一特别注意的是,actor loss中使用的优势adv,不知出于什么理由,使用了优势向量与偏好向量做内积后的偏好,(可能是因为解唯一,优化方便)虽然论文中用的是Q-learning的架构,但是在提供的代码中,采用的是A3C的架构,使用envelope 网络作为价值网络,估计状态价值用于更新,所以接下来以代码为准,结合论文思想